Negli ultimi giorni ci è capitato di parlare spesso della ciclicità di molte dinamiche climatiche e del loro concorrere a determinare condizioni generali del sistema anche molto diverse tra loro, specie a scala spaziale regionale e per periodi di tempo relativamente brevi in senso climatico.

Una discussione latente e ricorrente, che ha ripreso vigore con la pubblicazione dell’ultimo paper di Judith Curry, The Stadium Wave. Oggi torniamo a parlare di clima in termini non globali ma emisferici, focalizzando l’attenzione su un pattern atmosferico di particolare importanza per il continente europeo e, quindi, anche per il nostro territorio. Si parla della NAO (North Atlantic Oscillation), ovvero di quell’indice circolatorio derivato dalla differenza tra i valori della pressione atmosferica alla latitudine delle Azzorre e quelli alla latitudine dell’ISlanda. La NAO, come sanno bene tutti quelli che si sono per diverse ragioni avvicinati alla meteorologia, è il metronomo del tempo sull’Europa. Infatti esprimendo di fatto la relazione di forza tra due configurazioni bariche permanenti come l’Anticilone delle Azzore e la Depressione d’Islanda, esprime anche l’intensità e la posizione del gradiente che le separa, e quindi anche il flusso atmosferico nel quale viaggiano le perturbazioni che dall’Atlantico si dirigono verso l’Europa. Con una NAO negativa (anticiclone debole), le perturbazioni aumentano la oro frequenza sul Mediterraneo, portando con se aria umida e temperata. Con una NAO positiva (anticilone robusto ed elevato gradiente) le perturbazioni tendono invece a ‘preferire’ il nord Europa.

Ora l’indice NAO possiede una variabilità che si esprime a diverse scale temporali, sia quella breve, più tipicamente meteorologica, sia quelle di medio e lungo periodo, più direttamente ascirvibili alla variabilità stagionale, interannuale e climatica. Del resto si tratta di un pattern atmosferico, di una derivata della circolazione atmosferica, ossia del mezzo attraverso il quale viene redistribuito il calore sul pianeta, per cui è intuitivo comprenderne il ruolo e l’importanza.

Appena qualche giorno fa, è stato accettato per la pubblicazione sul GRL un paper dal titolo molto interessante:

NAO Implicated as a predictor for Northern Emisphere mean temperature multidecadal variability – Li et al., 2013 (qui il pdf)

Abstract

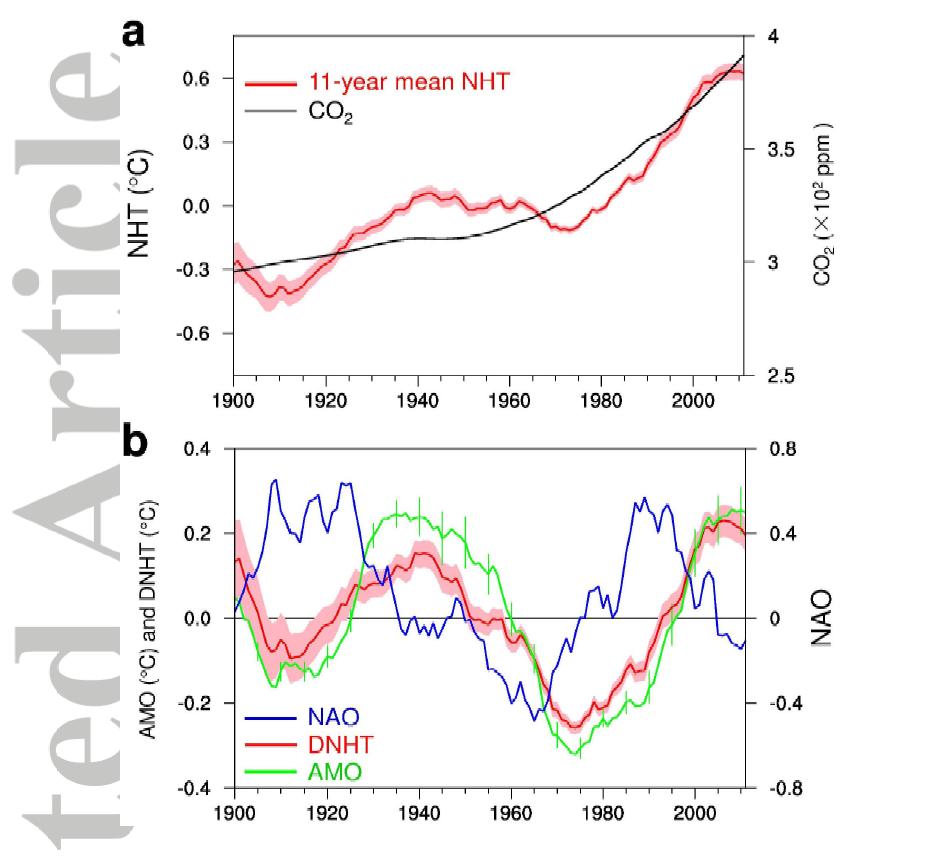

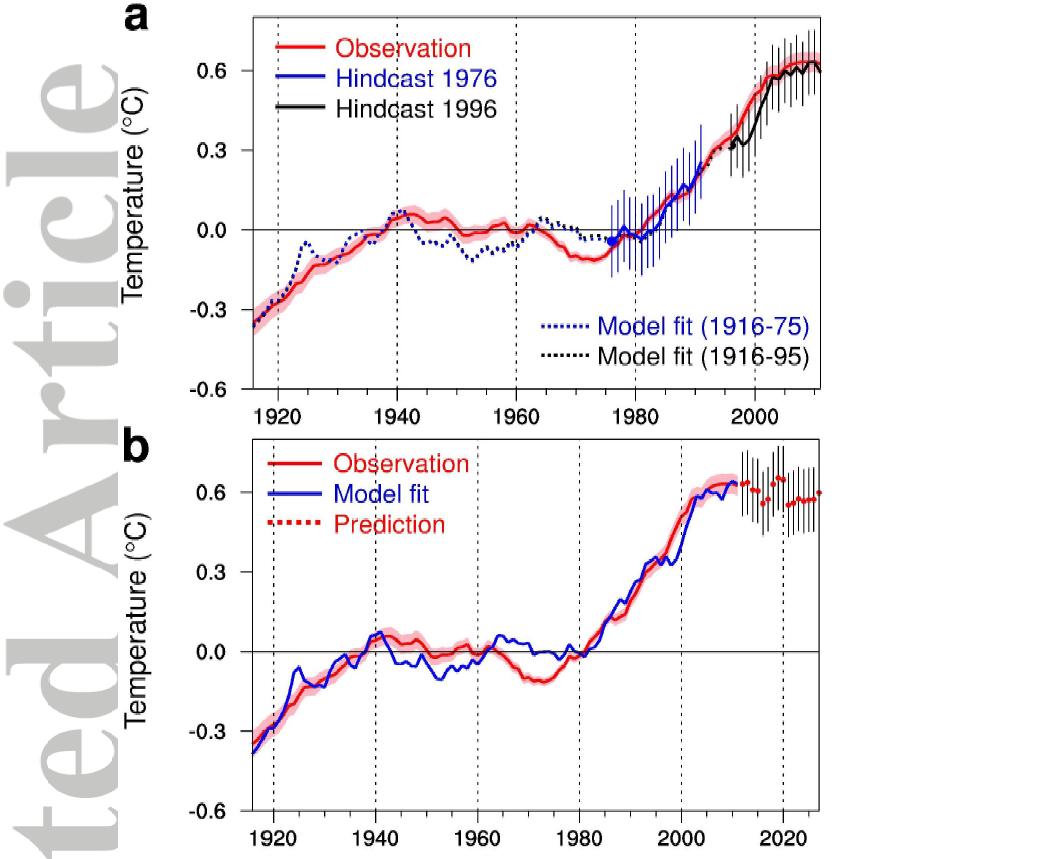

La temperatura media superficiale dell’Emisfero Nord (NHT) è caratterizzata da un pattern multidecadale di riscaldamento-raffreddamento-riscaldamento seguito da un trend piatto (il recente iato del riscaldamento). Si dimostra che la North Atlantic Oscillation (NAO) è utilizzabile come efficace predittore della variabilità multidecadale dell’NHT. L’analisi delle osservazioni mostra che la NAO precede sia l’NHT privata del trend che l’Atlantic Multidecadal Oscillation (AMO) di circa 15-20 anni. L’analisi teorica chiarisce che la NAO precede la variabilità multidecadale dell’NHT attraverso il suo effetto ritardato sull’AMO per effetto dell’ampia inerzia termica associata con i lenti processi oceanici. Si definisce pertanto un modello lineare basato sulla NAO per prevedere l’NHT, modello che fornisce un eccellente ricostruzione dell’NHT per il periodo 1971-2011, con il recente trend piatto ben riprodotto. Si prevede che l’NHT nelle prossime decadi del periodo 2012-2027 diminuisca leggermente a causa del recente indebolimento della NAO, con temporaneo mascheramento del riscaldamento antropogenico.

Sicché, a parte la frase di rito con cui si conclude l’abstract che ha lo scopo di tranquillizare il mainstream, questo lavoro fornisce una interessante interpretazione dell’andamento delle temperature dell’emisfero nord nell’ultimo secolo, cogliendo anche l’attuale fase di stasi delle temperature. Registriamo quindi un altro lavoro soggetto a referaggio in cui non si crede affatto che le temperature medie superficiali possano tornare ad aumentare molto presto e, soprattutto, che teorizza che una parte consistente delle loro oscillazioni sia dovuto a dinamiche naturali. Circa il trend di lungo periodo poi, se si accetta tout-court che con riferimento alle ultime decadi del secolo scorso abbia prevalso la componente antropica, resta sempre da spiegare cosa lo abbia generato quando questa non era neanche lontanamente paragonabile a quella attuale. Del resto, gli stessi autori non escludono, anzi scrivono chiaramente, che la NA e i processi da loro descritti, possono essere affiancati anche da altri fattori di forcing, quali le dinamiche solari, la concentrazione di aerosol etc. Sicchè, tolta la componente NAO, tolte le dinamiche naturali di lungo periodo, quanto resta alla CO2 ed ai suoi derivati in termini di capacità di indurre riscaldamento? Temo poco, molto poco.

E ci sarebbe infine un’altra riflessione da fare. Gli autori parlano di indebolimento della NAO, ovvero della sua tendenza ad assumere valori negativi, quelli a cui in apertura abbiamo detto essere solitamente associata una direttrice delle perturbazioni atlantiche più bassa di latitudine o, se credete, un fronte polare più basso di latitudine. Ciò starebbe a significare, senza voler fare alcuna previsione di dettaglio perché sarebbe assurdo e speculativo, che aumentano le probabilità di eventi precipitativi e, per la legge dei grandi numeri, anche quelle di eventi di una certa intensità, che sarebbero però accompagnati da una diminuzione delle temperature medie, e non dal suo opposto, con buona pace (per l’ennesima volta) del teorema riscaldamento globale=eventi intensi. Al contempo, sempre con un fronte polare mediamente più basso, si riducono anche le probabilità di frequenti incursioni dell’anticiclone sub-tropicale verso le medie latitudini mediterranee, e questo, sebbene indirettamente, lo lasciano intendere anche gli autori, quando associano alla modalità tendenzialmente negativa della NAO una posizione mediamente più meridionale dell’ITCZ, ossia della zona di convergenza intertropicale.

Infine, per tornare al titolo di questo post, se sull’attendibilità del modello presentato in questo paper è giusto sospendere il giudizio, sulla sua verificabilità non ci sono dubbi, basta aspettare qualche anno.

[…] nei carotaggi del Mar di Kara (debole, 65.8 anni, Darby et al.,2012); il lavoro di Li et al.,2013 (qui su CM) porta ancora allo stesso periodo; Wyatt e Curry,2013 (qui su CM) arrivano allo stesso valore […]

L’articolo di Li et al. 2013, mi è piaciuto molto in quanto, pur molto breve, riesce a schematizzare in modo estremamente chiaro ed anche piuttosto convincente un fenomeno molto complesso e le cui implicazioni sono estremamente importanti.

La cosa che mi ha maggiormente interessato è l’andamento ciclico dell’indice DNHT (temperature del nord emisfero depurate del trend antropico) individuato dagli autori, correlato al 98% con l’indice AMO! Ebbene, questo indice presenta un periodo di 60 anni: ancora una volta il periodo fondamentale del prof. N. Scafetta!

In un precedente commento al lavoro di Wyatt et al. 2013, ebbi modo di scrivere che avevo il presentimento che avremo parlato spesso di questo numero. Ero stato fin troppo facile profeta 🙂 in quanto, a circa, una settimana di distanza e, quindi, oltre ogni più rosea aspettativa, ecco rispuntare il fatidico numero 60. A questo punto è opportuno fare qualche considerazione. Tre lavori (almeno tanti sono quelle che conosco io che, ricordo a me stesso 🙂 , NON sono un climatologo o un fisico dell’atmosfera) indipendenti portano allo stesso risultato. Non ho sotto mano il paper di Wyatt et al., ma in quello di Li et al. Scafetta non è citato neanche nella bibliografia, per cui le metodologie utilizzate mi sembrano del tutto diverse, eppure questo periodo di 60 anni emerge chiaramente dai dati. I grafici de-trendizzati (orrendo neologismo 🙂 ) dimostrano chiaramente, infatti, che AMO e DNHT (oltre che NAO) hanno un periodo di 60 anni (non serve neanche lo spettro delle potenze 🙂 ).

N. Scafetta attribuisce a questo periodo un significato astronomico, Li et al., invece, non dà alcuna spiegazione fisica del fenomeno (ad essere sinceri non cita neanche il periodo di 60 anni) limitandosi ad osservare che a 40 anni di raffreddamento, a partire dagli anni ’40 del secolo scorso, sono seguiti 20 anni di riscaldamento, fino agli anni duemila di questo secolo, e azzarda solo una spiegazione, piuttosto oscura, riferendosi a non meglio precisate “anomalie nei flussi di calore superficiali turbolenti” che interessano l’oceano Atlantico settentrionale ed in particolare il Mare del Labrador. Detto in questo modo sembrerebbe che un fenomeno caotico (flussi turbolenti) nasconda un periodo, una regolarità ben precisa, per dirla con J. Curry.

Altra considerazione riguarda la successione temporale degli eventi: NAO determina AMO e, quindi, le SST, che a loro volta, determinano le temperature atmosferiche. In altri termini il Nord emisfero si è scaldato a seguito dell’aumento delle SST e, quindi, per effetto del calore ceduto all’atmosfera dagli oceani: sembra facile, ma non tutti sono d’accordo con questo meccanismo logico dal punto di vista fisico in quanto presuppone che siano gli oceani a guidare le oscillazioni del clima terrestre e, quindi, le temperature medie superficiali.

Altra considerazione riguarda le temperature negli anni ’40 del 20° secolo. Secondo alcuni quell’incremento è frutto di un errore sistematico legato al modo in cui nel periodo bellico veniva determinata la temperatura superficiale del mare. I diagrammi postati da G. Guidi dimostrano che proprio a cavallo del 1940 vi è stato un massimo del DNHT che dimostrerebbe qualcosa di più di un semplice errore sistematico.

E con questo mi fermo perché il commento è stato già “eccessivamente lungo ed inutilmente prolisso”. 🙂

Ciao, Donato.

Donato, prolissità a parte, sappi che oggi nell’aia il paper di Wyatt e Curry è stato naturalmente sbeffeggiato, mentre si sono levati gli osanna su altro paper, che avrebbe scoperto che

in Olandaa Stoccolma, area notoriamente invivibile causa caldo, è passata a miglior vita più gente per il caldo e (lo so che fa ridere) per il freddo, di quanta ne sarebbe trapassata senza AGW. Ovviamente, con più morti di afa che di gelo.Ad ogni modo, visto che di aia si parla, ormai trattasi di uova ibride, non fanno pulcini. Che curioso contrappasso.

gg

Tutto ciò che va controcorrente (rispetto all’ipotesi di CAGW) non va ASSOLUTAMENTE bene: avendo i pennuti compreso i fondamenti fisici della climatologia terrestre, possono permettersi di sbeffeggiare chiunque (climatologi, fisici, ingegneri, meteorologi, agronomi, geologi, ecc. ecc.) non abbia compreso come loro. 🙂

A breve sbeffeggeranno anche Li et al, 2013 (nonostante le frasi salvavita sul mascheramento del CAGW).

Per il resto, solo ordinaria amministrazione: mezze frasi, allusioni, rimandi a questo o quello, prosa criptica e per iniziati. Buona, comunque, per sentire l’altra campana.

.

p.s.:

Noto di essere entrato a pieno titolo nella tua troupe e, più in generale, nella squadra dei ciclisti: farò il meccanico. 🙂

Ciao, Donato.

Guido, prima che se ne accorgano i pennuti un avviso: il paper dei morti per il caldo riguarda Stoccolma non l’Aia. 🙂

Peggio che andar di notte.

Ciao, Donato.