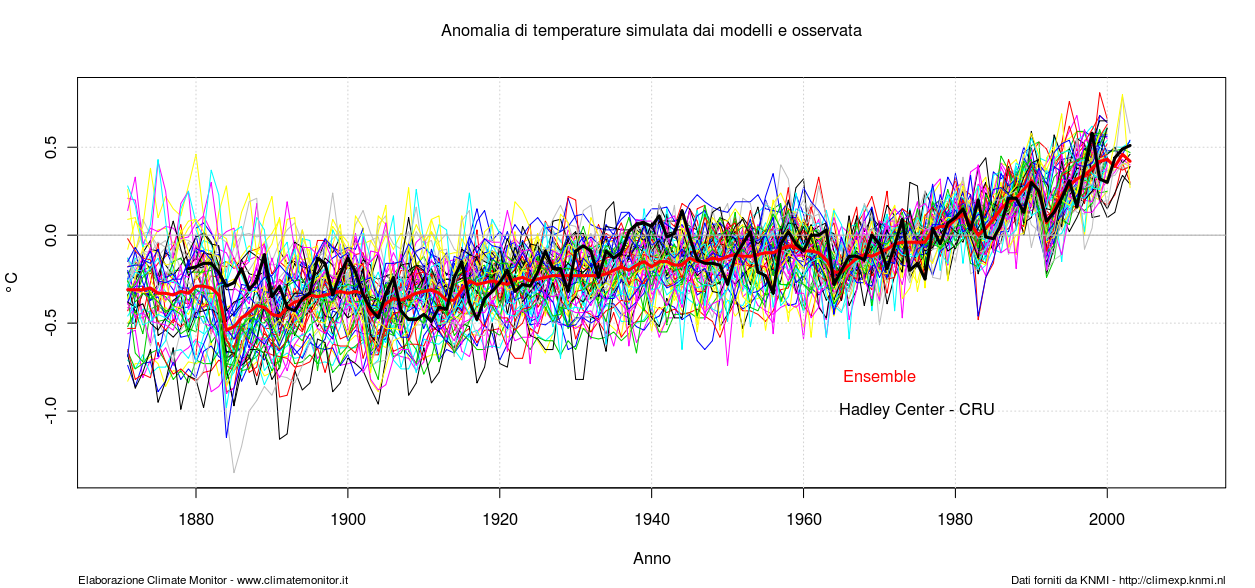

A pagina 600 del documento finale del Working Group 1 (WG1)1, quarto rapporto 2007 dell’IPCC (AR4), è riportato questo grafico.

E ciò che segue è quanto riportato nella didascalia:

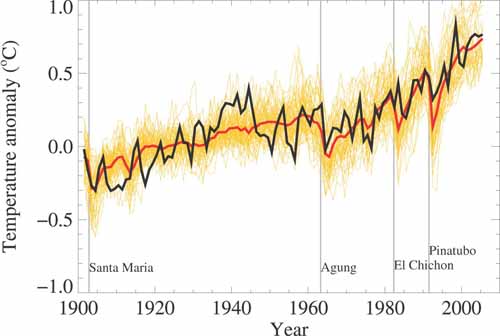

FAQ 8.1, Figure 1. Global mean near-surface temperatures over the 20th century from observations (black) and as obtained from 58 simulations produced by 14 different climate models driven by both natural and human-caused factors that influence climate (yellow). The mean of all these runs is also shown (thick red line). Temperature anomalies are shown relative to the 1901 to 1950 mean. Vertical grey lines indicate the

timing of major volcanic eruptions. (Figure adapted from Chapter 9, Figure 9.5. Refer to corresponding caption for further details.)

E’ evidente il refuso nella didascalia, dalla quale nel primo periodo è sparita la parola anomaly.

Nel provare a ricostruire il grafico, non ho cercato di capire quali fossero i 14 modelli usati, ma ho adoperato tutti i 23 modelli riportati nella tabella a pag. 597-599 del rapporto del WG1; ognuno di essi ha un diverso numero di membri dell’ensamble, per un totale complessivo di 72 diverse realizzazioni.

I dati usati per i grafici di quest’articolo sono disponibili per chiunque ne faccia richiesta e sono stati scaricati il 26 luglio 2009 dal sito Climate Explorer del KNMI, il servizio meteorologico dei Paesi Bassi.

Claudio Gravina ha trattato i dati con R; la riproduzione del grafico riporta le 72 diverse simulazioni, la stima delle osservazioni dell’UKMO/Hadley Centre – CRU (HADCRUT in nero) e l’ensamble mean (rosso). La linea gialla evidenzia una delle corse di uno dei modelli climatici dell’UKMO, il servizio meteorologico del Regno Unito. Le anomalie sono calcolate rispetto al periodo 1961-1990 e non al periodo 1901-1950, utilizzato in origine, e sono riportate su di un periodo più esteso, dal 1870 al 2000 circa.

Questa figura, o quella originale del WG1, è una delle icone che meglio rappresenta la teoria del riscaldamento globale da gas serra e ne è, forse, la quintessenza.

A dire dei proponenti2:

“The fact that climate models are only able to reproduce observed global mean temperature changes over the 20th century when they include anthropogenic forcings, and that they fail to do so when they exclude anthropogenic forcings, is evidence for the influence of humans on global climate3.“

Il recente aumento della temperatura superficiale è, dunque, diretta conseguenza dell’aumento della CO2 & c. Non riuscendo a riprodurre tale andamento in altro modo, i gas serra sono l’unica spiegazione, o quasi. A parte le falle di un tale ragionamento (il)logico, occorre, come dire, una buona dose di tolleranza, di compromesso col processo scientifico, per dichiarare accettabile una tale ricostruzione. Dove c’è fede, c’è speranza!

Io, però, non voglio parlarvi della bontà o meno della ricostruzione dell’anomalia di temperatura superficiale rispetto ad un clima di riferimento, perchè pur essendo questo un argomento interessante e già molto dibattuto desidero piuttosto andare alla radice della questione.

I modelli numerici dell’atmosfera o dell’oceano e di ogni loro accoppiamento più o meno decente, non trattano l’anomalia ma, e non potrebbe essere diversamente, calcolano la temperatura, ovvero quella semplice variabile meteorologica che siamo in grado di misurare con un termometro.

Vengono calcolati valori di temperatura sia della superficie del terreno sia sui livelli verticali atmosferici di cui è composto il modello. Dal livello del suolo o dai livelli atmosferici più bassi è ricavata, in qualche maniera, la temperatura a 2 metri, quella che siamo abituati a misurare nelle capannine meteorologiche. Del resto non è l’anomalia ma il campo tridimensionale della temperatura assoluta l’unica variabile che ha senso fisico.

Il calcolo della temperatura superficiale atmosferica non è, dunque, un’operazione semplice e diretta del modello; tecnicamente si dice che non è una variabile “prognosticaâ€, ma è pur sempre guidata dalle conoscenze fisiche dello strato superficiale dell’atmosfera. A dirla completamente, io non so come i modelli climatici facciano il calcolo della temperatura superficiale (quella a 2 metri), ma, nei modelli atmosferici per le previsioni meteorologiche, il metodo è quello descritto. La temperatura superficiale dell’oceano, invece, dovrebbe essere calcolata direttamente dal modello dell’oceano e non dalla componente atmosferica.

Bene, una volta che abbiamo capito che la cosa è complicata, che i vari centri di ricerca forniscono una variabile “temperatura atmosferica superficialeâ€, a quel punto mediamo su tutto il globo, anno per anno et voilà , ecco il risultato4:

Dopo aver guardato la figura per un po’ di tempo, per caso, avete adesso l’impressione di non capire più in che mondo avete vissuto finora? Tranquilli, tutto normale, è una reazione normale!

La prima domanda propedeutica è: “Qual è la temperatura atmosferica superficiale, mediata nel corso di un anno e su tutto il globo?â€

A tal proposito, si legga quello che ha da dire James Hansen del NASA/GISS, che spiega che il calcolo non è facile e la media globale non è proprio misurata ma stimata. In genere si accetta un valore di 14°C, mezzo grado in più o in meno.

Presa per buona una temperatura pari a 14°C, il grafico qui sopra mostra che i modelli usati per l’AR4 stimano un valore medio che secondo le simulazioni, varia tra 12 e 17 gradi. Ricordando che tutte le tragedie climatiche degli ultimi decenni sarebbero state causate da variazioni di alcuni decimi di grado, che dire di un mondo la cui temperatura media del recente passato è stata di 17°C ? E quello in cui buona parte del XX secolo ne ha avuti 12 ? In effetti, non so che mondi fossero e di sicuro non era il pianeta Terra in cui sono nato e vissuto finora. Nel battere la grancassa del catastrofismo climatico si sente continuamente parlare di sconvolgimento degli equilibri del clima. Posto che il clima non è mai stato in equilibrio, si può sapere che genere di simulazione è quella rappresentata dalla media di modelli che rappresentano sistemi così distanti tra loro? Dove sarebbero le condizioni di equilibrio?

Cerchiamo di capire se la mia affermazione è esagerata. La temperatura superficiale di questo pianeta dipende, in buona approssimazione, dalla temperatura superficiale dell’oceano. Se la simulazione ha 2 o 3 gradi di differenza, stiamo parlando di un altro oceano con scambi di energia tra di esso e l’atmosfera di un livello diverso rispetto a quelli che conosciamo, sempre che anche la temperatura in tutta la verticale sia stata simulata correttamente.

A pensarci bene questo potrebbe essere l’oggetto di un prossimo approfondimento: indagare se il profilo verticale dell’atmosfera sia coerente con una temperatura superficiale ad esempio di 17°C o se i gradienti risultino alterati, cioè se prevedano che il trasporto del calore lungo l’asse verticale avvenga secondo processi fisici simili a quelli che conosciamo, se cambiano le proprietà di convezione e conduzione della miscela dei gas atmosferici ad esempio. In ogni caso, il flusso di energia (calore sensibile e latente) da un oceano tanto caldo è immaginabile che sia diverso da quello che si avrebbe da un oceano di ben cinque gradi più freddo, per non considerare il flusso radiativo verso lo spazio siderale. Se, invece, la temperatura superficiale dell’oceano fosse simulata correttamente, allora tutto l’errore sarebbe concentrato nel rimanente 29% delle terre emerse. Se prendiamo per buona la simulazione di una temperatura media globale pari a 17°C, questo significherebbe che la temperatura media annua di Bologna dovrebbe essere di 23° e non di 13.6° come in effetti è.

Domanda retorica: la Bologna che conosco io, quella con 13.6°C di temperatura media annua, sarebbe proprio uguale se ce ne fossero 23? Perchè quella è la temperatura media che a Bologna si registra tra il 21 ed il 30 giugno. In pratica, una Bologna eternamente a fine giugno! Che bella simulazione!

Andando oltre il proprio cortile bolognese, la temperatura superficiale, come direbbero gli inglesi, matters, cioè conta. E come se conta! Tanto per capirci, il valore di temperatura pari a zero divide due mondi molto diversi, da una parte il ghiaccio, dall’altra l’acqua liquida. Nel mondo a 12°C, dove si posizionerebbe il limite delle nevicate e dei ghiacci marini? Nella stessa posizione del mondo a 14°C? Mi verrebbe da dire di no. Non cambierebbero l’albedo delle superfici ghiacciate, il contributo di acqua dolce negli oceani e la disponibilità idrica sul resto del pianeta tanto per cominciare? Un altro mondo, insomma. E spunti per nuovi articoli.

Se poi anche i ghiacci polari fossero nella stessa posizione, allora i gradienti orizzontali di temperatura sarebbero molto più accentuati di quelli reali, con i poli molto più freddi di quanto non sia. E poi vedi che tempeste si scatenerebbero alle medie latitudini con quelle energie potenziali a disposizione. Anche in questo caso, un altro mondo. Stesso discorso se si prendesse in considerazione il mondo a 17°C, dove le arance si coltiverebbero in Scandinavia e non più a Catania.

“Bevete tutti una spremuta di arance rosse di Göteborg.†Suona bene come reclame?

Alla fine di questa storia, c’è un qualcosa che mi lascia dubbioso. La prima reazione potrebbe essere quella di dire che questa è una questione di serietà . Come si fa a consentire che passino il rigoroso processo di validazione scientifica dei modelli che fanno svarioni di questo tipo nel simulare quella variabile fondamentale alla base di tutta l’ipotesi AGW che è la temperatura superficiale? La cosa mi sembra troppo grossa e aumenta il dubbio che, nella mia ignoranza patentata, mi stia sfuggendo qualcosa, che stia dando importanza a qualcosa che non la richiederebbe.

Prima di giungere alle conclusioni, sento la necessità di ascoltare ciò che avrebbe da dire chi ha ampia conoscenza della modellistica climatica. Sento che hanno una risposta. E mi piacerebbe tanto conoscerla.

- Working Group 1 – Scientifical Basis [↩]

- vedi Capitolo 9.5 del WG1 [↩]

- Il fatto che i modelli climatici siano capaci di riprodurre le variazioni della temperatura media globale osservata nel corso del XX° secolo soltanto quando includono dei forcing antropogenici, e che non riescano a farlo quando escludono i forcing antropogenici, rappresenta l’evidenza dell’influenza dell’uomo sul clima globale [↩]

- R – Elaborazione dati a cura di Claudio Gravina [↩]

![Reblog this post [with Zemanta]](http://img.zemanta.com/reblog_e.png?x-id=274679dd-4c7a-45cd-901b-582864243d75)

[…] del passato ottenute dai modelli climatici non lo colgono, cosa di cui si era già trattato in questa discussione di alcuni mesi fa. E se il modello non ci prende, ciò che ne risulta è un’ammissione di […]

[…] nell’ultimo rapporto (AR4) del 20071. Nella discussione di allora, che invito a rileggere qui , era stato spiegato il perché i modellisti e l’IPCC2 presentano solo i grafici dell’anomalia […]

http://www.pensee-unique.fr/courtillot3.pdf

J.-L. Le Mouël et al., Evidence for a solar signature in 20th-century temperature data from the USA and Europe, C. R. Geoscience (2008), doi:10.1016/j.crte.2008.06.001

Ci dicono che facendo le medie regionali minime e non globali massime si evince una stretta corelazione tra temperature e flusso solare,(magnetic field components) mentre con le medie globali che usa l’IPCC questo non si riesce a vedere.

Caro Guido,

sul trend del vapor d’acqua ho letto tante altre cose, che dicono anche qualcosa di diverso talvolta (ho scelto a caso: ad esempio guarda e dai un occhio alle conclusioni: Analysis of global water vapour trends from satelleite measurements in the visible spectral range” di S. Mieruch, S. Noel, H. Bovensmann, and J. P. Burrows – Atmos. Chem. Phys., 8, 491–504, 2008 – http://www.atmos-chem-phys.net/8/491/2008/ -si scarica dal web)

Questo solo per dire che la faccenda del monitoraggio del vapor d’acqua è un tantino complicata (poi ci si mette anche elNino a complicare le cose…). E poi i dati ci sono se va bene da metà degli anni ’80, qui stiamo cercando dei trend su 100 anni…

Quanto al commento di Paolo, che dire: ho già detto dell’importanza della temperatura, del perchè pero’ le anomalie sono rilevanti, spiegandone le motivazioni…

Non sono quindi in grado di aggiungere altro che non abbia già detto. Quanto all’aerosol, non ho mai creduto alla magia e mi sa che fare “magie” sia un po’ complicato, su queste materie…

Grazie Carlo, lo leggerò con interesse. 😉

gg

Cari amici,

vi inoltro un commento che ho ricevuto da Paolo, impegnato in ludiche attività ed impossibilitato ad accedere ad una connessione decente. Ambasciator non porta pena 🙂

“I problemi posti da questo articolo non hanno avuto risposta nei commenti di Carlo Cacciamani.

1) L’acqua non è invariante alla temperatura assoluta;

2) L’albedo di questo pianeta, che dall’acqua è determinata, non è altrettanto invariante rispetto alla T assoluta;

3) L’energia emessa per via radiativa da ogni molecola della nostra atmosfera e dalla superficie del pianeta dipende dalla QUARTA potenza della T assoluta;

4) In definitiva la fisica di questo pianeta è determinata non da un’anomalia o da un trend dell’anomalia ma, meramente, dalla T medesima!

5) Se i modelli non ci “pigliano” in qualcosa di così fondamentale, è logico pensare che la loro uniformità nell’andamento del trend sia garanzia di bontà ? Nè tantomeno

ne è garanzia la coerenza intrinseca. Se l’ipotesi “modello climatico” ha qualcosa di sbagliato, esso sarà sempre e soltanto “coerentemente sbagliato”.

Visto che la discussione ha preso la piega dell’uniformità e della corenza, ma vi prego di concentrarvi sui temi dall’1 al 4, a correzione di quanto detto, la “sensivity” di ciascun modello ad un raddoppio della CO2 & c. è tutt’altro che uniforme. In virtù dei vari processi di feedback, diversi in ciascun modello, ogni

modello ha il suo valore di sensivity. La cosa stupefacente è che, nel ricostruire l’anomalia del XX secolo, l’andamento è, quello sì, uniforme. Su questo argomento è stato pubblicato un articolo da parte di un noto autore “mainstream” ma che è stato velocemente dimenticato dalla stessa parte mainstream (per i riferimenti devo prima rientrare dalle ferie). L’articolo non diceva niente di nuovo che non fosse già conosciuto, ma lo stupefacente che permette ai differenti modelli, con disparati valori di sensivity, di avere trend dell’anomalia simili è l’aerosol. Poichè le proprietà degli aerosol sono “aggiustabili” a piacimento, l’aggiustamento è tale che il risultato finale (il trend del XX secolo), essendo conosciuto a priori, venga fuori per magia dal calderone.

Bene, dopo le divagazioni sulla (fanta)scienza dei modelli, possiamo adesso tornare alla fisica di questo pianeta e a come questa non sia invariante alla temperatura?

Paolo

Carlo,

non credo affatto sia un problema di manomissione, perchè sarebbe quasi impossibile come giustamente hai scritto tu, ma anche perchè non penso affatto ci sia alcun genere di “dolo” in tutta questa faccenda (beh, qualcuno qualche dollaruccio ce lo guadagna, ma questi non sono di sicuro i ricercatori!).

Quello che volevo dire è che se la sensibilità climatica è dominata nei modelli dal peso dei gas serra ed è la stessa per tutti i modelli, è normale che abbiano in comune lo tesso trend. E’ un pò come le joint venture tra case automobilistiche, pianale e motore in comune, estetica differente. Il risultato è che tutte le auto della serie hanno le stesse prestazioni.

Però hai giustamente citato il vapore acqueo. A questo link (http://www.climate4you.com/GreenhouseGasses.htm#Atmospheric water vapor), c’è un grafico dell’ISCCP (International Cloud Climatology Project) dal quale sembrerebbe chel’indiziato numero uno abbia un bell’alibi. Da quanto si vede dal grafico, il vapore acqueo, essenzialmente stabile negli ultimi anni del secolo scorso, è diminuito un pò nei primi anni di questo secolo. Nel frattempo il forcing antropico non è mutato di una virgola, nè forse ne è mutato il peso nelle simulazioni. Messa così non mi sembra che i conti tornino. Mi sbaglio?

gg

Non sono un fisico che gira quotidianamente modelli di clima, pur avendolo fatto qualche anno fa per un qualche tempo. Posso quindi essere sicuramente un po’ “arruginito” e sono quindi speranzoso di leggere commenti di altri colleghi ben più autorevoli di me che spero mi correggano anche, se trovano delle scorrettezze. Tuttavia, da vecchio fisico dell’atmosfera, avrei piacere di commentare un attimo quanto letto nel testo di PM. Magari a qualcuno puo’ interessare.

Credo sia necessario fare alcune precisazioni, prima, sui modelli e su come sono fatti. Mi scuseranno i super esperti se talvolta brutalizzo, per farmi capire.

Capita, come noto, che i modelli climatici siano una rappresentazione della realtà . Non sono la realtà . Si basano sulle leggi della meccanica e termodinamica dell’atmosfera (e dell’oceano, quelli accoppiati) che vengono tradotte in equazioni differenziali non lineari da risolvere con i supercomputer in modo numerico. Descrivono sia processi “adiabatici” (ad esempio le avvezioni di momento e/o temperatura), sia processi della “fisica” (radiazione, strato limite planetario, convezione ecc..) che vengono in genere “parametrizzati” in quanto avvengono su scale spaziali e temporali minori delle “grid box” dei modelli, che descrivono in maniera approssimata la realtà del “continuo” dell’atmosfera. (in realtà l’atmosfera non è un vero continuo come direbbero i matematici, ma questo è un discorso più complesso…)

I processi fisici, come noto, hanno dei feedback positivi e/o negativi che devono essere in qualche modo descritti all’interno dei modelli e questo viene fatto attraverso relazioni diagnostiche, modelli semplificati interni o altro ancora.

Senza entrare nel merito di come questo viene fatto (anche perchè, come dicevo prima, sono un po’ “arruginito”…), tutto ciò fa si che un modello, man mano che integra le equazioni, per così dire evolva un “suo” clima” che puo’, tal volta, driftare dal clima osservato, ma comunque sempre in maniera consistente con le equazioni tridimensionali dell’atmosfera (e dell’oceano)che lo caratterizza.

Quindi puo’ capitare di avere un modello un po’ più freddo, oppure un modello un po’ più caldo, uno più secco o uno più umido.

Il fatto che un modello possa avere un qualche drift (ad esempio raffreddarsi o riscaldarsi troppo…) fa si che il “clima” di quel modello (ad esempio stimato con una media fatta su trenta anni di integrazione, che in genere è minore della lunghezza del “run”), alla fine presenti una deviazione sistematica rispetto alla realtà del clima osservato, che può riscontrarsi nel campo termico o in quello pluviometrico, in quello barico e cosi’ via.

Ma sempre in maniera consistente tra le varie grandezze del modello. In sostanza un modello deve essere consistente, anche se puo’ avere degli errori sistematici e quindi differenziarsi dalla realtà .

Veniamo quindi alla temperatura.

Al di là dei problemi di riduzione (o interpolazione) della temperatura a due metri a partire dalla “T tridimensionale” , e supponendo anche di usare la temperatura ad un livello verticale dove viene calcolata, il processo di calcolo dell’anomalia rispetto al clima del “modello” in qualche modo riduce (o forse addirittura azzera) la deviazione sistematica di cui parlavo prima e permette anche, in buona sostanza, di poter mettere a confronto le diverse catene modellistiche.

Tale processo di valutazione dell’anomalia ha quindi perfettamente senso e non una banalità , secondo me.

A questo punto direi che sia quantomeno degno di nota il fatto che la maggioranza dei modelli (anzi tutti, ormai) mostrino delle anomalie che crescono più o meno coerentemente nel tempo, cioè un trend positivo. Non è poca cosa come viene giustamente fatto notare da un commentatore precedente.

Anzi, se devo dire proprio tutto, trovo molto rilevante il fatto che pur essendo i modelli abbastanza diversi tra di loro (ad esempio nel come sono fatte le parametrizzazione, oppure la numerica…), seppur aventi come DNA lo stesso set di equazioni costitutive, mostrino tutti un trend analogo.

In sostanza, tutti o quasi i modelli, pur avendo un clima diverso dall’altro e diverso (talvolta di più, talvolta di meno) da quello osservato, ebbene tutti mostrano una variazione temporale rispetto al “loro” clima, analoga. E analoga a quanto in passato hanno mostrato i dati osservati, ad esempio negli ultimi 100 anni.

Tutti, man mano che passa il tempo, divengono più caldi del “loro” stesso clima.

Ci sono delle cause che fanno si che questo possa avvenire ? Sono cause di tipo antropogenico (aumento della CO2 ?). Secondo la maggiooranza degli scienziati si, ma questo è un altro discorso.

Cordiali saluti

Carlo Cacciamani

Carlo buongiorno,

innanzi tutto grazie per aver voluto darci il tuo prezioso contributo. Vorrei approfittare per approfondire un pò il discorso nella direzione in cui Paolo ha impostato il suo post.

Prima le anomalie. Certamente l’analisi dello scostamento del modello dal “suo” clima, sia esso più o meno rappresentativo della realtà è un fattore che può aiutare a comprendere la direzione in cui il sistema si evolve. Resta il fatto che questo fattore non può, a mio modesto parere, essere più importante del dato assoluto delle temperature, perchè sono queste e non le anomalie stesse a rappresentare il “sunto” delle caratteristiche del sistema (che è quello che a noi interessa sapere), per cui forse pur continuando a tenere nel dovuto conto gli scostamenti, si dovrebbe lavorare nella direzione di ottenere dati di temperatura il più possibile prossimi a quelli reali non solo nel comportamento ma anche e soprattutto in valore assoluto. Diversamente quei dati, pur avendo un comportamento in comune, saranno comunque rappresentativi di sistemi diversi da quello reale. Le indicazioni che possono così giungere dall’analisi di questa evoluzione perchè dovrebbero acquistare maggiore rappresentatività ?

Ora la “concordanza” dell’evoluzione dei singoli modelli. Nel tuo intervento hai parlato di diversità non banale tra i modelli in merito alla parametrizzazione, ai processi fisici ed ai feed-back in essi contenuti. Sarebbe possibile saperne qualcosa di più? Voglio dire, è una mia impressione o i processi di base, cioè quelli che vedono il contributo dei gas serra e relativi feed-back innescati, in poche parole la sensibilità climatica (SC) di questi modelli è un fattore comune a tutti? E se questa SC è sovrastimata ed è preponderante, è normale o no che tutti i modelli assumano lo stesso comportamento in merito ad esempio alle anomalie di temperatura, ovvero allo scostamento termico positivo dal clima di riferimento? Non sembra un pò strano che modelli che assumono di avere stati termici dell’atmosfera tanto diversi (diversità che sappiamo essere alla base dell’innesco di importanti feed-back anche di segno opposto) finiscano per evolvere tutti allo stesso modo? Può essere un problema di semplificazione dei processi in essi contenuti o di peso eccessivo e quindi decisivo di un forcing?

Infine ti chiederei un parere diretto sul quesito di fondo del pezzo di Paolo: è una buona scelta quella di considerare attendibili simulazioni che descrivono realtà tanto diverse? Il fatto che vadano tutti nella stessa direzione, non è garanzia di affidabilità , specie se il DNA dei modelli è comune; cosa impedisce che siano tutti inaffidabili? L’unico parametro per definirne l’affidabilità e quindi autorizzarne l’impiego non dovrebbe essere il confronto con la realtà (possibilmente con dataset differenti da quelli impiegati per il tuning naturalmente)?

Spero di non aver scritto troppe stupidaggini. Grazie ancora per il tuo contributo a CM.

gg

Ciao Guido, cerco di risponderti “per temi”, sperando di saperlo fare per almeno la maggioranza delle domande che mi poni.

A proposito della inaffidabilità :

E’ quasi ovvio che un modello dovrebbe tendere ad essere il più possibile vicino alla realtà . Non sto dicendo affatto infatti che i modelli non hanno degli errori (sistematici e non sistematici) anche grandi e che questo non sia un problema, sto dicendo che per dire che c’è un trend sulle scale di tempo decennali e più, li ritengo comunque sufficientemente buoni…, per le ragioni che ho cercato di dire nel mio commento.

A proposito della somiglianza dei modelli:

Non capisco bene il problema, ti devo essere sincero. Comunque, la diversità tra modello e modello, che si esprime ad esempio in diverse parametrizzazioni dei processi fisici (ma non solo), non è necessariamente tale da far si che un modello descriva un processo fisico in maniera totalmente “ortogonale†a quello che fa un altro. Altrimenti non si potrebbe dire che quel processo fisico è abbastanza noto e quindi tale da essere in qualche maniera inserito nel modello…Potranno magari essere diversi i coefficienti di tuning, le costanti di accoppiamento, magari anche lo schema di parametrizzazione stessa,.., ma non la fisica del processo, se è abbastanza nota…Questo per dire che non mi sembra “peccaminoso†che ci siano dei fattori comuni…Oserei dire: meno male che ci sono !

Per spiegarmi ancor meglio ti faccio un esempio concreto: se prendi il problema della parametrizzazione dello strato limite planetario con un modello di chiusura della turbolenza del primo ordine (cioè stimare che i flussi turbolenti sub-grid di calore/momento siano in prima approssimazione proporzionali ai gradienti di temperatura/velocità calcolati come grandezze medie nelle grid-box) puo’ starci benissimo che anche due modelli con lo stesso identico schema di chiusura della turbolenza ma con coefficienti di accoppiamento differenti, possano produrre risultati diversi in termini di diffusione di calore (quindi produrre più o meno riscaldamento…) o di quantità di moto (quindi produrre campi di vento più o meno forti…). In sostanza puo’ anche essere un problema di tuning diverso da modello a modello che crea le differenze, ferma restando la rappresentazione fisica del processo… (ma è solo un esempio…)

Ma sento già la contro-polemica: non si sa abbastanza: come si fa a modellare ?

Non mi sento di dire che non ci sia nulla che non si sa, dei processi fisici dell’atmosfera, che si infilano dentro i modelli. Il progresso della conoscenza è lento ma continuo e inarrestabile. E con quello che si sa già oggi molto si fa e sarebbe inutile e dannoso dire che finchè non si sa “tutto” non si usa “nulla” perchè “tutto” è inaffidabile. Questa mi sembra una posizione antiscientifica, forse nichilista e sicuramente irragionevole. Anche perchè parte dal presupposto (errato) che sia possibile conoscere un giorno “tutto” o comunque “più che abbastanza”. E, di grazia, quale sarebbe la soglia che divide il poco dal molto, in termini di conoscenza ?…

In merito al confronto con la realtà :

Il confronto con la realtà è molto importante, ma anche un modello poco aderente alla realtà (cioè che abbia un BIAS), per le ragioni che ho detto, purchè sia coerente internamente, puo’ avere una sua grande utilità . Ad esempio nel permettere di detectare un trend, sulle scale di tempo lunghe, che è l’oggetto del dibattito, mi sembra…

Ovviamente scusami anche te, e gli altri, per le schiocchezze, se e dove le ho dette.

Ciao Carlo

Ciao Carlo,

spero di non tediarti se torno ancora sul problema. Con riferimento alla somiglianza tra modelli, non penso affatto che sia peccaminoso che essi abbiano qualcosa o più auspicabilmente molto in comune, proprio perchè la diversità potrebbe scaturire solo dalla scarsa conoscenza delle dinamiche dei processi e sarebbe un pò come andare per tentativi, alla ricerca delle giuste soluzioni (forse a volte si fa così, ma sarebbe meglio di no). Il punto del mio commento era: non sono forse troppo simili proprio nel descrivere (forse con troppa insistenza) il processo ritenuto essere il più significativo, cioè il contributo dei gas serra? Se a prescindere da diverse parametrizzazioni o diversi feed-back descritti nei diversi modelli, tengo fisso il concetto tot CO2=tot calore in più (perdona l’esempio decisamente rozzo), direi che sia inevitabile che i trend siano concordi. Ma questa non è una prova, è quanto ho stabilito io all’inizio, cioè il trend positivo più che un output è un input o mi sbaglio?

Nessuna contropolemica nichilista o antiscientifica, perchè è ovvio che si deve lavorare con quello che si ha, finchè non si ha qualcosa di meglio. Al riguardo il punto è più sull’uso che si vorrebbe fare di quanto scaturisce da questo lavoro che sul lavoro stesso che, ovviamente, è assolutamente prezioso. Non stiamo parlando di questo ora ma è meglio che chiarisca: che la modellizzazione sia la frontiera della scienza del clima è indubbio, che si pretenda di averla già attraversata è un pò meno accettabile.

Grazie ancora,

gg

Caro Guido,

come sai meglio di me, i processi fisici in atmosfera sono connessi tra loro da effetti di controreazioni (o feedbacks) positive e negative. Se non erro il più importante processo di feedback che regola il legame CO2 – riscaldamento è quello del vapor d’acqua, grazie alla legge di Clausius-Clapeyron che dice in sostanza che un’atmosfera più calda permette la presenza di più vapore di una più fredda. Siccome il vapor d’acqua è un gas serra questo crea un ulteriore riscaldamento e così via. Poi c’è il feedback (positivo e negativo) delle nubi che permettono sia un cooling (più albedo) ma anche un warming (più acqua = più effetto serra…) e poi ci sono un’altra miriade di processi ancora che in qualche maniera determinano o warming o cooling della T. Mi sembra che ci sia unanime consenso sul fatto che l’effetto di warming sia dominante, e trovo quantomeno interessante che la stragande maggioranza dei modelli, pur con le loro differenze di cui si discettava, e che contengono una descrizione di questi processi di feedback, siano concordi nel dare un segnale di riscaldamento. Ai tempi del terzo report IPCC questo agreement era meno evidente tra le diverse catene modellistiche, adesso mi sembra che non ci siano molte differenze. Siccome credo che manomettere “ad arte” le parametrizzazioni di tutti i modelli per far tornare un segnale di riscaldamento sia praticamente impossibile, vista la complicazione, credo che il segnale di riscaldamento che i vari modelli forniscono sia corretto.

C’è una cosa sicuramente giusta che dice Mezzasalma:

“Prima di giungere alle conclusioni, sento la necessità di ascoltare ciò che avrebbe da dire chi ha ampia conoscenza della modellistica climatica. Sento che hanno una risposta.E mi piacerebbe tanto conoscerla.”…

Per bussare abbiamo bussato, chissà che qualcuno non risponda.

gg

luca,sono daccordissimo,ma su cio bisognerebbe interpellare un qualunque fisico che lavori al centro di calcolo europeo di READING

Ok, adesso è più chiaro.

@Mezzasalma

Vorrei allora delle delucidazioni su questa frase:

“Ricordando che tutte le tragedie climatiche degli ultimi decenni sarebbero state causate da VARIAZIONI di alcuni decimi di grado, che dire di un mondo la cui temperatura media del recente passato è stata di 17°C ? E quello in cui buona parte del XX secolo ne ha avuti 12 ?”

anche in relazione a quanto affermato da me ovvero sul fatto che 12 o 17 vanno prese come stime equiprobabili del valore reale di equilibrio. Mi sembra ovvio che in questo senso, parlando poi di VARIAZIONI di decimi di grado, la cosa non abbia senso, o sbaglio? Supponga che il valore reale attuale sia 17, le risulta che stiamo cuocendo come dice lei? Oppure sia 12: stiamo congelando? Non ha senso.

Mi dica un pò anche i suoi conti del 29% delle terre emerse e come si arrriva a 23 per Bologna ecc…

Un’altra cosa volevo poi sottolineare:

il clima è un sistema complesso in equilibrio con le sue forzanti: se le forzanti variano anche l’equilibrio climatico si sposta da cui nascerebbe il trend delle simulazioni; preso atto dell’impossibilità di una stima accurata del valore reale di temperatura media superficiale lei vuole negare che il trend sia qualcosa di significativo ovvero del tutto inutile ai fini dell’analisi?

Mi sembra poi che gli estremi di temperatura non siano ne 100 ne 0, come lei mi accusa di pensare, ma 12 e 17…tra l’altro il fatto che ci sia un’incertezza non vuol dire che sia ‘spazzatura’: in fondo lei stesso una volta ha detto che compito della scienza è quello di stimare l’incertezza…e qui è stato fatto.

Chi dice poi che il valore medio stimato reale di Hanssenn pari a (14.0+-0.5) non sia il risultato di una media d’ensemble tra i vari modelli? Lei a questo c’ha pensato? Supposte infatti tutte le simulazioni equiprobabili (cosa che potrebbe anche non essere) facendo la semplice media aritmetica viene proprio un valore basso pari circa a 14. Altro che fantascienza, è calcolo.

Se ha la gentilezza di rispondermi prego, altrimenti me ne farò comunque una ragione.

Quello che dice Guidi mi sembra invece più sensato. Il problema è che non so se la temperatura sia una variabile di output svincolata dalle altre oppure costituisca a sua volta un feedback o addirittura una forzante per altri processi: un’equilibrio finale ci deve pur essere…

Grazie

LG

Luca,

provo a rispondere io perchè credo che Paolo non sia disponibile attualmente.

Attenzione a non fare confusione tra stima delle temperature attraverso le simulazioni modellistiche e stima delle temperature attraverso diversi sistemi di post-processing dei dati osservati. Nel primo caso si tratta di output che derivano dal tentativo di simulare il comportamento delle dinamiche del sistema (bilancio radiativo, contributo delle varie forzanti e feedback di vario genere) nel secondo caso si tratta del risultato dei processi che parametrizzano e rendono omogenei su scala spaziale e temporale dati che in origine non lo sono ma sono pur sempre dati reali, sebbene provenienti da più fonti (diversi sistemi di misura, dati di prossimità etc etc.). L’attendibilità dei modelli nel loro complesso sarebbe proprio nel fatto che la loro media si approssima a quanto deriva da questo lavoro di determinazione della T media superficiale. Il punto è che questa media non ha molto senso se sono inclusi dati provenienti da modelli che descrivono processi per forza di cose molto diversi tra loro in ragione dei risultati che producono. Certamente il trend è concorde, ma non potrebbe essere diversamente, visto che a tutti i modelli è stato insegnato che la forzante antropica è preponderante. In poche parole, visto che scherzosamente abbiamo parlato di altri mondi, avrebbe senso studiare la vita sul pianeta terra mediando tra le condizioni ambientali degli altri pianeti del sistema solare? Eppure sappiamo che anche lì è tutto un discorso di temperatura no? Perdonami l’esagerazione, ma credo che il concetto sia proprio questo. Non posso prendere per buone delle simulazioni che descrivono condizioni diverse da quelle reali, specialmente se si assume a priori che nonostante questa diversità , tutti i sistemi reagiscano allo stesso modo.

Con riferimento alle variazioni di temperatura, se si ritiene che pochi decimi di grado generino pesanti alterazioni delle dinamiche interne al sistema, a maggior ragione alcuni gradi dovrebbero innescarne di ancora più incisive, cioè quei valori dovrebbero esprimere l’integrale di condizioni di partenza totalmente differenti. E’ chiaro che non stiamo arrostendo nè congelando, ma se diamo credito a ci ci dice che un’alterazione di questo presunto equilibrio ci arrostirebbe o congelerebbe anche solo con piccole variazioni, come si può immaginare come attendibile una simulazione che mostra variazioni rispetto alla realtà ben più accentuate e non arrostisce nè congela?

gg

le simulazioni,specie nel campo termico sono sempre pericolose sia in campo meteo,figurarsi in climatologia..e poi la questione discutibilissima delle medie climatiche…sarebbero da rivedere..non si puo continuamente fare riferimento ad andamenti di un cinquantennio otrentennio fa…a 37 gradi siamo sopra la media..OK? mi sta bene,ma a forza di avere estati con classici 37 gradi..dovremo trovare il coraggio di rimettere in discussione il tutto….a meno che ,le medie climatiche non siano una specie di carta costituzionale immodificabile e quel che peggio intoccabile…oramai é annormale non avere 37 gradi….e aime annormale fare 20 cm di neve (A NATALE)

Non bisogna dare troppa importanza al clima di riferimento, se è una media di 50 o 30 anni, o se questi 50 anni sono i primi 50 del secolo XX o i secondi 50. Serve solo per calcolare un’anomalia e le proprietà della curva sono invarianti.

Se posso essere d’accordo sulla regolarità dei 37° di recente, sulla mancanza di neve a Natale, anche quello è regolare…ma non di recente, da sempre!

Se lei si riferiva alla mancanza di neve nel corso dell’intero inverno, credo che la cosa sia più complicata di quello che lei pensa. Ma non è l’argomento di questa discussione.

pienamente daccordo,anche se puntualizzerei per la mancanza di neve in un intero inverno…beh! qua gioca un ruolo fondamentale i determinati luoghi..quest,anno in piemonte di neve ne ha fatta parecchia,da reggio emilia a est pochi cm sebbene in un contesto di parecchi episodi..tornando alle medie ..puo pure essere ,ma non ce bollettino meteo che non faccia riferimento a valori doc in base al valore termico del momento..il confronto é sempre presente

>> “I modelli numerici dell’atmosfera o dell’oceano e di ogni loro accoppiamento più o meno decente, non trattano l’anomalia ma, e non potrebbe essere diversamente, calcolano la temperatura, ovvero quella semplice variabile meteorologica che siamo in grado di misurare con un termometro.”

Boh, anomalia o temperatura superficiale poco importa visto che poi è il ‘trend’ quello che conta e lì l’anomalia rispetto ad un periodo temporale preso come riferimento si vede eccome.

>>> “Presa per buona una temperatura pari a 14°C, il grafico qui sopra mostra che i modelli usati per l’AR4 stimano un valore medio che secondo le simulazioni, varia tra 12 e 17 gradi. Ricordando che tutte le tragedie climatiche degli ultimi decenni sarebbero state causate da variazioni di alcuni decimi di grado, che dire di un mondo la cui temperatura media del recente passato è stata di 17°C ? E quello in cui buona parte del XX secolo ne ha avuti 12?”

Suvvia è chiarissimo che l’incertezza è sulla stima: di fatto la temperatura media o è 12 o è 17 o qualche valore ivi compreso mentre non è assolutamente vero che abbia oscillato tra quei valori variando addirittura di 5 gradi come scritto dopo…

Insomma data l’incertezza sul valore medio della temperatura superficiale, che con molta evidenza dipende strettamente dal metodo di calcolo utilizzato visto che la cosa è, a detta di Hanseen, ‘difficile’ a calcolare in maniera univoca, quel che conta è ancora una volta il trend.

Per meglio capire la cosa vista l’arbitrarietà del valore della media basta scegliersi una curva con un certo valor medio, assumerlo pari alla media reale e vedere il trend della curva.

>>> “Dove sarebbero le condizioni di equilibrio?”

Le condizioni di equilibrio starebbero nella media delle singole ricostruzioni o meglio sarebbe la media riferita ad un oscillazione completa che però di fatto non compare nel grafico che invece evidenzia un leggero trend in ascesa per ciascuna linea…

>>> Se prendiamo per buona la simulazione di una temperatura media globale pari a 17°C, questo significherebbe che la temperatura media annua di Bologna dovrebbe essere di 23° e non di 13.6° come in effetti è.

Questo dato, da 13,6 a 23, come è venuto fuori? 5 gradi in più (17-12) di 13,6 fanno 18,6 ovvero ben 4,4 gradi in meno di 23…

Lei inoltre sembra assumere che il 13,6 debba necessariamente coesistere con una media globale di 12?

Chi l’ha detto?

13,6 potrebe essere la media annua di Bologna anche con 17 di media globale visto che quest’ultima è appunto una ‘media globale’ peraltro stimata in valore assoluto e ugualmente possibile e probabile alle altre medie calcolate…

Ripeto: quei valori assoluti di simulazione devono essere presi come ugualmente possibili, visto che non si conosce l’effettivo valore reale della media, e quello che conta è invece il trend: l’incertezza quindi è solo sui metodi di calcolo della variabile temperatura globale definita per l’appunto ‘critica’, non sul trend…

Signor Galati,

se lei desidera aver un rapporto dialettico col sottoscritto, la prego di non metter parole sue in bocca al suo interlocutore.

Non è detto da nessuna parte che la temperatura varia tra 12 e 17 gradi all’interno di una simulazione. Il grafico parla chiaro e la lingua usata per spiegare la cosa è quella italiana, quella adoperata in questo paese abbastanza di frequente.

Stessa cosa per la sua pretesa che io voglia collegare il mondo a 12° con la Bologna a 13.6°. Sono ancora parole sue che lei pretende attribuire a me. Così non si va molto avanti e non sono disposto a tollerarne di nuove.

Sempre in italiano, è espresso il concetto che, se la simulazione della sst è corretta, l’errore di 5 gradi andrebbe applicato solo al 29% della superficie terrestre. I suoi conti sono sbagliati, la matematica non è un’opinione.

Che quello che conta è il trend dell’anomalia è una favola che la si racconta tra i modellisti del clima. Se si vuole capire dove tende un clima, prima bisogna simularlo questo clima. Questo è l’abc della scienza.

Ma tanto a lei che gliene frega se questo mondo ha una temperatura di partenza pari a 100 o a 0 gradi. L’importante è il trend simulato. Che lei sia stracotto o surgelato, non conta.

Vorrei sperare, poi, che almeno voglia credere alle stime di Hansen & c. Vede, neanche a lui ha le certezze che lei vede nella scienza, ma se il valore stimato è (14.0 +- 0.5)°C, tutto quello al di fuori, addirittura di 3 gradi, da quella stima è fantascienza. E qui non si parla di fantascienza, no?

Credo che possa essere sfuggito il succo del discorso di Paolo. La T media di riferimento può essere considerata un integrale del clima di riferimento (magari quella assoluta di tutto lo strato e non solo quella superficiale). Se il valore di quella T cambia da una simulazione all’altra in modo così marcato, vuol dire che quelle simulazioni esprimono sistemi in cui valgono regole del gioco diverse da quelle che conosciamo; un mondo di due gradi più freddo è un mondo con albedo molto diverso, con vapore acqueo molto meno abbondante perchè catturato dalle superfici congelate, con sorgenti di gas serra che invece di emettere assorbono etc etc…, mentre un mondo di tre gradi più caldo non si può nemmeno considerare all’opposto perchè nessuno sa quali e quanti feedback si innescherebbero con condizioni così mutate. Per cui, come possono dei valori di T che rappresentano integrali di questi mondi essere considerati validi per rappresentare quello che conosciamo? La semplice analisi del famoso trend di aumento comune a tutte le simulazioni in presenza di accrescimento del contributo antropico dei gas serra, oltre ad essere troppo semplicistica è anche chiaramente un input alle simulazioni e non un output delle stesse. Scommettiamo che i meccanismi di azione e retroazione di queste simulazioni sono gli stessi per tutti gli ensemble? Il punto è che si presume che il sistema reagisca sempre allo stesso modo, a prescindere dalle condizioni di partenza. Questo semplicemente non è vero e non è possibile.

gg

Se può interessare

http://www.sciencedaily.com/releases/2007/03/070315101129.htm

Bjarne Andersen, “Researchers Question Validity Of A ‘Global Temperature'” Science Daily (Mar. 18, 2007).

[…] Modelli dell'altro mondo | Climate Monitor […]