E’ stato pubblicato da poco su Nature un articolo che sta suscitando un bel vespaio negli ambienti che si occupano di climatologia e, in particolare, di livello del mare o, per essere più precisi, di velocità di variazione del livello medio del mare. Della questione, qui su CM, mi sono occupato molte volte in passato in quanto vengono continuamente pubblicati lavori che si occupano della variazione del livello dei mari e specificamente della variazione della velocità con cui esso varia.

Qualche breve informazione introduttiva. Il livello del mare è stato misurato per secoli mediante mareografi ovvero dispositivi di misura allocati in pozzi ubicati nelle zone più riparate dei porti. Dall’inizio dell’era satellitare le misure d’elezione del livello del mare sono quelle in remoto ovvero quelle effettuate mediante altimetri ubicati sui satelliti artificiali: tali osservazioni sono preferite in quanto estese a tutta la superficie marina mentre quelle mareografiche risentono del numero limitato dei punti di osservazione. Il livello medio globale del mare non è mai stata una grandezza fisica che ha appassionato i ricercatori in quanto risultava estremamente complesso desumere il suo valore dalle limitate serie di dati disponibili. In epoca più recente, diciamo di globalizzazione, anche per il livello dei mari, così come per la temperatura, gli scienziati hanno tentato di stimare un valore numerico che rappresentasse la sintesi del livello del mare a livello planetario: il Global Mean Sea-Level o GMSL che, pertanto, non è una misura, ma una stima. Fino ad oggi il livello medio globale del mare è stato stimato come media del livello medio del mare nelle sottoregioni in cui sono stati divisi gli oceani terrestri. In tali regioni il livello del mare varia in modo differente: in alcune aumenta, in altre diminuisce, in altre ancora resta costante (qui e qui su CM per approfondimenti).

Il problema principale delle misure del livello medio globale del mare è legato al passato: la velocità con cui esso variava può essere stimata in modo alquanto grossolano in quanto le serie di dati disponibili sono disomogenee e largamente lacunose. Le ricostruzioni del livello del mare più complete (ed anche più citate in letteratura) su cui oggi possiamo contare sono:

- Jevrejeva, S., Moore, J. C., Grinsted, A. & Woodworth, P. L. Recent global sea level acceleration started 200 years ago? Geophys. Res. Lett. 35, L08715 (2008)

- Church, J. A. & White, N. J. Sea level rise from the late 19th to the early 21st century. Surv. Geophys. 32, 585–602 (2011).

Queste due ricostruzioni hanno consentito di appurare che in passato il livello medio globale del mare è variato con una tendenza media nel lungo periodo di 1,6-1,9 mm all’anno. I rilievi satellitari estesi a tutta la superficie oceanica, hanno consentito di appurare che dopo il 1993 il livello del mare è variato con una velocità diversa: circa 3 mm all’anno. Tenendo conto del GIA (assestamento post-glaciale) questo valore potrebbe essere affetto da un margine di incertezza di circa +/-0,4 mm all’anno. In ogni caso ci troviamo di fronte ad un rateo di variazione maggiore che nel passato.

Da un punto di vista fisico la variazione del livello medio del mare si può considerare come la sommatoria di due aliquote principali: la dilatazione termica degli oceani conseguente all’aumento del contenuto di calore dell’acqua che li costituisce (componente termosterica) e l’apporto di nuova massa derivante dalla fusione delle calotte glaciali terrestri (calotta groenlandese e calotta antartica, principalmente) e variazione del regime delle acque superficiali e sotterranee terrestri. Esistono anche altri contributi legati all’interazione atmosfera-oceani, alle variazioni topografiche del fondo del mare ed alle dinamiche tettoniche crostali e del mantello. Attualmente, secondo alcuni ricercatori, la sommatoria di ognuna di queste componenti porta ad un trend di variazione del livello medio globale del mare minore di quello stimato dai modelli matematici per cui non vi sarebbe un’accelerazione della variazione del livello del mare rispetto al passato più recente, ovvero nell’ultimo ventennio (qui, su CM per un approfondimento).

Tralascio volutamente ogni riferimento ai modelli semiempirici che legano le variazioni del livello del mare a parametri come la temperatura media globale o la concentrazione di CO2 atmosferica in quanto, secondo me, sono poco attendibili.

Dopo questa premessa necessaria ad inquadrare il problema, veniamo all’articolo oggetto di questo post di commento. Si tratta di

Probabilistic reanalysis of twentieth-century sea-level rise (qui l’abstract) di C. C. Hay, E. Morrow, R.E. Kopp e J. X. Mitrovica (da ora Hay et al., 2015).

Come recita il titolo si tratta di una rianalisi di tipo probabilistico della variazione del livello del mare nel corso del ventesimo secolo. Gli autori prendono le mosse proprio da quello che ho considerato uno dei punti deboli delle ricostruzioni del livello del mare: la mancata corrispondenza della sommatoria delle componenti fisiche che determinano il livello del mare e le ricostruzioni che di esso sono state effettuate. Secondo gli autori delle ricerche che hanno preceduto Hay et al., 2015, le differenze tra il GMSL stimato sulla base delle misure mareografiche ed il livello medio del mare, calcolato come sommatoria dei contributi termosterici e di massa, è dovuto ad una sottostima di tali contributi. Hay et al., 2015 avvalendosi di una tecnica innovativa di trattamento dei dati, invece, riescono a far quadrare i conti e, quindi, far coincidere le stime dei contributi alla variazione del livello medio globale dei mari con quelle del livello medio globale dei mari desunto dai dati mareografici.

La semplice lettura dell’abstract non consente di comprendere il processo analitico messo in atto dagli autori dello studio, ma i commenti riportati su RealClimate, WUWT ed il comunicato stampa dell’Università di Harvard (cui gli autori sono affiliati) ci può aiutare a ricostruirlo. In particolare da tale comunicato possiamo risalire ad una descrizione puntuale della logica e della metodologia che sottende il loro lavoro.

Come ho avuto già modo di scrivere, il livello del mare varia da zona a zona e questo comporta, secondo la logica comune, che esso non può dipendere da un unico fattore (l’aumento delle temperature globali) che determina la fusione delle calotte glaciali terrestri e, quindi, il contributo di massa e il contributo sterico all’aumento del livello del mare. Secondo gli autori il meccanismo che regola la variazione del livello del mare è controintuitivo: la fusione delle calotte glaciali groenlandesi, per esempio, può determinare un aumento del livello del mare in una zona e una diminuzione del livello del mare in un’altra area, anzi l’aumento del livello del mare prodotto, per esempio, dalla fusione della calotta groenlandese è maggiore oltre il limite dei 2000 km dalla costa groenlandese che entro questo limite. Ciò in quanto l’aggiustamento isostatico o GIA in prossimità delle calotte glaciali in fase di fusione, annulla del tutto il contributo di massa della calotta fusa. Questo, secondo gli autori, potrebbe spiegare perché i mareografi europei registrano valori inferiori dell”innalzamento del livello del mare rispetto a quello globale. Fatta questa premessa gli autori hanno cercato di individuare le “impronte digitali” del contributo della fusione delle varie calotte glaciali (groenlandese ed antartica) all’aumento del livello medio globale del mare.

L’operazione, come si può facilmente immaginare, è estremamente difficile e complicata. Il segnale del contributo della fusione delle calotte glaciali terrestri è piuttosto debole ed immerso in un rumore abbastanza forte legato al moto ondoso, all’interazione atmosfera-superficie del mare (qui su CM per un approfondimento) alla dilatazione termica del mare ed alla variazione dei regimi delle acque circolanti terrestri per cui, sia la sua individuazione che la sua quantificazione, sono abbastanza difficili. Individuare e quantificare il segnale della fusione della calotta glaciale groenlandese o di quella antartica separatamente, è ancora più complicato in quanto si tratta di segnali ancora più deboli. Per riuscirci (gli autori sono convinti di esserci riusciti) hanno utilizzato i risultati di un altro studio da loro condotto e pubblicato su PNAS Estimating the sources of global sea level rise with data assimilation techniques (da ora Hay et al., 2012). Tale articolo, liberamente accessibile, consente di comprendere in modo pressoché completo il significato dello studio oggetto di questo post.

Prima di descrivere il lavoro oggetto dell’articolo pubblicato su Nature, pertanto, è necessario capire la metodologia elaborata dagli autori e discussa nell’articolo pubblicato su PNAS. Lo studio ruota intorno all’applicazione di un filtro (filtro di Kalman) in grado di lisciare una serie di dati numerici. Il filtro si basa sul principio dei minimi quadrati, ma rispetto al metodo classico, è in grado di analizzare anche serie piuttosto lacunose e generare delle serie di dati che hanno una grande verosimiglianza con quelle reali in quanto utilizza un approccio iterativo in cui i risultati del passo precedente vengono modificati da quello successivo fino a fornire un risultato che rappresenta il valore più probabile per quella particolare serie di dati. L’algoritmo di Kalman consente, in poche parole, di “riempire” le zone in cui sono assenti i dati con dati “sintetici” tali da salvaguardare i dati misurati. L’algoritmo presenta, inoltre, molti altri vantaggi rispetto ai fit lineari della teoria classica dei minimi quadrati in quanto consente di effettuare anche analisi non lineari. La ricostruzione dei dati mancanti, per finire questa breve ed incompleta sintesi, avviene a partire dai modelli matematici delle variazioni del livello medio del mare puntuale determinato dai contributi termosterici, di massa e dell’assestamento isostatico post-glaciale.

Mi riservo, per semplificare la trattazione, di discutere in maniera più approfondita le caratteristiche del filtro di Kalman in un prossimo post. Per quello che ci riguarda basti sapere che gli autori hanno creato centinaia di serie di dati che simulano diversi tassi di fusione delle calotte glaciali e, quindi, modellano vari contributi della fusione delle singole calotte glaciali al livello medio del mare e hanno immerso tali dati in un rumore simile a quello degli oceani reali. Mediante il filtro di Kalman opportunamente modificato, sono riusciti a isolare dal rumore il segnale nascosto che essi ben conoscevano. L’algoritmo utilizzato si è dimostrato molto abile ad individuare ed isolare il segnale per cui essi reputano lo stesso algoritmo capace di individuare il contributo della fusione della singola calotta al livello medio del mare e, quindi, fornire il più probabile profilo della variazione del livello medio del mare.

Torniamo, ora, al nostro problema: riconoscere le “impronte digitali” dei contributi di massa apportati dalla fusione delle singole calotte glaciali alle variazioni del livello medio globale del mare. Questa “attenzione” dei ricercatori nei confronti di questo contributo si spiega con il fatto che la fusione delle calotte glaciali terrestri è imputata al riscaldamento globale, quindi, se si riesce a trovare l’impronta digitale del contributo di massa delle calotte glaciali al livello del mare, si riesce a trovare, indirettamente, quella del riscaldamento globale e, in ultima analisi, quella antropica.

In letteratura esistono diversi esempi di modelli che sono in grado di simulare il contributo della fusione della singola calotta all’innalzamento del livello globale del mare per cui, noto il ritmo di fusione della singola calotta glaciale, è possibile ricostruire il contributo di quella particolare calotta glaciale alla variazione del livello del mare nel tempo. Sommando i contributi di tutte le calotte glaciali terrestri alla variazione del livello del mare, si ottiene un valore che, addizionato al contributo sterico legato alla dilatazione termica degli oceani ed a quello della variazione delle acque circolanti sulle terre emerse rappresenta il tasso di variazione del livello medio globale del mare.

La ricostruzione così effettuata viene confrontata mediante complesse funzioni statistiche con le osservazioni dei singoli mareografi allo scopo di verificarne la bontà.

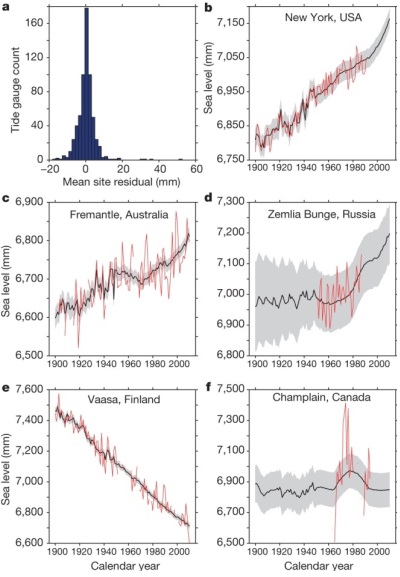

Nella figura che segue tratta da Hay et al., 2015 si può avere un’idea del lavoro eseguito dai ricercatori (fonte: CC Hay et al. Nature 000 , 1-4 (2015) doi:10.1038/nature14093):

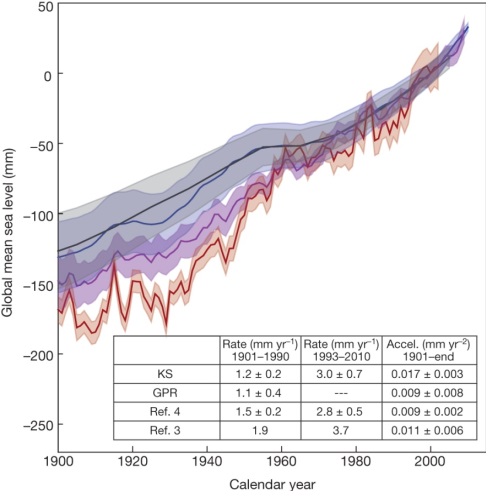

Effettuata la ricostruzione di tutte le serie di dati nei vari siti mareografici (circa 600), gli autori hanno provveduto a campionare in modo casuale (stima probabilistica) i dati ricostruiti ottenendo una serie di vettori numerici che inseriti in una matrice opportuna, hanno consentito di ricostruire il GMSL dal 1900 al 1990. Nella figura seguente, tratta da Hay et al., 2015, il confronto tra la ricostruzione degli autori e le precedenti (fonte: CC Hay et al. Nature 000 , 1-4 (2015) doi:10.1038/nature14093).

Il risultato di tutte le elaborazioni che ho cercato di descrivere al meglio delle mie possibilità, compatibilmente con i dati a mia disposizione, ha consentito di accertare che il trend di variazione del livello del mare nel periodo 1900-1990 è stato inferiore a quello calcolato dagli studi precedenti (1,2+/-0,2 mm all’anno contro 1,5+/-0,2 mm all’anno di Church e White e 1,9 mm all’anno di Jevrejeva et al.), per cui il tasso di crescita del livello medio globale del mare odierno (circa 3 mm all’anno per tutte le serie poste a confronto) ha subito un’accelerazione rispetto al passato.

Questa conclusione ha come logica conseguenza che le previsioni circa l’aumento del livello del mare nel prossimo futuro debbono essere riviste (in peggio, molto probabilmente).

Fin qui lo studio. Restano da fare, a questo punto, alcune considerazioni.

Voglio, però, prima fare una premessa. Commentare un articolo è un’operazione molto difficile in quanto presuppone la lettura dell’intero articolo non dei comunicati stampa e dell’abstract, di tutti i lavori citati e la replica dei risultati degli autori: io non ho potuto leggere l’articolo, ho letto solo una parte (piccola) dei lavori citati nell’articolo di cui stiamo parlando e non ho replicato i risultati per cui le mie devono essere considerate delle semplici impressioni che nulla hanno a che vedere con la valutazione scientifica di Hay et al., 2015.

Tanto premesso non posso fare a meno di esprimere qualche perplessità di carattere generale. La ricerca da cui prende spunto l’articolo in buona sostanza consiste nell’elaborazione di un modello matematico del livello medio del mare nel periodo 1900/1990 dal quale viene desunto il trend di variazione della velocità con cui aumenta il livello globale del mare. Come si evince dai grafici allegati alla figura 2 in alcuni casi le osservazioni coprono un tratto brevissimo del periodo indagato per cui il calcolo del livello medio del mare, in molti casi, è frutto di una ricostruzione statistica basata su un algoritmo di calcolo e ciò non può non incidere sul risultato finale. Il metodo di calcolo dei contributi delle singole calotte glaciali terrestri utilizzato nello studio, presuppone la conoscenza delle correnti oceaniche, delle temperature, della salinità, delle caratteristiche topografiche dei bacini oceanici e di tutti gli altri parametri fisici che caratterizzano gli oceani. Questi parametri non li conosciamo, il metodo di calcolo li stima in maniera probabilistica e valuta il grado di fiducia che tali stime possono avere sulla base della corrispondenza dei dati mareografici con quelli stimati. Altra perplessità riguarda la ricostruzione del tasso di fusione delle calotte glaciali nel corso del tempo: i dati a disposizione non sono tali da consentire una corretta stima del tasso di fusione annuo a partire dal 1900 e fino al 1990 per cui anche per essi gli autori hanno dovuto far ricorso ad una stima probabilistica che, grazie al particolare algoritmo di filtraggio utilizzato, rende minimi gli errori rendendo il loro lavoro robusto dal punto di vista statistico. Resta, però, l’incertezza nei dati di partenza.

Non appare risolto neanche il problema di fondo di tutte queste rianalisi: i modelli matematici richiedono delle celle all’interno delle quali calcolare i valori delle grandezze fisiche simulate. Non sempre in queste celle troviamo dei mareografi per cui si interpolano valori tra punti distanti anche mille chilometri per calcolare questo benedetto GMSL come anche la temperatura globale. Questo è, a mio avviso, una grossa limitazione in quanto per mia convinzione personale, probabilmente sbagliata, diffido delle medie costruite con dati non misurati.

Oggi ho rilevato un’area su cui verrà effettuato uno sterro per far posto ad un complesso sportivo. Scopo del rilievo è quello di costruire un modello matematico del terreno (sulla base delle misure reali) che sarà utilizzato per quantificare il volume di terreno rimosso. Se avessi ricostruito tale volume a posteriori senza eseguire misure, ma sulla scorta di modelli matematici del terreno costruiti sulla base di un rilievo aerofotogrammetrico a grande scala interpolando dati piuttosto distanti nello spazio, per esempio, o dell’andamento del terreno circostante il sito di scavo, il mio cliente mi avrebbe mandato al diavolo, invitandomi a giocare con i miei soldi e non con i suoi.

Detto in altri termini per me è difficile ragionare in termini di dati “virtuali”. Probabilmente questa “deformazione” professionale rende il mio giudizio affetto da un bias “strumentale”, ma non posso farci niente: è più forte di me.

Voglio concludere, infine, riportando il senso dela chiosa del post che RealClimate ha dedicato all’articolo.

Hay et al., 2015 cerca nei dati le impronte digitali del riscaldamento globale, Church & White quelle della variabilità naturale. Probabilmente ci sono entrambe, probabilmente non riusciremo mai a capire con precisione di quanto è aumentato il livello del mare nel 1900 e, in ogni caso, non è molto importante ai fini pratici sapere se esso è aumentato di 3 cm in più o in meno. In altri termini l’articolo non cambia in modo significativo la nostra prospettiva circa il futuro innalzamento del livello del mare.

Sono completamente d’accordo con RealClimate.

Questo post avrà, molto probabilmente, un seguito in cui, ferme restando queste considerazioni conclusive, cercherò di discutere in modo più approfondito gli aspetti della metodologia statistica utilizzata dagli autori.

Su Pisa è proprio come dici tu, Donato. Dove ci sono grandi fiumi con grandi portate di sedimenti, l’interramento è la causa principale. In Toscana ci sono altri esempi: in Maremma, antichi porti etruschi come Roselle, originariamente su laghi costieri, oggi sono a parecchi chilometri dalla costa a causa dell’impaludamento dovuto ai sedimenti portati da Bruna ed Ombrone.

Non lo dico da geologo, beninteso, non è il mio lavoro, ma sono circostanze ben documentate e note anche al semplice turista informato.

Personalmente ci capisco molto poco di statistica e relativi metodi di analisi.

Di tutto il discorso ho capito una cosa… o per meglio dire, tale discorso mi ha confermato ciò che mi era parso di intuire dalle pubblicazioni degli ultimi anni: la comunità scientifica sta seguendo una pericolosa deriva verso l’utilizzo sempre più frequente ed imperante, dei modelli matematici.

Condivido con te, Donato, il fatto di preferire l’utilizzo di dati rilevati direttamente a quelli ricostruiti al computer… pertanto tutto questo discorso, anche se fatto al meglio delle possibilità offerte dai pochissimi dati a disposizione e dalla potenza di calcolo, andrebbe considerato solo ed esclusivamente come una prova matematica e null’altro.

I rilevamenti satellitari si basano per lo più su una “differenza” rispetto ad un modello matematico del nostro pianeta… La precisione di tale modello di riferimento, però è altissima.

Per di più sappiamo che la Terra si espande e si contrare a causa delle attività geologiche e sappiamo che varia anche sulla base della velocità di rotazione.

Ma la cosa più importante… è che ogni evento, rilevato direttamente o ricostruito indirettamente, è fine a se stesso. Mi spiego…

Si da troppa importanza, a mio modesto parere, al riscaldamento occorso e rilevato tra il 1880 e il 2014… Da tali rilevamenti vengono costruiti modelli matematici che prevedono aumenti del livello del mare e delle temperature praticamente “infiniti”…

Eppure… se andiamo indietro nella storia climatica del nostro pianeta, scopriamo che alla fine dell’ultimo Periodo Interglaciale Freddo, la temperatura del pianeta, pur con alti e bassi notevoli, è aumentata dall’allora 8°C di media, a quasi 12-13 °C per poi ripiombare giù di diversi gradi. Non c’è stato un andamento lineare e illimitato. E se andiamo ad osservare i dati, anche il livello del mare è variato nel tempo… seguendo sempre la temperatura media del pianeta.

In Italia lo sanno bene i cittadini dell’allora Repubblica Marinara di Pisa… oggi nell’entroterra…

Ma in questo caso… a chi diamo la colpa? Al mare che si è ritirato a causa dell’aumento della concentrazione di sale? Oppure alla terra che si è innalzata a causa della spinta dell’Africa verso nord? Diamo la colpa un po all’uno e un po all’altro? O cosa?

Questo per dire che, secondo me, bisognerebbe fare un piccolo passo indietro e soffermarci un tantino di più ad osservare direttamente ciò che avviene in Natura… e non passare intere esistenze davanti al monitor di un pc cercando di far quadrare i conti in modo da sapere se fuori piove o c’è il Sole. Basterebbe alzarsi, aprire la finestra e mettere il naso fuori!

😉

Bernardo

Attività Solare

Bernardo, hai messo molta carne a cuocere con il tuo commento.

.

In merito all’analisi statistica ho un’idea leggermente diversa dalla tua. Le ricostruzioni del livello del mare sono possibili solo utilizzando questi metodi, rinunciare ad essi significa rinunciare a tentare di modellare il livello del mare ed a cercare di quantificare le cause della sua variazione.

.

In merito all’influenza dei fattori geologici sul livello del mare gli autori sono riusciti a tenerne conto: nel post non ne ho parlato in maniera dettagliata, ma il loro modello matematico ne tiene conto anche se in maniera probabilistica.

Nel frattempo ho avuto modo di leggere integralmente il lavoro per cui, nel complesso, ho l’impressione che abbiano operato al meglio delle loro possibilità. Posso aggiungere che i risultati sono stati replicati con ben due metodi di analisi statistica: il filtro di Kalman ed il metodo GPR. Con questo, ovviamente, non intendo assolutamente dire che il loro lavoro rappresenta la verità assoluta, ma offre un ulteriore contributo ad una materia piuttosto ostica. Ciò che mi preoccupa è la conclusione del loro studio: quanto da essi accertato deve essere tenuto presente nell’aggiustamento dei modelli semi-empirici. Se tanto mi dà tanto, ho l’impressione che a breve ne vedremo davvero delle belle.

.

Altro aspetto importante del loro lavoro è che hanno utilizzato solo dati mareografici riservando quelli satellitari per verifiche di accettabilità dei risultati.

.

Circa le riserve che, mi sembra, avanzavi sui dati satellitari, probabilmente io ne ho più di te in quanto l’altimetro satellitare di GRACE ha dei problemi e alla fin fine tutti i dati devono essere riferiti a dei capisaldi terrestri che, nel caso di GRACE, sembra che non abbiano tutta l’affidabilità che si dice. E questo per non parlare dell’aggiustamento isostatico che è, probabilmente, una delle principali fonti di errore.

.

In merito al cenno che hai fatto a Pisa mi trovi poco d’accordo circa le cause del suo declino. La città è stata sempre piuttosto lontana dal mare e il suo porto era raggiungibile attraverso l’ultimo tratto del fiume Arno (quello tra Pisa ed il mare). Secondo le mie fonti (http://www.instoria.it/home/arno_pisa.htm) l’interramento del porto di Pisa vede tra i principali responsabili proprio il fiume Arno e, in modo particolare, i sedimenti da esso trasportati. Secondo il mio modesto parere le variazioni del livello del mare (di origine tettonica, termica o di massa) potrebbero aver influito, ma in maniera secondaria.

Ciao, Donato.

Scusa, avevo dimenticato di scriverlo: guarda la posta elettronica.

Ciao. Franco

Donato, intanto complimenti per aver reso in modo chiaro un articolo

piuttosto complesso.

Come scrivi, i dati del livello del mare sono pochi,

molto sparpagliati e distribuiti in prevalenza lungo le coste. Hanno quindi

bisogno di essere integrati, nello spazio e nel tempo, se si vuole tentare

di rappresentare il livello del mare in modo da poter discutere i meccanismi

fisici che lo regolano e il lavoro degli autori (e di molti altri) è

necessario anche se molto difficile.

Se guardo la fig.1 a) vedo un istogramma simmetrico e senza distosioni significative; vedo anche un’eccellente ricostruzione dei dati osservati, nel quadro b).

Gli autori fanno riferimento al quadro f) e sottolineano negativamente la presenza di

diversi “outliers” (direi dati che escono dalla fascia grigia di

confidenza); se è così, nel quado c) gli outliers sono la maggioranza e

anche il quadro e) non è in buona salute. Nel quadro d) una parte

significativa dei dati si comporta in modo opposto al modello, la cui fascia

di incertezza è veramente ampia, circa 10 volte quella del quadro c).

Secondo me questo dimostra la difficoltà del lavoro e la conseguente

incertezza delle conclusioni, così come le bande grigie di fig.2. Per

restare alla fig.2, se non ho sbagliato a leggere, la differente pendenza

deriva dal fatto che gli autori hanno tenuto conto del bilanciamento

isostatico di Groenlandia e Antartide: dato che il livello del mare è

praticamente uguale nella parte destra della figura (anni 2000) per tutte le

stime rappresentate, mi chiedo perchè il bilanciamento pesi di più a inizio

secolo o negli anni ’60 rispetto al periodo attuale; cioè perché la

correzione debba essere una funzione del periodo considerato e non, ad esempio,

della posizione geografica.

Franco (grazie, innanzitutto), per rispondere alla tua domanda bisognerebbe leggere l’intero articolo. Sulla base di quanto scrive uno dei co-autori in un commento su Realclimate uno dei principali pregi dello studio è la chiusura del bilancio tra dati mareografici e stima dei contributi fisici (assestamento isostatico, contributo termosterico e contributo di massa). Questo mi fa supporre che la ricostruzione del livello medio del mare operata dagli autori è riuscita a correggere la discrasia tra i due set di dati che, probabilmente, risultava maggiore ad inizio secolo rispetto ad oggi. La mia è, però, solo un’ipotesi desunta indirettamente dai commenti di autori e blogger. A proposito, tra tutti mi sembra particolarmente interessante quello su Realclimate firmato da stefan (dovrebbe trattarsi di S. Rahmstorf, un’autorità in fatto di livello del mare).

Ad ogni buon conto se consideriamo il modo in cui funziona l’algoritmo di Kalman utilizzato per filtrare i dati e per ricostruire la parte mancante degli stessi, l’ipotesi non è del tutto campata per aria. Nell’articolo pubblicato su PNAS che sto cercando di approfondire meglio, viene spiegato il modo in cui esso funziona: dove i dati mancano viene utilizzato un set di dati desunto dai modelli che tengono conto dei contributi fisici al livello del mare. Dopo di che viene attivato il filtro che opera come una “pialla” in avanti ed all’indietro in modo iterativo fino ad ottenere una ricostruzione che salvaguarda le osservazioni (residui bassissimi e perfettamente simmetrici). Da ciò dobbiamo desumere che i dati ricostruiti nelle zone dove mancano quelli mareografici, sono derivati dal modello matematico fisico. Se ciò consente da un lato, di far quadrare il bilancio, dall’altro rende il risultato piuttosto incerto (bande di confidenza molto ampie). E’ ovvio, però, che le incertezze del risultato finale sono notevoli e ciò spiega anche la correzione molto forte rispetto alle altre ricostruzioni. Ciò per il passato. Per i tempi più vicini a noi le differenze tra il modello fisico e le misure mareografiche forse sono minori per cui la correzione è inferiore o nulla.

In merito ai quadri della fig. 1 le tue considerazioni sono condivisibili: i dati esterni alle fasce di incertezza e la differenza delle ampiezze delle fasce di incertezza evidenziano bene la difficoltà del lavoro svolto dagli autori.

Ciao, Donato.