C’è un problema ricorrente nell’ormai vastissimo pianeta della ricerca, delle discussioni e delle analisi climatiche: i dati osservati tendono a differire da quelli simulati, dai prodotti dei modelli climatici. Sono differenze quasi sempre per difetto a danno delle simulazioni. Prendiamo ad esempio le temperature globali, da quando praticamente tutti i microscopi sono stati puntati su questo parametro e nonostante una previsione di aumento costante, la curva delle temperature non ha mostrato alcuna variazione significativa. Ma ce ne sono anche per difetto, o ancora, contemporaneamente di segno opposto per lo stesso parametro. E’ il caso del ghiaccio marino, le cui osservazioni ne mostrano una costante e significativa diminuzione sulla calotta polare settentrionale e un altrettanto costante e importante aumento su quella meridionale. Le previsioni, di contro, sarebbero per una diminuzione su entrambi i poli, con un rateo che sottostima quanto sta accadendo al Polo Nord e ovviamente sbaglia completamente quel che succede al Polo Sud.

Queste simulazioni, come è noto, sono costruite concettualmente sul paradigma del contributo antropico alle dinamiche del clima, il pilastro che sorregge, sarebbe meglio dire foraggia abbondantemente, tutta la ricerca sul clima da ormai almeno due decadi. Le differenze di cui sopra quindi mettono il paradigma in discussione innescando sinistri scricchiolii alla base del pilastro. Comprensibilmente, una buona parte di quelli che abitano lo stabile tendono a mostrare un po’ di disagio e cercano di correre ai ripari.

Però, osservare il comportamento del clima, si sa, è estremamente difficile. C’è bisogno di serie storiche il più possibile lunghe ed affidabili. Il progresso tecnologico in questo senso ha dato un impulso incredibile a questo settore, ma quando si va indietro nel tempo, anche solo di qualche decade, la faccenda si complica paurosamente, perché si rende necessario un ricorso a dati di prossimità, cioè qualcosa che in assenza di osservazioni dirette di un parametro possa in qualche modo ricondurre ad una sua misura. Non solo, anche per i tempi recenti, in cui il sistema è stato inondato per esempio di dati provenienti da sensori satellitari – di gran lunga più abbondanti e completi – ci si trova di fronte a non pochi problemi. I satelliti invecchiano in fretta e vengono spesso sostituiti, i sensori che portano a bordo sono sempre più progrediti e quindi diversi dai precedenti, per cui raccordare le informazioni per garantire l’omogeneità e la continuità delle serie è molto difficile.

E qui si torna a parlare di ghiaccio marino, che poi è l’argomento del post di oggi, le cui dinamiche sono in qualche modo oggettivamente note solo da quando sono disponibili le osservazioni satellitari. Alcuni giorni fa, è uscito uno studio il cui messaggio principale ha attirato l’attenzione dei media e di una buona parte della comunità scientifica. Un messaggio chiaro e semplice: l’aumento del ghiaccio marino antartico potrebbe essere stato “per la maggior parte dovuto ad un errore nel trattamento dei dati provenienti dai sensori satellitari“. Il rafforzamento qualitativo di questa frase è importante, perché una semplice sovrastima derivante da questo errore sarebbe interessante ma non dirimente, una sovrastima ‘per la maggior parte’ (much è il termine che gli autori usano nel loro paper) imputabile ad esso, potrebbe invece finalmente contribuire ad annullare il paradosso di un pianeta che si scalda ma uno dei suoi poli si ghiaccia sempre di più, riconciliando le osservazioni con le simulazioni e con il paradigma di cui sopra.

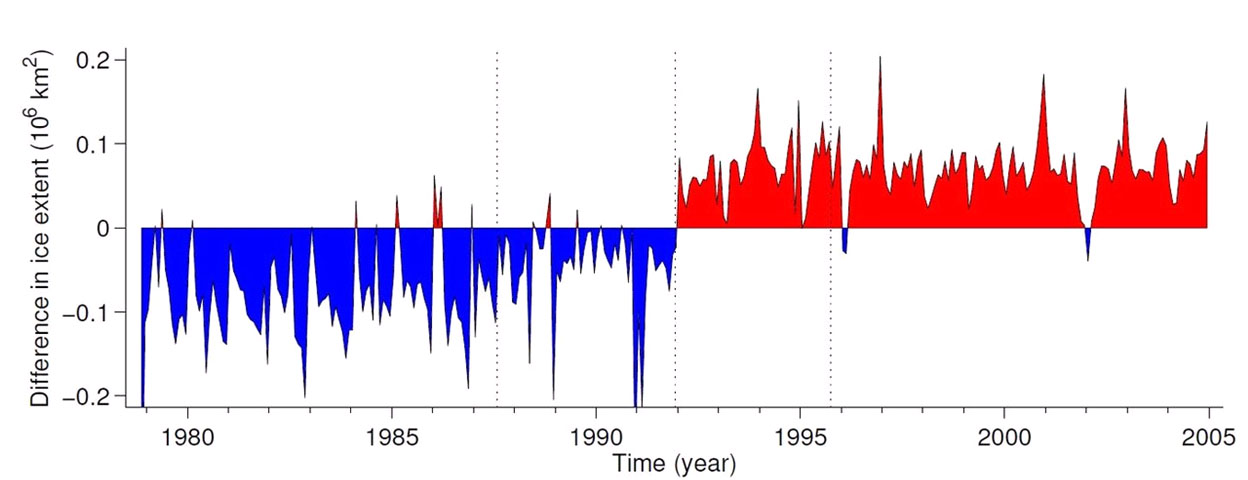

Sembra infatti che gli autori, incuriositi dalle conclusioni raggiunte nei report IPCC del 2007 e del 2014 (FAR e AR5) circa il ghiaccio antartico, nel primo caso privo di trend statisticamente significativo e nel secondo in aumento stabile, siano andati a ricontrollare gli strumenti e i dati per le valutazioni dei due report. E’ saltato fuori che l’algoritmo utilizzato per rendere edibili i dati provenienti dai sensori a microonde dei satelliti ha subito una modifica, un upgrade ad una nuova versione, nel 2007. Poi, ricontrollando i dati con entrambe le versioni di questo algoritmo hanno trovato un’incongruenza risalente al 1991, niente di particolarmente importante, tanto che gli stessi autori ammettono che tirar fuori eventuali errori in un segnale con tantissimo rumore come quello dell’estensione del ghiaccio marino è molto difficile, ma sta di fatto che sottraendo le due serie la differenza si vede. E si tratta di una sovrastima. Di quanto? Circa 200.000 Km2. Tenete a mente questo numero perché risulterà importante tra poco. Nel frattempo date anche un’occhiata all’immagine qui sotto in cui si mette in risalto la differenza.

Cosa è successo nel 1991? Semplice, c’è stato un cambio di satellite e quindi di sensori impiegati. Per cui è possibile che il primo codice trattasse i dati in modo diverso dal suo successore e la cosa ha iniziato ad aver peso con il cambiamento del sensore. La cosa più ovvia da fare sarebbe stata andarlo a vedere questo codice, ma nel paper non si trovano riferimenti a ricerche di questo tipo. Lo hanno fatto invece quelli di Nature News, come riportato in un articolo di Wired che ha efficacemente ricostruito questa storia. E quelli che si occupano di queste cose (per la cronaca i famosi codici si chiamano Bootstrap1 e Bootsrap2), hanno fatto sapere che tanto l’errore iniziale quanto la successiva correzione, da cui la differenza, sono stati introdotti accidentalmente, quindi senza alcuna documentazione che facesse saltar fuori prima il problema del 1991.

Ma è un problema? Beh, in termini di accuratezza delle informazioni lo è senz’altro, perché i dati devono essere il più possibile precisi, continui ed omogenei. E lo è anche in termini tecnici, come sottolineato sempre su Wired, perché evidentemente c’è qualche falla nelle procedure di verifica e documentaizone degli strumenti software impiegati nel mondo delle misure climatiche. Ma in termini quantitativi, riecco il numero, 200.000Km2 sono meno della sesta parte di 1.3 milioni di Km2, ossia di quanto è aumentato il ghiaccio antartico a partire dai primi anni di questo secolo. Ecco quindi che definire una ‘maggior parte’ quella che è invece piuttosto una minima parte, fa tornare alla mente gli scricchiolii del pilastro e il desiderio di porre rimedio al problema.

Alla fine, ammesso che un ‘salto’ nella serie ci sia effettivamente stato – l’analisi di questo paper dovrà essere vista alla luce delle indagini che gli autori del codice vorranno e dovranno fare – si tratta comunque di una tempesta in un bicchier d’acqua. Sarà pure on the rocks, ma è sempre un bicchiere in mezzo ad un mare di ghiaccio.

Si Donato, il bias caldo (che non è un periodo geologico) ti ha indotto a entrare nell’argomento. Io invece dopo tutte queste discussioni ho provato la grande voglia di uscirne tanto da diventare architetto

Il problema dell’omogeneizzazione dei dati è enorme e, per quel che mi riguarda, è stata una delle cause che mi hanno spinto ad addentrarmi nel ginepraio della fisica dell’atmosfera. Sei o sette anni fa, infatti, su “Le Scienze” fu pubblicato un articolo riguardante la correzione dei dati delle temperature superficiali del mare (SST) a cavallo della seconda guerra mondiale e la cosa mi incuriosì molto spingendomi ad approfondire l’argomento. Attraverso quanto ho letto sulla questione e su quella ad essa collegate ho potuto rendermi conto che nel campo climatologico i dati sono soggetti a continue operazioni di omogeneizzazione basate su processi statistici che quasi mai possono essere soggetti a verifiche empiriche (per il semplice motivo che non possiamo replicare misurazioni di grandezze fisiche effettuate decenni se non secoli fa). Da qui la necessità di introdurre margini di incertezza piuttosto ampi da cui si estrae il valore medio che diventa l’oggetto su cui si scatenano le discussioni.

Nel caso delle temperature atmosferiche globali, per esempio, i trattamenti di omogeneizzazione tendono a far sparire le periodicità presenti nei dati grezzi e, in particolare, tendono a “raffreddare” le temperature del passato ed a “riscaldare” quelle di oggi.

Dove i problemi diventano molto sentiti, però, è nel campo delle rilevazioni satellitari. Se si da un’occhiata ai grafici delle TSI (irradianza solare totale), per esempio, appare enorme la differenza tra le misurazioni effettuate dai sensori dei vari satelliti: http://spot.colorado.edu/~koppg/TSI/TSI.jpg .

.

E’, quindi, necessario procedere a delle operazioni di omogeneizzazione dei dati e qui cominciano i problemi. Non potendosi effettuare operazioni di misura della stessa grandezza con strumenti diversi (cosa che, come leggiamo in tutti i manuali che si occupano di metrologia, consentirebbe di individuare gli errori sistematici e, quindi, omogeneizzare in maniera corretta le serie strumentali) si ricorre agli algoritmi automatici con tutte le conseguenze che ciò comporta. In questo caso, mi pare di capire, il problema è ancora più complesso in quanto oltre ad un cambio di strumentazione di misura, vi è stato anche un cambio dell’algoritmo di elaborazione del segnale. Il risultato è quello che ci ha illustrato G. Guidi: un errore che altera il significato fisico dei dati.

Piuttosto che sull’entità dell’errore e sul suo significato in termini di “polemica climatologica” vorrei sottolineare una considerazione degli autori dello studio. Essi giungono alla conclusione che non sono in grado di stabilire se l’errore sia da cercare nel primo algoritmo (Bootstrap 1) o nel secondo algoritmo. In altri termini non siamo in grado di accertare se era il primo algoritmo a sottostimare l’estensione dei ghiacci antartici o il secondo a sopravvalutarli. Speranze di risolvere la questione? Secondo me, poche in quanto, dal punto di vista strumentale, mancano delle sovrapposizioni di dati in grado di consentirci di individuare l’errore sistematico. Dal lato del software, inoltre, reputo piuttosto difficile scoprire il bug nel software di elaborazione dei dati grezzi in quanto, considerando il modo in cui vengono assemblati buona parte dei programmi informatici, ho seri dubbi che si riuscirà a risalire all’errore (a volte neanche l’autore del programma riesce a ricostruirlo e, a volte, vengono assemblati “pezzi” di software i cui autori sono addirittura passati a miglior vita). 🙂

Ad ogni buon conto chi si occupa del software ha messo già le mani avanti: “tanto l’errore iniziale quanto la successiva correzione, da cui la differenza, sono stati introdotti accidentalmente, quindi senza alcuna documentazione che facesse saltar fuori prima il problema del 1991”.

Una buona notizia emerge, comunque, dalla vicenda: la scienza è in grado di individuare i suoi errori. Sarebbe una notizia ancora migliore se anche gli scienziati (o, per essere più precisi, alcuni di essi) e soprattutto gli “attivisti” si rendessero conto di come la scienza non sia infallibile e di come le sue conclusioni siano vere fino a prova contraria (come si legge in tutti i manuali di fisica del liceo 🙂 ).

.

p.s.: nessuno ha pensato di indagare anche sui sensori e sugli algoritmi di calcolo dell’estensione dei ghiacci marini artici? Anche per essi si nota qualche “shift” che induce qualche perplessità (almeno a me). 🙂

Ciao, Donato.

Donato, perché si dovrebbe? Quelli confermano il paradigma!

gg

Stando alle ultime notizie sembra che l’errore sia già stato individuato e corretto da tempo. Questo è quanto sostiene il dr. Comiso autore dell’algoritmo di omogeneizzazione tra i dati satellitari. In particolare sembra che l’errore si annidasse in Bootstrap 1 e la versione 2 del software ha corretto il bug.

http://www.livescience.com/46914-antarctica-sea-ice-expansion-controversy.html

.

Vorrei chiudere con una considerazione circa il modo in cui il caso sia stato trattato a livello di divulgazione scientifica (lo so, è un mio pallino, ma non posso farci nulla 🙂 ).

Leggendo l’articolo di Live Science si nota che l’autrice è completamente appiattita sulle posizioni del dr. Eisenman e, nonostante le sentite rimostranze del dr. Comiso che non esita a definire “disinformante” il paper di Eisenman, chiude il suo “pezzo” rilevando che il dr. Eisenman sta continuando nella sua opera di individuazione e correzione dell’errore! 🙂

Probabilmente per Comiso si può citare l’antico detto “Cicero pro domo sua”, ma se lui asserisce che ha rilasciato “Bootstrap 2” per correggere “Bootstrap 1” almeno bisogna prendere atto che si tratta di un fatto di estrema importanza e che la carta di Eisenman è arrivata …. seconda o, per essere cattivi, è inutile.

Questo sempre a proposito del “bene” che certa divulgazione scientifica (“ufficiale” e riconosciuta) fa alla scienza! 🙂 🙂

.

Sempre a proposito di divulgazione scientifica “efficace” una piccola chicca dall’ANSA:

http://www.ansa.it/sito/notizie/topnews/2014/07/29/polo-sud-inquinato-prima-delluomo_d4515402-638b-47df-a35c-3f9c0f804b86.html

E’ breve, siete invitati tutti a leggerlo!

.

p.s.: Se non ho sbagliato a fare i conti e trascurando l’estensione dei ghiacci marini dovrebbe trattarsi di 0,000047 g di piombo per metro quadrato. A parte la curiosità di come abbiano fatto a trovarlo, può tale quantità “soffocare” l’Antartide?

Ciao, Donato.

Faccio una scommessa: non l’hanno misurato, è l’output di un modello.

Scommessa persa; in realtà hanno fatto 16 carotaggi:

http://phys.org/news/2014-07-industrial-pollution-explorers-south-pole.html

Dopo aver accertato, grazie al contributo di F. Giudici, il metodo di misura delle concentrazioni di piombo in Antartide e, quindi, risposto alla prima parte del mio quesito (la curiosità, per la precisione 🙂 ) veniamo alla seconda parte del quesito, cioè se il quantitativo di piombo accumulatosi in Antartide è sufficiente a “soffocare” il continente.

Premesso che, in ogni caso, sarebbe stato meglio se il piombo in Antartide non ci fosse mai arrivato vediamo di capire ciò che esso può provocare.

Per evitare di scrivere scempiaggini e/o accuse di “tuttologia” mi sono documentato:

http://books.google.it/books?id=drDdANdLIyoC&pg=PA49&lpg=PA49&dq=concentrazione+media+piombo+sul+terreno&source=bl&ots=ToVjj2JS0e&sig=P7r4avPm_MPAnHNJMQNWf1G8XNs&hl=it&sa=X&ei=SEfZU7vxKIPX7AbdiIHwDg&ved=0CDcQ6AEwBA#v=onepage&q=concentrazione%20media%20piombo%20sul%20terreno&f=false

.

Ho scoperto, pertanto, che, nel suolo, il piombo è il meno mobile dei metalli pesanti e che i suoi effetti tossici si verificano solo se esso viene assorbito dalle piante e, successivamente, dagli esseri che si cibano di tali piante. Nel caso dell’Antartide, a meno che uno non decida di sciogliere il ghiaccio e berlo, effetti su vegetali ed animali non vi dovrebbero essere per il semplice fatto che i vegetali, in Antartide, non ci sono ed i pochi animali presenti non si cibano del ghiaccio.

Nella malaugurata ipotesi in cui un povero esploratore avesse bisogno di bere acqua ottenuta sciogliendo il ghiaccio, potrebbe berla tranquillamente in quanto le norme vigenti prevedono che la concentrazione di piombo nelle acque potabili deve essere inferiore a 10 microgrammi per litro. Nel caso del ghiaccio antartico la concentrazione di piombo è sicuramente inferiore (di qualche ordine di grandezza) rispetto a tale limite in quanto il valore da me calcolato si riferisce al volume di un parallelepipedo a base quadrata di lato pari ad un metro ed avente altezza pari a quella della pila di ghiaccio accumulatasi negli ultimi 410 anni (non ho la più pallida idea di quanto sia, ma anche se fosse pari a 1 metro ciò che ho scritto sarebbe sicuramente vero). In altre parole non mi sembra che il piombo trovato in Antartide “soffochi” il continente: ne beviamo molto di più a norma di legge!

Siccome, però, tutto questo non c’entra un fico secco con il tema del post la pianto qui prima che G. Guidi mi banni in eterno da CM. 🙂

Ciao, Donato.

Grazie Guidi, queste sono informazioni proprio preziose se si deve dibattere qua e là di questi temi con i “catastrofisti” regimental…..

Grazie e complimenti. Come sempre un lavoro espositivo chiaro e competente.