Mi sono occupato già diverse volte del problema del contenuto di calore degli oceani. L’ultima occasione è stata un commento di un articolo scientifico pubblicato qualche mese fa. Grazie ad una segnalazione di G. Guidi, ho avuto la fortuna di scovare una lunga serie di articoli che si occupano dell’argomento e che sono stati recensiti da J. Curry nel suo blog.

Molto interessante mi è parso un articolo segnalato qualche settimana fa da G. Guidi:

The Little Ice Age and 20th century deep Pacific cooling a firma di G. Gebbie e P. Huybers.

Gli autori sulla scorta di una serie di misure effettuate oltre un secolo fa, di una serie di misure più recenti e degli output di un modello matematico che descrive l’evoluzione del profilo termico verticale dell’oceano in funzione delle temperature superficiali ed atmosferiche, ricostruiscono il contenuto di calore degli oceani nel corso di un millennio circa. Essi calcolano innanzitutto il contenuto di calore dell’Oceano Pacifico e dell’Oceano Atlantico nella seconda metà del XIX secolo sulla base dei rilievi effettuati dalla spedizione del vascello Challenger nel 1874/1875 e lo confrontano con quello ottenuto sulla base delle misure della missione WOCE che nel corso degli anni ’90 del secolo scorso ha provveduto alla misurazione di una serie di parametri idrografici in moltissimi punti della superficie oceanica terrestre, in particolar modo delle temperature oceaniche a varie profondità.

Gli esiti del confronto hanno consentito di acclarare che relativamente all’Oceano Pacifico, la zona compresa tra 0 e 1500 metri di profondità, circa, si è riscaldata in modo molto evidente. Viceversa la zona al di sotto dei 1500 metri ha fatto registrare un raffreddamento statisticamente significativo. Per l’Oceano Atlantico, invece, le cose sono andate in modo alquanto diverso: il riscaldamento ha riguardato tanto la superficie che le acque profonde (fino a 3500 metri). Dopo i 3500 metri si registra un raffreddamento anche delle acque atlantiche.

Gebbie e P. Huybers hanno utilizzato un modello matematico per ricostruire il profilo verticale di temperature in funzione del tempo ed hanno utilizzato i profili di temperatura verticale ricavati dalle misure di Challenger e WOCE, per calibrare il modello stesso. Sulla base dei risultati ottenuti, i due ricercatori concludono che la dipendenza del contenuto di calore degli oceani dalla temperatura superficiale non può essere considerata una relazione banale, ma una relazione estremamente complessa. In particolare il calore immagazzinato nella parte di oceano più vicina alla superficie, impiega tempi diversi per propagarsi agli strati più profondi dell’oceano. Le parti più profonde dell’Oceano Pacifico, per esempio, si riscaldano (raffreddano) anche diversi secoli dopo che si sono riscaldate (raffreddate) le acque più superficiali. L’Oceano Atlantico segue invece regole diverse, probabilmente a causa del diverso modo in cui agiscono le correnti termoaline. Per quel che riguarda le acque del Pacifico, gli autori sostengono che l’attuale raffreddamento delle acque oceaniche profonde è un effetto della Piccola Era Glaciale.

Le mie perplessità circa la metodologia utilizzata per lo studio, sono diverse. In primo luogo il volume oceanico indagato direttamente è estremamente ridotto (una piccola percentuale del totale) sia dal punto di vista temporale che spaziale. L’elaborazione modellistica riguarda un ampio intervallo temporale (diversi secoli) e una grossa percentuale della massa oceanica.

Mi sembra che ci troviamo di fronte ad un’estrapolazione piuttosto impegnativa: i risultati di circa due secoli di dati vengono utilizzati per sintonizzare circa 20 secoli di simulazione.

Altrettanto perplesso mi lascia il grande intervallo di incertezza che caratterizza i risultati ottenuti.

Lo scrivo quando i risultati di alcuni studi non mi piacciono e lo ribadisco anche per uno studio le cui conclusioni concordano con il mio pensiero: non mi sembra corretto utilizzare due pesi e due misure.

Tutto ciò premesso, le conclusioni dell’articolo sono piuttosto interessanti. In primis esso manda a carte quarantotto una delle spiegazioni più accreditate del cosiddetto “calore mancante” o “mannaro” che dir si voglia, ovvero di quel calore che non fa quadrare il bilancio energetico del sistema climatico terrestre. Secondo K.E. Trenberth il calore mancante si sarebbe inabissato nelle profondità oceaniche, determinando un aumento delle temperature delle acque abissali: il calore mancante si troverebbe, quindi, in fondo al mare. Stando ai risultati di questo studio, invece, ci vogliono secoli se non millenni perché il calore superficiale si propaghi agli strati più profondi dell’oceano: pochi decenni non sono sufficienti e, pertanto, questa ipotesi non sembra più idonea a spiegare la differenza tra gli output modellistici e le osservazioni. Questo vale però solo per l’Oceano Pacifico mentre per l’Oceano Atlantico il discorso è parecchio diverso e la tesi di Trenberth appare più plausibile.

Altro aspetto importante dello studio di G. Gebbie e P. Huybers riguarda la quantità di calore assorbito dagli oceani nel corso del 20° secolo. Stante la dinamica ipotizzata dagli autori, il riscaldamento delle acque superficiali sperimentato nel corso dell’epoca post industriale, non deve essere imputato esclusivamente al riscaldamento globale generato dalla CO2, ma per circa il 25% al calore ceduto dalle acque più profonde a quelle superficiali. Potremmo dire, quindi, che parte del riscaldamento globale atmosferico potrebbe anche essere conseguenza del raffreddamento delle acque profonde e, quindi, la sua origine dovrebbe essere fatta risalire al periodo caldo medievale. Insomma una bella botta alle certezze che circolano negli ambienti pro AGW.

Se la quantità di calore assorbita dagli oceani nel corso del 20° secolo è, pertanto, inferiore a quella prevista dagli studiosi, significa che anche i valori della sensibilità climatica all’equilibrio e di quella transitoria, devono essere rivisti al ribasso. E questa non è cosa di poco conto.

Le novità non finiscono qui, però. Sempre scorrendo la lista stilata da J. Curry, troviamo un altro articolo molto interessante:

CERA-20C: A Coupled Reanalysis of the Twentieth Century di P. Loyalaux et al.

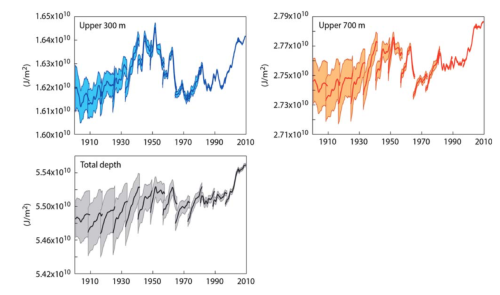

CERA è un modello accoppiato oceano-atmosfera e viene utilizzato dall’ECMWF per effettuare rianalisi recenti di parametri atmosferici ed oceanici. CERA- 20C è una versione del modello CERA che è stata implementata per ricostruire i parametri terrestri ed oceanici dell’intero XX secolo, utilizzando una griglia orizzontale con maglie di 125 km di lato e che si sviluppa su 91 livelli verticali. L’articolo citato si occupa di diversi parametri: temperature superficiali, pressioni, contenuto di calore degli oceani, cicloni tropicali e via cantando. Per quel che riguarda il nostro oggetto di discussione, ovvero il contenuto di calore degli oceani, bisogna considerare il capitolo 5 dell’articolo. In tale capitolo gli autori dopo aver illustrato i vantaggi nell’uso dei modelli accoppiati oceano-atmosfera rispetto a quello dei modelli non accoppiati, commentano i risultati ottenuti. Particolarmente istruttiva è la fig. 10 dell’articolo, di cui riporto un adattamento elaborato sulla base grafica estratta dal post di J. Curry.

In tale figura sono riportati i grafici rappresentanti il contenuto di calore degli oceani nel corso del XX secolo nella fascia superiore ai 300 metri di profondità (pannello in alto a sinistra) nella fascia superiore ai 700 metri di profondità (pannello in alto a destra) e quella dell’intera colonna d’acqua (pannello in basso). Dall’analisi dei diagrammi si può notare che il contenuto di calore della fascia più superficiale degli oceani, è aumentato nel periodo compreso tra l’inizio del secolo e la metà del secolo, raggiungendo il massimo valore tra il 1940 ed il 1960. Successivamente è sceso fino a portarsi ai livelli di inizio secolo e, dopo un breve periodo in cui ha oscillato intorno a valori mediamente bassi, ha ricominciato ad aumentare fino a raggiungere i valori attuali che, in ogni caso, sono più bassi di quelli degli anni ’50 del secolo scorso. Gli altri due pannelli evidenziano un andamento leggermente diverso, in quanto manca il massimo degli anni ’50 e l’incertezza delle misure è notevolmente più elevata. Gli autori fanno notare, infine, che l’incertezza dei risultati dipende in massima parte dalla carenza di osservazioni che vincolino il modello. Essendo il numero di osservazioni piuttosto ridotto alle maggiori profondità e nella prima parte del secolo, non stupisce l’ampiezza della banda di incertezza e l’andamento piuttosto discontinuo dei diagrammi.

Mi sembra che ci sia poco da aggiungere alle considerazioni degli autori: le misure disponibili nella prima metà del secolo scorso sono poche, soprattutto al di sotto dei 300 metri di profondità, per cui le stime del contenuto di calore degli oceani nelle acque profonde è molto imprecisa. Tali misure, inoltre, interessano volumi oceanici molto piccoli e, quindi, una percentuale molto ridotta della massa oceanica.

A questo punto appare evidente un fatto: il contenuto di calore degli oceani è una grandezza piuttosto incerta o, per essere più precisi, è piuttosto incerta la sua evoluzione storica. In altri termini non sappiamo quanto calore fosse contenuto negli oceani prima della metà del secolo scorso, per cui mi viene da sorridere quando sento parlare di incrementi senza precedenti del contenuto di calore degli oceani negli ultimi decenni.

Poiché gran parte dei modelli climatici sono dei modelli accoppiati oceano-atmosfera, in cui il contenuto di calore degli oceani gioca un ruolo molto importante, appare evidente che le incertezze che caratterizzano il valore del contenuto di calore degli oceani, si ripercuotono pesantemente nei risultati delle elaborazioni di questi modelli e, quindi, sugli scenari che essi delineano. Si potrebbe pensare, però, che le incertezze siano relegate al passato, per cui esse non dovrebbero influenzare le elaborazioni dei modelli inizializzati con le condizioni attuali. Non è proprio così, in quanto le incertezze sono piuttosto ampie anche sul contenuto di calore attuale degli oceani.

A quanto ammontano queste incertezze nella stima del contenuto di calore oceanico? A questa domanda fornisce una risposta, purtroppo parziale, un altro articolo recensito da J. Curry:

Towards determining uncertainties in global oceanic mean values of heat, salt, and surface elevation di C. Wunsh.

In questo articolo vengono esaminati gli errori di tipo stocastico commessi nella stima di alcuni parametri che caratterizzano gli oceani e l’atmosfera attraverso le elaborazione modellistiche. Tale analisi viene effettuata per il periodo compreso tra il 1994 ed il 2013 perché la mole di dati che caratterizzano questo periodo, è tale da consentire una loro trattazione statistica. Non si sono presi in considerazione gli errori sistematici, cioè quelli legati alle schematizzazioni fisiche dei processi di scambio termico atmosfera oceano ed al rumore legato all’elaborazione numerica, in quanto ciò richiederebbe una profonda revisione del codice di calcolo utilizzato.

Lo studio è incentrato su di un modello di circolazione oceanica globale (ECCO 4), ma i risultati possono essere estesi a tutti i modelli di circolazione globale esistenti. Wunsh parte da una constatazione piuttosto sconfortante: non è possibile determinare le incertezze insite negli output modellistici con metodi matematici rigorosi, in quanto tali metodi richiederebbero potenze di calcolo oggi non disponibili. Né è possibile una trattazione statistica rigorosa, in quanto i modelli di calcolo generano strutture deterministiche. Il procedimento utilizzato per la stima dell’incertezza, è, pertanto, di tipo euristico, ovvero basato su ipotesi particolari. Nella fattispecie l’ipotesi formulata dall’autore, è che per brevi periodi (venti anni sono un breve periodo per processi secolari se non millenari) le grandezze in gioco non sono in grado di strutturarsi e, quindi, rendono possibile una trattazione statistica dei dati e, pertanto, determinare i livelli di incertezza che li caratterizzano. L’ipotesi mi sembra plausibile, per cui i risultati ottenuti, possono essere condivisibili. Tralasciando il complesso armamentario matematico utilizzato dall’autore (chi sia interessato può attingere direttamente dal testo liberamente accessibile), lo studio consente di appurare che gli oceani, nel ventennio compreso tra il 1994 ed il 2013, hanno aumentato il loro contenuto di calore ad un ritmo pari a 0,48 ± 0,16 W/m2 inclusi 0,095 W/m2 di riscaldamento geotermico. L’incertezza associata a tale valore si aggira intorno al 30% circa (due deviazioni standard) e rappresenta il suo limite inferiore.

Tale tasso di riscaldamento degli oceani non è molto diverso da quello calcolato da Levitus per il periodo 1955-2010, per cui non credo di sbagliare se scrivo che il tasso di riscaldamento degli oceani è praticamente costante da oltre mezzo secolo.

Sono rimasto molto sorpreso dal fatto che il calore geotermico (vulcani, decadimento di nuclei radioattivi e via cantando) rappresenta un’aliquota considerevole del riscaldamento oceanico: poco meno del 20%. In passato ho avuto qualche scambio di opinioni con un lettore di CM in cui sostenevo che il calore geotermico avesse influenza trascurabile sull’aumento del contenuto di calore oceanico: alla luce di questo studio devo riconoscere pubblicamente che avevo torto.

Alla luce di quanto ho avuto modo di illustrare in questo articolo, giungo alla conclusione che le nostre conoscenze circa il contenuto di calore degli oceani sono piuttosto limitate e che ciò dipende sia dal ridotto numero di rilievi effettuati (da un punto di vista spaziale e da un punto di vista temporale), sia dalla scarsa conoscenza delle dinamiche con cui il calore si trasmette all’interno degli oceani.

Altro aspetto di estremo rilievo è che una percentuale notevole (oltre il 40%) del contenuto di calore oceanico, dipende da cause cui io non avevo mai pensato: il raffreddamento delle acque abissali ed il calore geotermico. Questo comporta, come ho già avuto modo di scrivere, la necessità di una drastica riduzione dei valori della sensibilità climatica all’equilibrio e di quella transitoria, una drastica revisione delle cause che determinano l’innalzamento del livello del mare (relativamente alla componente sterica, ovvero volumetrica legata alla dilatazione termica) e, quindi, delle ipotesi a base dei modelli empirici del livello del mare.

Bisogna, infine, rivedere molte delle ipotesi a base dei modelli di circolazione globale accoppiati oceano-atmosfera. E questo non lo dico solo sulla base di quanto ho letto negli studi citati, ma anche sulla base di un report interno alla NOAA che nella post fazione, scrive a chiare lettere che

For the ocean, almost all of the net energy of the earth from the sun is absorbed in its volume from the surface to the bottom. More quantitatively, in the atmosphere/ocean system, approximately 95 percent of the heat is in the ocean. Therefore, it is essential that scientists know where this heat is being stored in the ocean water column, and how it might be impacting the circulation of the ocean, not just in the near surface region, but also at depth.

Questo tema viene sviluppato ed approfondito nel corso della post-fazione fino a giungere alla conclusione che le previsioni dei modelli matematici potranno essere precise solo nel momento in cui riusciremo a conoscere in modo corretto tanto i valori delle temperature superficiali (regolate dalla CO2 e dal particolato e dalle nuvole, aggiungo io), quanto il contenuto di calore degli oceani. Oggi come oggi la conoscenza del contenuto di calore degli oceani, è molto approssimativa per cui non siamo in grado di modellarlo in modo soddisfacente e, quindi, i modelli matematici di previsione del clima ne risentono in modo considerevole. Nonostante tutto ciò decisori politici, attivisti climatici ed ambientali e via cantando ci assicurano che abbiamo una ventina d’anni per mettere le cose a posto riducendo drasticamente le emissioni. Ne sarebbero convinti il 97% dei climatologi, sulla base degli output dei modelli matematici, anzi di una suite di modelli matematici.

@ F. Zavatti

.

Caro Franco, la tua curiosità “cattiva” è anche la mia. 🙂

Io credo, però, che un’incertezza al livello del 30% sia già una buona base di partenza per tentare di capire dove si va a parare. Teniamo presente che quest’incertezza è stata determinata considerando un piccolo intervallo temporale per eludere le incertezze (forse ancora più sostanziose) “sistematiche”. L’autore dell’articolo che si occupa di modellazione a tempo pieno, ha onestamente dichiarato che non siamo in grado di determinare in modo esatto le incertezze totali delle stime dell’OHC. Possiamo perciò affermare che tutti gli scenari delineati dai modelli di circolazione globale, sono fortemente incerti a causa di queste incertezze sistematiche e casuali insite nei dati che essi elaborano e nei codici di calcolo.

E questo giustifica il tuo essere “talebano” circa alcuni argomenti attinenti il clima di cui ti lamentavi qualche giorno fa. 🙂

.

Circa la discussione sul calore geotermico mi sembra che tu abbia ragione anche se fu più intensa con B. Mattiucci. Su diversi aspetti del suo argomentare continuo ad avere dei dubbi, ma su questo punto credo che egli avesse ragione (ed anche tu, se non ricordo male) ed io torto (almeno in parte).

Ciao, Donato.

@ robertok06

.

Roberto, concordo con gli autori dell’articolo da te citato circa l’influenza delle nubi e del particolato sull’equilibrio termico del pianeta. Così come concordo circa il fatto che ignoriamo la dinamica con cui le nuvole interferiscono con l’equilibrio radiativo dell’atmosfera. Purtroppo i modelli non riescono a schematizzare in modo soddisfacente la copertura nuvolosa e, quindi, non riescono a restituirci risultati attendibili.

.

Da profano (non sono un modellista 🙂 ) non posso evitare di farmi una domanda. Sulla base di quanto hai scritto tu e di quanto ho scritto io, possono individuarsi due grossi problemi che affliggono i modelli: la difficoltà di schematizzare il contenuto di calore degli oceani, e la difficoltà di modellare la copertura nuvolosa e la trasparenza dell’aria. Ce ne sono anche altri di problemi, ma fermiamoci a questi due su cui non mi sembra che ci siano dubbi.

Secondo me solo questi due problemi dovrebbero far riflettere circa l’inattendibilità delle elaborazioni modellistiche, ma non sembra che la cosa importi più di tanto. Si continua a legiferare ed a tentare di modificare abitudini e stili di vita degli esseri umani, sulla base degli scenari che essi delineano, come se tali scenari rappresentassero la verità rivelata. E’ assurdo, ma è così. O sono cieco io o loro, non c’è alternativa. 🙂

Ciao, Donato.

Caro Donato,

ho letto con interesse il tuo articolo che mi è sembrato un eccellente compendio di alcuni lavori sull’OHC.

In particolare il lavoro di Gebbie e Huybers mi vede molto favorevole alle conclusioni e nello stesso tempo, come per te, mi lasciano perplesso sia i dati (pochi e sparsi) che i modelli (immagino che non si possa fare altrimenti) e quindi, di conseguenza, i risultati e la loro incertezza che è davvero grande; mi spiace per la perplessità perché vorrei che i risultati di questo articolo, che sembrano una modellazione sensata più di altre, almeno pe il Pacifico, potessero essere confermati da una maggiore accuratezza.

Il secondo lavoro che citi (quello con i dati CERA-20) non lo voglio commentare perché le temperature CERA sono le stesse di un mio post (http://www.climatemonitor.it/?p=49877 ) in cui le temperature di alcune città risultavano sbagliate anche di diversi gradi (alcune erano giuste!). Nonposso immaginare come il modello possa aver massacrato l’OHC, anche considerando i problemi che tu evidenzi.

Gli errori nei modelli descritti nel terzo articolo mi sembrano plausibili anche se sarei curioso (curiosità cattiva!) di conoscere il limite superiore di questi errori, visto che il limite inferiore è del 30%.

Lo scambio di idee sul calore geotermico dovrebbe essere stato con me (lo ricordo ma non sarei in grado di ritrovarlo): in quell’occasione non conoscevo l’ammontare di questo calore, ma pensavo in particolare all’attività delle dorsali oceaniche. Certo che un valore di circa il 20% è notevole e può cambiare “la vita” degli oceani.

Ciao. Franco

Per accettare le conclusioni di queste pubblicazioni bisogna accettare che alcuni parametri siano elaborati stocasticamente o definiti “costanti” Salinità e quota effettiva delle misure sono stati aggiustati parecchio. Calcolando che la terra non è una sfera perfetta che il livello del mare può variare significativamente fra i poli e l’equatore, in seguito a variazioni del campo gravitazionale, delle correnti e della temperatura e le maree. La quota 150 a cui vengono effettuate la maggior parte delle misure è a dir poco aleatoria. Idem per la salinità viene definita con un valor medio quando le variazioni fra polo ed equatore. sono ben più significative e dipendenti dalla stagionalità.

Off-topic… scusate:

Ah!… ma se lo dice il climatologo Leonardo di Caprio… 🙂

https://www.qualenergia.it/articoli/la-crisi-del-clima-e-ancora-risolvibile-lo-dice-il-nuovo-super-modello-di-leonardo-di-caprio/

Buongiorno a tutti:

a proposito dell’aumento della temperatura globale negli ultimi anni, il “post-hiatus”, e’ interessante questo articolo recente… se non altro perche’ basato su misure e DATI piuttosto che i soliti modellini farlocchi:

“Changes in Earth’s Energy Budget during and after the “Pause” in Global Warming: An Observational Perspective”, N G Loeb et al , Climate 6 no3 (2018) 62

https://www.mdpi.com/2225-1154/6/3/62

Un piccolo estrartto dall’abstract, per non farla troppo lunga:

(SW TOA = short-wave top of atmosphere)

“The regional distribution of the SW TOA flux changes associated with the decreases in low cloud cover closely matches that of sea-surface temperature warming, which shows a pattern typical of the positive phase of the Pacific Decadal Oscillation.

Large reductions in clear-sky SW TOA flux are also found over much of the Pacific and Atlantic Oceans in the northern hemisphere. These are associated with a reduction in aerosol optical depth consistent with stricter pollution controls in China and North America.

A simple energy budget framework is used to show that TOA radiation (particularly in the SW) likely played a dominant role in driving the marked increase in temperature tendency during the post-hiatus period.”

Quindi: le alte temperature nella zona orientale del Pacifico, che furono alla base dell’aumento della Tglobal un paio di anni fa, ebbero come origine la Pacific Decadal Oscillation, cioe’ un fenomeno ciclico naturale presente da millenni.

L’altra cosa interessante e’ che sono stati i miglioramenti della qualita’ dell’aria in Cina (filtri alle centrali a carbone in primis) a metterci lo zampino come causa dell’aumento di Tglobal.

Riassumendo: i recenti aumenti della temperatura globale nulla hanno a che fare con l’aumento, peraltro piuttosto regolare… qualche parte per milione/anno… della concentrazione della terribile e velenosissima CO2 assassina… gas alla base della vita sulla terra, comunemente noto come “cibo per piante”.

Conclusione mia: la cricca IPCC mente sapendo di mentire, e’ sempre piu’ evidente. Stanno spacciando fake news pseudo-scientifiche per sdoganare l’ennesimo tentativo di rivoluzione sociale sul pianeta.

En passant pecunia non olet, inoltre… qualcuno si sta riempiendo le tasche per bene.

————

P.S.: l’articolo del 2018 che ho linkato sopra e’ il follow up di questo, del 2012, alcuni autori sono gli stessi:

“Advances in Understanding Top-of-Atmosphere Radiation Variability from Satellite Observations”,

N G Loeb et al, Surv Geophys 33 no3-4 (2012) p359-385

DOI 10.1007/s10712-012-9175-1

Una cosa interessante di questo studio e’ che…

“While the new satellite instruments discussed in this study have clearly advanced the state-of-the-art in cloud-radiation observational capabilities, there is a critical need to extend the length of these records over multiple decades and further improve their accuracy in order to quantify how clouds are changing in a warmer climate and how cloud changes impact the Earth’s radiation budget.”

… era importante (e lo e’ ancora, sono passati solo 6 anni da allora) raccogliere dati su vari DECENNI, e migliorare l’accuratezza di tali dati, prima di poter QUANTIFICARE il cambiamento della copertura nuvolosa e il suo cambiamento, e come questa possa avere effetti sul budget della radiazione dl pianeta Terra.

Strano, no? Perche’ il mantra climatocatastrofista della cricca IPCC recita che “the science is settled!”… e si sa gia’ tutto quello che serve… nuvole incluse (falso, ovviamente, sono una delle parti nei modelli climatologici farlocchi che e’ modellizzata in maniera piu’ approssimata, ci sono ampie prove nella letteratura specializzata).

Qual’è l’illusione truffaldina che sostiene la paranoia climatica?

Semplice, l’illusione che il clima deve essere (per decreto imperiale!) stabile.

Un conto è cercare di stabilire tutti i parametri e le interconnessioni che definiscono dal punto di vista fisico le modificazioni climatiche, e ciò è compito della Scienza; un altro è rincorrere l’illusione di usare la Scienza per modificare a piacimento il clima in funzione delle esigenze umane.

E’ ovvio che per l’economia globale un clima stabile e prevedibile sarebbe auspicabile: si eviterebbero i costi derivanti dagli eventi meteorologici estremi, ma non è altrettanto ovvio che si possa raggiungere questo obbiettivo attraverso politiche ambientaliste rivolte a ridurre la CO2 nell’atmosfera.

Anche se la CO2 ritorna ai livelli preindustriali, gli eventi meteorologici estremi ci saranno sempre, per il semplice fatto che le dinamiche meteorologiche (e di conseguenza climatiche, essendo il clima una media di eventi meteorologici) sono al di fuori della portata della volontà umana. Dovremmo essere in grado di evitare le influenze gravitazionali che cambiano la forma dell’orbita, evitare il vulcanismo, stabilizzare il ciclo solare, etc etc, e ciò è impossibile per gli umani e per la Scienza.

E come sempre, si ragiona con la media: prendo una colonna di acqua, la misuro a più altezze, mne faccio la media e confronto questa media con un altra media calcolata 100 anni dopo e dico: il mare si sta raffreddando (o riscaldando).

E con ciò? desidero che sia più caldo per il piacere di poter fare un bagno anche in inverno o desidero che sia più freddo perchè così fa piacere all’orso polare?

Rispetto alla prima media calcolata la seconda è (ovviamente) diversa; cosa accade? ALLARME!!! c’è una anomalia, la seconda media non è come la prima media… i polli di Trilussa si illudono che la media debba essere sempre la stessa, perchè se la media non è la stessa ci sono le catastrofi. Io non mangio polli, ma la media dice che ne ho mangiato uno, e con questa logica mediocre si assiste ad una decrescita infelice del metodo scientifico.

Ma, tra questi polli, ve ne uno che, per caso ha compreso l’evoluzione biologica?

Adattamento all’ambiente che cambia!

L’ambiente cambia e gli organismi cambiano, tutto cambia e niente è stabile e nella media, come gli illusionisti scientifici e non desidererebbero.

Se il mare si riscalda quello che accade e che gli organismi si adattano, si evolvono di nuovi ed altri si estinguono. Così come se si raffreddasse.

Si dice che con il riscaldamento e l’acidificazione stiamo perdendo le barriere coralline, ma non vi è nessuna regola che dice che le barriere coralline debbano esistere per forza, per i nostri gusti da vacanzieri e non vi è nessuna regola che dice che le barriere coralline vivono solo ed esclusivamente in un range prestabilito di temperature… la natura evolve, per fortuna, e non è neanche teleologica come ci illudiamo noi esseri umani. ed in effetti: https://www.eurekalert.org/pub_releases/2019-01/bu-nod012219.php i coralli si adattano nonostante le paranoie climatiche.

Arato da Soli, osservando le falci lunari e gli animali riusciva a pronosticare il tempo, al massimo per tre giorni.

Oggi, nonostante satelliti, computer, migliaia di scienziati, modelli, teorie… sempre tre giorni si riescono a prevedere (cioè a pronosticare).

Siano noi ad adattarci all’ambiente, non il contrario, anche conoscendo (ed è impossibile!) le dinamiche che governano il clima (o il tempo meteorologico), sempre tre giorni di pronostici riusciremo a fare, viviamo in un universo quantistico, probabilistico e non in uno deterministico, per cui, rassegniamoci… del futur non vi è certezza.

Il problema sostanziale che sto notando, consiste nel fatto che, ormai, una certa narrazione relativa al cambiamento climatico è diventata lo “standard del sistema”. Mi spiego meglio. Quando si parla di mainstream o, come preferisco, linea di pensiero principale, non ci si riferisce solo agli scienziati che si occupano di clima, agli attivisti o chi, come me, si interessa a queste cose per hobby, ma a chiunque si avvicini a queste problematiche.

Nei giorni scorsi ho avuto modo di parlare con docenti universitari che per mestiere fanno altro, ma che, per esigenze di “mercato”, devono occuparsi anche di clima. Nella fattispecie si trattava di orientare la scelta universitaria di alcuni studenti delle superiori, utilizzando quale grimaldello un concorso europeo sul clima e le tematiche ambientali in genere.

.

Nella presentazione (circa dieci minuti) il relatore si limitò a parlare genericamente di cambiamenti climatici, e ad una richiesta di maggiori chiarimenti da parte di uno studente, si limitò a rispondere che quello che aveva detto era ciò che sapeva, ma siccome quello era quanto sosteneva il 95% degli scienziati, bisognava crederci, altrimenti si era come i terrapiattisti, i no-vax, ecc., ecc.. Fine della discussione.

Nei giorni successivi ho cercato di spiegare in tre ore di lezione quel tanto che bastava per inquadrare in modo grossolano la materia. Non so se ci sono riuscito. 🙂

Possiamo, pertanto, dire che il mondo si divide in tre macro-gruppi: coloro che ai cambiamenti climatici non ci pensano neppure (e sono la maggior parte), coloro che seguono la linea di pensiero principale in modo più o meno acritico e una sparuta minoranza che cerca di capire e, dopo aver capito esprime posizioni “eretiche”. Sono presenti, ovviamente, posizioni più o meno sfumate tra questi grandi gruppi, ma la situazione è, grossomodo, questa.

In questo quadro diventa, pertanto, sempre più difficile contrastare le posizioni ideologiche che hanno preso il sopravvento e chi la pensa diversamente, si limita a fare azione di testimonianza, come penso di fare io.

Per il resto del mondo il clima è sempre stato stabile, ci sono state sempre le mezze stagioni, gli inverni non sono mai stati troppo rigidi e le estati mai troppo calde. Ora che il clima è cambiato, tutto va male e la colpa di tutto è solo ed esclusivamente del perfido uomo bianco occidentale di destra e di mezza età.

Ciao, Donato.