Era 4 Giugno 2010 quando su questo sito fu pubblicato “Desertificazione in Italia: dati vecchi ma allarmi nuovi“, in modo simile si vuole ora prendere in esame il caso della temperatura media in Italia dell’anno 2009, che ha trovato spazio su vari mass-media i giorni scorsi.

Il 22 Ottobre è stato presentato il ”Quinto Rapporto sul clima in Italia”, questo illustra l’andamento nello scorso anno dei principali indicatori climatici derivati dal Sistema nazionale per la raccolta, l’elaborazione e la diffusione dei dati Climatologici di Interesse Ambientale (SCIA), realizzato dall’ISPRA in collaborazione con il Servizio Meteorologico dell’Aeronautica Militare, l’Unita’ di Ricerca per la Climatologia e la Meteorologia applicate all’Agricoltura, Agenzie Regionali e Provinciali per la Protezione dell’Ambiente, il Servizio Informativo Agrometeorologico Siciliano (SIAS) e il Servizio Agrometeorologico delle Marche.

Alcuni dei titoli più “catastrofici”, che hanno seguito la presentazione del rapporto, sono stati:

“CLIMA, SECONDO IL RAPPORTO ISPRA, IL 2009 E’ STATO L’ANNO PIU’ CALDO DAL 1961” o “Clima: inarrestabile da 18 anni l’aumento delle temperature italiane” oppure “CLIMA: ITALIA “PIU’ CALDA” DEL RESTO DEL MONDO“. Altre fonti d’informazione hanno riportato quanto contenuto nel rapporto in modo più aderente alla realtà, ad esempio: “Il 2009 è stato il quinto anno più caldo dal 1961, con un’anomalia media di +1,19°C” oppure “Quinto Rapporto clima in Italia: confermata la tendenza verso il riscaldamento“.

Non desideriamo qui entrare sui contenuti scientifici del documento che si può leggere nella forma integrale a questo link (se avremo possibilità lo faremo in futuro), ma su quanto questa informazione si possa ritenere nuova tale da valere l’ennesimo “allarme” per l’opinione pubblica. Possiamo rileggere i quattro rapporti stilati negli anni scorsi dall’Ispra; le anomalie della temperatura media nazionale annuale nel periodo dal 2005 al 2009 sono state, relativamente alla media del periodo “freddo”1 del “Climatological Normals” (CLINO) 1961-1990 : +0.3 °C , +1.03 °C , +1.24 °C, +1.09 °C, +1.19 °C.

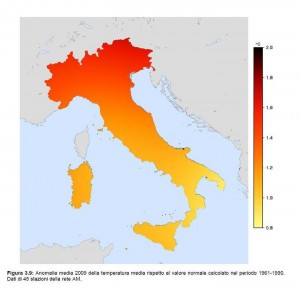

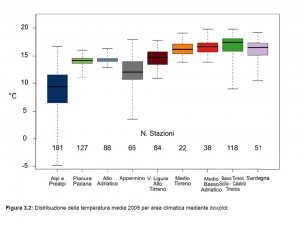

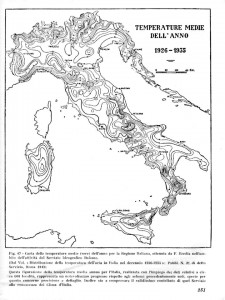

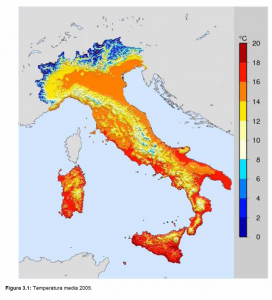

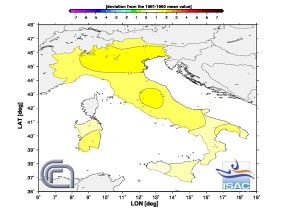

Inoltre andrebbe detto e “valutato”, come potete leggere in tutti i rapporti, che i conti dell’anomalia sono effettuati su 45 stazioni. Di fianco l’immagine a pag.44 del rapporto più recente dove è importante leggere didascalia, si deve osservare che a pag.10 dello stesso rapporto invece è scritto che le stazioni sono 47 (Fig_1), poco più di DUE STAZIONI A REGIONE.2 Per dare un’idea del miglioramento di copertura del territorio con la tecnologia, si può osservare per quanto riguarda le temperature medie, dalla pagina 37, che si sono utilizzati i dati relativi a 775 stazioni (Fig_2), circa 40 a regione, mentre ad esempio Eredia per il decennio 1926-1935 ne utilizzò 600 (Fig_3).

La differenza di stazioni utilizzate per il calcolo dell’anomalia e della temperatura media emerge anche dal confronto della risoluzione delle mappe per l’anomalia (Anno2009pag44.jpg) rispetto a quella della temperatura media annuale (Fig_4). Entrambe, anomalia e “temperatura media” annuali, sono scritte con la stessa incertezza: il valore è espresso fino ai centesimi di grado, l’errore non è fornito quindi presumiamo che sia dell’ordine dei millesimi. Concludendo, dalla lettura del rapporto mi sembra che si possa calcolare l’anomalia annuale della temperatura sull’Italia con sole 45 stazioni meteorologiche, i loro dati elaborati da un modello matematico forniscono un risultato espresso fino al centesimo di grado con esattezza (mentre i dati in ingresso sui messaggi meteorologici hanno una risoluzione del decimo).

Ma quanto è nuova quest’informazione climatica per cui nei giorni scorsi ci siamo preoccupati?

Durante la conferenza di Copenaghen furono diffusi molti avvisi del tipo “2000-2009: è il decennio più caldo degli ultimi 160 anni“, in questi articoli si parlava anche del “caldo” in Italia e, almeno per me sorprendentemente, ad inizio Dicembre 2009 già si diede la temperatura media italiana per l’intero anno 2009.

Ma l’ITALIA E’ “PIU’ CALDA” DEL RESTO DEL MONDO?

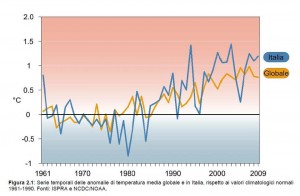

L’assurdità del confronto del dato “temperatura annuale media dell’Italia” con il dato “temperatura media globale” è il punto che scatenò le più forti critiche alla “Conferenza sui Cambiamenti Climatici” del 2007 organizzata dal Ministro dell’Ambiente Pecoraio Scanio supportato dall’Ispra di allora. All’epoca ci fu una generale critica della quale si fecero qualificati interpreti un gruppo di famosi docenti universitari italiani: “Inoltre vorrebbero che Pecoraro Scanio ammettesse l’errore dal momento che, secondo loro, definiscono addirittura “delirante”difendere un infortunio come quello del ministro sull’aumento delle temperature, definito pari a quattro volte rispetto a quello del resto del mondo. E’ quindi un’accusa che non punta il dito solamente sul metodo, ma anche sul merito della conferenza”. Oggi si torna, come se nulla fosse accaduto, ad effettuare di nuovo tale confronto, si ripete che l’Italia è più calda del resto del Mondo. Se non dovesse convincervi l’assurdità ed inutilità di tale confronto, e quindi vi dovrebbe allarmare che la dinamica della temperatura dei piedi di Vostra moglie è diversa da quella del corpo, guardate il grafico a pagina 10 (Fig_5 – IspraVSnoaa), forse sarà tranquillizzante osservare che nel 1961, inizio anni ’80 e ’90, la differenza era molto più grande dell’attuale senza che ci sia stato alcun cataclisma.

Ma quanto è nuova quest’informazione climatica per cui nei giorni scorsi ci siamo preoccupati?

Durante la conferenza di Copenaghen furono diffusi molti avvisi del tipo “2000-2009: è il decennio più caldo degli ultimi 160 anni“, in questi articoli si parlava anche del “caldo” in Italia e, almeno per me sorprendentemente, ad inizio Dicembre 2009 già si diede la temperatura media italiana per l’intero anno 2009.

Sapete come allora si piazzava il 2009 nella classifica degli anni più caldi?

Un anno fa scoprivano che era quinto proprio come riscopriamo in questi giorni. Infatti anche se i titoli erano “CNR: per l’Italia il 2009 anno dal clima più caldo“, nell’articolo si poteva leggere: “Secondo la banca dati del Climatologia storica dell’Istituto di scienze dell’atmosfera e del clima del CNR di Bologna (Isac-Cnr), il 2009, per l’Italia, è stato uno degli anni più caldi dal 1800 a oggi, avendo fatto attestare un’anomalia positiva di 1,15° C rispetto alla media delle temperature registrate tra il 1961 e il 1990”. Con la lettura del comunicato ufficiale del CNR dell’8 Dicembre 2010 si scopriva che: “Con il 2009, quinto nella classifica stilata dall’Isac-Cnr[…]“.

Quindi, SI TRATTA sicuramente di una coincidenza, ma l’8 Dicembre il CNR aveva già calcolato e diffuso quello che Ispra ha elaborato e comunicato indipendentemente il 22 Ottobre dell’anno successivo (con una piccola differenza di centesimi nei valori:1.15°C e 1.19°C). Praticamente stiamo ricevendo di nuovo la stessa informazione come se fosse una scoperta innovativa. Perché facciamo due volte la stessa cosa in tempo di crisi economica in particolar modo per la ricerca? I dati di partenza sono diversi o le stazioni sono sempre le stesse?

All’epoca il CNR scrisse nel comunicato: “l’anno appena trascorso (in climatologia gli anni si misurano da dicembre a novembre) presenta una anomalia positiva, cioè una maggior temperatura, di 1,15°C rispetto alla media del periodo assunto come riferimento, quello tra 1961 e 1990″, e si allegò un grafico (Fig_6) come potete verificare su vari siti3. Sul fatto che in climatologia gli anni si misurano da Novembre a Dicembre non ho spazio per approfondire in questa sede, la cosa però da notare è che se oggi si visita il sito del CNR relativamente al 2009 si trova un’altra cartina (la trovate anche qui perché con il cambio dell’anno climatologico credo sparirà dal web, anche se dopo quasi un anno c’è ancora scritto “The analyses are based on preliminary and not validated data“). Si legge che il valore dell’anomalia della temperatura media dell’anno 2009 è 0.89°C riferito al periodo 1971-2000 (non più 1961-1990), sempre quinto anno più caldo della serie.

Nei comunicati e rapporti del CNR ed Ispra sono presenti anche molte altre informazioni interessanti oltre alla “temperatura”, però queste sono state poco evidenziate dai mass-media. Ad esempio: l’Adriatico ed il mare di Sardegna sono stati mediamente i più freddi nel 2009. Ma allora come mai l’incremento di meduse e le specie aliene di pesci in Adriatico sui mass-media erano collegati all’effetto del riscaldamento globale sulla temperatura dell’acqua?

La dott.ssa Teresa Nanni nella parte del comunicato riguardante la precipitazione scrive: “Non dobbiamo poi dimenticare che, se consideriamo il periodo novembre 2008-aprile 2009, abbiamo registrato un primato: 54% in più della media climatologica del periodo 1961-1990, mai negli ultimi due secoli era piovuto così tanto in Italia nello stesso periodo“. L’Ispra aggiunge: “Il 2009 sembra confermare la tendenza ad un aumento delle precipitazioni al Sud, interrotta lo scorso anno. Negli ultimi otto anni al Sud le precipitazioni sono state sempre superiori alla media ad eccezione del 2008 e il valore medio della precipitazione cumulata annuale del 2009 si colloca al sesto posto della serie dal 1961. Viceversa, al Nord nel 2009 le precipitazioni sono state in media lievemente inferiori al valore normale, e dal 2003 l’anomalia media di precipitazione annuale è stata sempre negativa ad eccezione del 2008“.4

Vi sembrano dati da trascurare per un paese siccitoso ed in gran parte al Sud a rischio desertificazione dovuto al riscaldamento globale? Se sono otto anni che le precipitazioni sono superiori alla media al Sud, perché si continua ad allarmare le persone per la desertificazione sempre con gli stessi dati di una decina di anni fa?5

Il commento migliore a questa creazione di ansia continua lo lascerei a Nanni Moretti:

NB: su segnalazione dell’autore del post, è stata sostituita la figura 6, inizialmente editata per errore.

adm

Aggiornamento

Non siamo soli, anche Luca Mercalli si accorge sulle pagine de La Stampa che tra i dati Ispra e i dati CNR c’è qualcosa che non torna, e richiama l’attenzione alla necessità di non fare confusione. Bene, peccato che per evitare che si comprenda il problema e quindi per non pestare i piedi a nessuno, presenta i dati arrotondati al decimo di grado, così la differenza non si nota.

- Grossolanamente possiamo dire che dal 1950 al 1975 era talmente freddo che molti pensavano possibile l’arrivo di un nuovo periodo glaciale [↩]

- Cristofaro Mennella affermava che, vista la complessità del territorio, in Italia non si può parlare di “clima d’Italia” ma di “climi d’Italia”, da cui poi nasceva la difficoltà nel compilare previsioni meteorologiche. L’unica spiegazione è che con trascorrere del tempo l’Italia sia divenuta più omogenea da un punto di vista meteorologico per cui bastano poche stazioni per descriverla climatologicamente. [↩]

- http://www.meteogiornale.it/notizia/17208-1-anno-2009-il-quinto-piu-caldo-di-sempre-in-italia e http://www.ecoblog.it/post/9459/cnr-per-litalia-il-2009-anno-dal-clima-piu-caldo [↩]

- http://www.adnkronos.com/IGN/Sostenibilita/Risorse/Ispra-il-2009-e-stato-il-quinto-anno-piu-caldo-dal-1961-con-un-+119-C_311142925311.html [↩]

- http://www.climatemonitor.it/?p=10803 [↩]

I dati scambiati sul GTS non sono verificati.

Vi finiscono istantaneamente appena compilati, con tutti gli errori più comuni.

Per quanto riguarda le tempeste del ’99, i dati sul GTS lì erano e lì sono.

Chi attinge al GTS per vari motivi, ad esempio per fare l’analisi da cui far partire un run del modello numerico, fa propri test per cercare di scartare gli errori che si sa ci sono nel GTS.

E’ capitato che fossero scartati anche dati buoni, ma si tratta di due piani diversi.

In realtà ogni paese E’ responsabile della qualità dei dati messi sul GTS che dovrebbero avere un minimo di controllo real-time per verifica immediata dell’osservatore che dovrebbe comfermarli o meno. Purtroppo la realtà è un altra.

I test di verifica per analisi climatologica o pre-processing di modelli di previsione sono prevalentemente, oltre al controllo di coerenza e formale, su base statistica, sul passato, il problema è proprio qui. Un dato estremo spesso passa i test flaggato come poco affidabile, mentre sarebbe il più significativo dal punto di vista del contenuto informativo. Il probleama è culturale e concettuale, passare dal “controllo di qualità” finale all’ “assicurazione di qualità” nella produzione…quando mi arriva il dato dovrei essere certo della sua affidabilità. Ciò vuol dire lavorare sull’affidabilità della “linea di produzione” e non basta un Pc finale che faccia la selezione tra prima, seconda e terza scelta su base statistica e del passato. A presto.

Qunado ti arriva il dato, non devi essere sicuro al 100% della sua affidabilità.

I dati sono per molto tempo stati presi manualmente e tutti sapevano che contenenevano errori.

Per le previsioni meteorologiche è molto importante avere il dato immediatamente e la velocità va a scapito (accettabile) dell’esattezza.

Meglio approntare dei test a posteriori che avere un dato certo ma ormai vecchio. Così sono andate le cose e sono andate benissimo.

Sulle tempeste del ’99 non ne farei un caso.

Erano altri tempi e soprattutto erano altre risoluzioni.

Con i satelliti e con le nuove precedure di analisi, questi errori sono stati superati.

Ad ogni modo, i dati manuali, ma anche quelli automatici, avranno sempre errori che devono essere contemplati.

Per le analisi climatologiche, che non hanno tempi stringenti, possono attivarsi tutti i controlli che si vuole.

Il GTS è servito per la velocità e ha adempiuto al suo compito in modo eccellente.

Quando arriva un dato teoricamente dovrei essere certo del suo valore (similmente per una rete di rilevamento radioattività avrei “costosi” falsi allarmi o dati persi che non mi posso permettere), la certezza è impossibile ma debbo lavorare affinché posso avvicinarmi il più possibile al 100%. Il problema nasce proprio dal pensare che la soluzione sia il “filtro matematico” finale, credere che più tempo ho e più questo è preciso. Ciò PER ME me è sbagliato, l’affidabilità va ricercata nel processo e non nel filtro finale, quest’ultimo nel migliore dei casi porta solo ad eliminare informazione che non potrò più recuperare. Ad es. negli USA stanno mettendo doppia strumentazione nelle stazioni climatiche della rete di riferimento, se c’è qualcosa che non torna all’operatore viene richiesto di verificare la misura, ma va fatto immediatamente altrimenti il dato è perso.

Le tempesta Lothar e Martin sono state un vero e proprio caso, all’epoca si era tornato a tracciare in sala previsioni le “carte a mano” (con tutti i bollettini) per confrontarle con quelle automatiche, per poi verificare le differenze. Ci sono molte analisi critiche sull’accaduto, es. “There were data, particularly one SHIP, which were not used correctly and flagged. The main point is that these developments were, in principle, predictable since medium range forecasts showed correct developments. It was more a problem of data assimilation and the mis-use of data by the models somehow caused the cyclones to be lost.” su http://www.zamg.ac.at/docu/Manual/SatManu/main.htm?/docu/Manual/SatManu/Catastrophic/991225/index.htm

Che il GTS sia stato un grande passo avanti sono d’accordo, come credo tutti. Il grande passo però sarà rendere le osservazioni “quasi certe” come lo sono i servizi forniti da qualsiasi azienda evoluta, per questo non basta il “controllo di qualità” ma si dovrà arrivare in meteorologia all’assicurazione di qualità ed alla “qualità totale”. Non sono più problemi statistico matematici ma organizzativi. A presto

“Perché facciamo due volte la stessa cosa in tempo di crisi economica in particolar modo per la ricerca? I dati di partenza sono diversi o le stazioni sono sempre le stesse?”

La mappa del CNR è ottenuta dai dati delle stazioni sinottiche che sono scambiati nel GTS (global telecommunication system) e che sono immediatamente disponibili a livello globale.

Questi dati però risentano di quei casi strani in cui, ad esempio, una stazione è chiusa la notte, per cui non riporta tutte le 24h.

E’ un’operazione a costo quasi nullo per il CNR fare tali calcoli.

La mappa nel rapporto ISPRA è invece fatta con i dati completi delle 43/45 stazioni sinottiche dell’AM e, forse, sono verificati.

Per quanto riguarda le anomalie, che sono quelle che appaiono sulle figure, sul fatto che i dati siano stati presi in modo omogeneo nel corso dei decenni e che eventuali modifiche siano state considerate, ecco, qui c’è di mezzo il mare, anzi forse un oceano.

Non ci metterei sul fuoco, non dico un braccio, ma neanche un capello sulla bontà di tali elaborazioni di correzione del trend.

Stessa opinione per quanto riguarda i dati delle 770 stazioni che sono servite per il calcolo delle medie.

Concordo su tutti i tuoi dubbi. Credo sia quasi certo che entrambi attingono allo “stesso produttore” e poi elaborano, la diminuzione delle stazioni che hanno una serie storica è il vero “hockey stick” (girato) di cui preoccuparsi in meteorologia, il grafico globale l’ho riportato su http://www.climatemonitor.it/?p=13111 . Se una stazione è chiusa la notte il problema sul calcolo della temperatura media non dovrebbe essere di facile soluzione, cmq scriveremo un post sul tema. I messaggi inseriti sul GTS già dovrebbero essere verificati, anche perché i dati estremi sono poco probabili, alto contenuto informativo, ma sono eliminati dai test statistici di qualità (la tempesta di Natale a Parigi fu un esempio “tragico” al riguardo, il pre-processing automatico eliminò tutti i dati che davano una caduta di pressione “straordinaria” sull’oceano che fu presa come errore). Grazie e ciao.

A proposito della banca dati CNR-ISAC vorrei sottolineare che la copertura nazionale dei dati grezzi e’ offerta dalle diverse reti gestite da altre Istituzioni. La banca dati di quell’Istituto, sulla scorta della quale si propongono poi le classifiche climatiche, e’ una banca dati che partendo dal ‘collect’ di altri gestori, omogenizza i dati grezzi secondo procedure di calcolo standardizzate (vedere i vari Nanni, Maugeri e Brunetti, per i riferimenti bibliografici)e poi stila le classifiche.

Quindi quelle temperature non sono le misurate: sono il risultato di un calcolo (vedere Hansen per capire la base di tutte le procedure) effettuato con analisi di prossimita’ tra stazioni.

Roger Pielke Sr. et al. gia’ nel 2007, nell’ormai famoso lavoro “Unresolved issues with the assessment of multidecadal global land surface temperature trends, evidenziavano come questi metodi considerati oggettivi da IPCC, oggettivi poi non sono, ma gli autori dimostravano anche e agevolmente nella loro analisi che quei metodi tendono a sovrastimare piccole differenze non dovute a fatti climatici ma dovute all’alterazione dell’uso del suolo e alla non omogeneita’ della distribuzione delle stazioni.

Pielke et al. proponevano anche un metodo legato alle re-analisi che appariva molto piu’ efficace nel tessere una maglia di dati omogeneizzati.

Devo dire che personalmente cercai di evidenziare questo fatto dell’influenza dell’uso del suolo anche nei processi di omogeneizzazione nella mia lecture sulla Biometeorologia del Convegno Nazionale sulla Terra Fluida di Ischia, ma proprio a quella lettura lo stesso Maugeri contesto’ le mie critiche e non mi fu offerto modo (meglio: il tempo) per replicare.

Devo dire anche che il Convegno si tenne nel giugno del 2007 mentre il lavoro di Pielke fu pubblicato successivamente ovvero alla fine del dicembre dello stesso anno.

Il metodo legato alle re-analisi che migliora considerevolmente la stima di una tessitura ‘omogenea’ delle temperature e basato sul fatto che dopo 2 o 3 run di programma l’influenza dei cambiamenti dell’uso del suolo diminuisce drasticamente e legare la temperatura superficiale al valore di una temperatura in quota permette di liberarsi dall’aleatorieta’ del concetto di ‘alcune stazioni vicine’ (vicine quanto e vicine sempre nello stesso modo??).

Un’altra considerazione interessante e’ che, come vediamo dall’articolo di FS, se nel giugno del 2007 chi pro e chi contro il sistema di omogenizzazione non potevano aver letto la proposta di Pielke uscita a dicembre, a me risulta che a tutt’oggi NON si sia fatta (soprattutto da parte dei pro) una analisi di sensitivita’ tra i due metodi e di anni ne sono passati tre: se pero’ nel frattempo ho perso delle pubblicazioni sul tema prego chiunque di aggiornarmi.

La discussione non e’ banale perche’ la storia delle classifiche ripetuta ossessivamente dai mezzi di comunicazione di massa e’ di fortissimo appeal per i politici, cosi’ come per la popolazione. Sarebbe veramente comico, se non tragico, vedere che alla prova dei fatti le classifiche risultino basate su un metodo scientificamente non corretto.

La rappresentazione del campo termico avviene con le isoterme, è simile alla cartografia con le isolinee. Pensi che qualcuno crederebbe ad una carta topografica dell’Italia sapendo che è realizzata sulla base di 50 punti o anche 700? I soli comuni d’Italia sono oltre 8000, mentre climatologicamente il territorio è molto complesso, come si può pensare di modellizzare il clima quando ogni luogo ha delle caratteristiche proprie, proprio quelle che poi rendono i prodotti locali tipici. Ma avete visto come la carta dell’anomalia non tiene conto neanche dell’orografia, delle aree urbane, etc. Si prendono poche stazione ed il resto è matematica, con un risultato fino ai centesimi di grado a cui tutti i quotidiani danno retta. Ciao