L’Intergovernmental Panel on Climate Change (IPCC) ne suo AR4 afferma che i modelli di circolazione globale (GCM) sono in grado di “riprodurre le caratteristiche dei climi del passato e dei cambiamenti climatici” (Randall et al., 2007, p. 601). Trattandosi di un’affermazione forte e in seguito ripetuta a più riprese in moltissime sedi, la stessa richiederebbe di essere corroborata da verifiche sperimentali, che dovrebbero essere richieste in modo stringente dagli stessi enti governativi che fanno uso di tali previsioni, ad esempio per orientare le proprie politiche in campo energetico (o semplicemente per scegliere il periodo in cui svolgere vertici quali quello di Copenhagen senza mettere a repentaglio la vita dei partecipanti).

COME DOVREBBE IDEALMENTE ESSERE UNA VERIFICA

Il modo standard per verificare le prestazioni di modelli di simulazione dinamica, descritto ad esempio in modo chiaro nel lavoro scientifico del 2004 “Modelling guidelines – terminology and guiding principles ” di Refsgaard e Henriksen, consiste nel far operare il modello su una serie storica (serie di taratura) e rispetto a questa tarare (alias calibrare, alias parametrizzare) il modello in modo che fornisca i migliori risultati minimizzando cioè l’errore rispetto ai dati osservati. A ciò dovrebbe poi seguire la validazione che consiste nell’applicare il modello ad un’altra serie (del tutto indipendente rispetto alla precedente) e verificare con opportuni indici statistici che l’errore sia accettabile per l’uso operativo. Certo, diranno i più avveduti, i GCM lavorano su tutto il sistema climatico per cui è impossibile trovare una serie storica indipendente. Per superare l’impasse si potrebbe ad esempio far lavorare il modello su due periodi (uno da utilizzare per la calibrazione e l’altro per la validazione) ma una tale attività, che non mi risulta essere mai stata condotta, è ovviamente possibile solo per i gruppi di ricerca che gestiscono i GCM, i quali (immagino) la effettueranno solo se adeguatamente stimolati.

Ed in effetti oggi, a quanto mi è dato di verificare in bibliografia, il metodo standard di cui sopra non viene utilizzato mentre invece sono reperibili:

- le analisi di sensibilità del modello

- le intercomparison

- le simulazioni paleoclimatiche

- le simulazioni su periodi recenti

Le analisi di sensibilità si riferiscono in genere a cosa succede se si apportano alcune modifiche alle variabili in input al modello (es. valori di attività solare, forcing antropici).

Le intercomparison (confronti fra modelli diversi) sono soggette alla seguente obiezione di fondo: il fatto che tutti i modelli si comportino in modo simile (e cioè che siano in “agreement” fra loro) non esclude che non stiano tutti sbagliando (Green, 2002).

Le simulazioni paleoclimatiche si riferiscono a climi più o meno remoti oggetto di indagini paleoclimatiche (es: climi degli ultimi 1000 anni o climi di epoche molto remote). Tuttavia tali attività sono spesso solo parzialmente soddisfacenti e ciò perché i climi del passato non sono noti attraverso misure di variabili fisiche atmosferiche ma solo attraverso proxies, spesso oggetto di contestazioni (si pensi ad esempio alla mazza da Hockey si Mann).

Le simulazioni su periodi recenti, riferite cioè grossomodo agli ultimi 150 anni, saranno trattate in dettaglio nel prossimo paragrafo.

SIMULAZIONI SU PERIODI RECENTI (ULTIMI 150 ANNI)

Negli ultimi anni sta emergendo un’interessante forma di verifica delle prestazioni dei modelli GCM che consiste nel confrontare le “previsioni al passato” effettuate da modelli con i dati recenti realmente osservati. Ciò potrebbe apparire lapalissiamo e tuttavia è raro trovare tracce di una tale attività svolta in modo sistematico. In tale settore si sta dando particolarmente da fare un gruppo di idrologi della facoltà di ingegneria dell’Università di Atene.

Gli idrologi sono utenti di primaria importanza delle simulazioni dei GCM, in quanto con questi sono spesso chiamati a far operare modelli idrologici che stimano contenuto idrico dei suoli, livelli del laghi, portate di fiumi, ecc. Da ciò deriva che lavorare su dati previsti di scarsa qualità ha gravi ripercussioni sull’accuratezza del loro lavoro.

In questa sede commenteremo i risultati di una verifica pubblicata molto di recente sulla rivista scientifica Hydrological sciences journal in un articolo il cui riferimento completo è:

Anagnostopoulos, G. G., Koutsoyiannis, D., Christofides, A., Efstratiadis, A. & Mamassis, N. (2010) A comparison of local and aggregated climate model outputs with observed data. Hydrol. Sci. J. 55(7), 1094–1110 (scaricabile gratuitamente da qui http://www.informaworld.com/smpp/content~db=all?content=10.1080/02626667.2010.513518)

Gli autori hanno lavorato sui dati mensili di 84 stazioni (di cui 29 termiche, 29 pluviometriche e 26 termo-pluviometriche) estratte dal dataset Climexp del Royal Netherlands Meteorological Institute e relative ad Eurasia, Americhe, Africa e Australia.

Per le verifiche si sono considerati sia GCM utilizzati per il report IPCC 2001 (TAR) sia GCM del report IPCC 2007 (AR4). La lista dei GCM è disponibile nella tabella 1 dell’articolo. Nello specifico per ottenere dai GCM una serie da confrontare con ognuno dei 55 punti, si è creata una serie storica da GCM interpolando i valori dei 4 nodi di griglia più vicini al punto in esame.

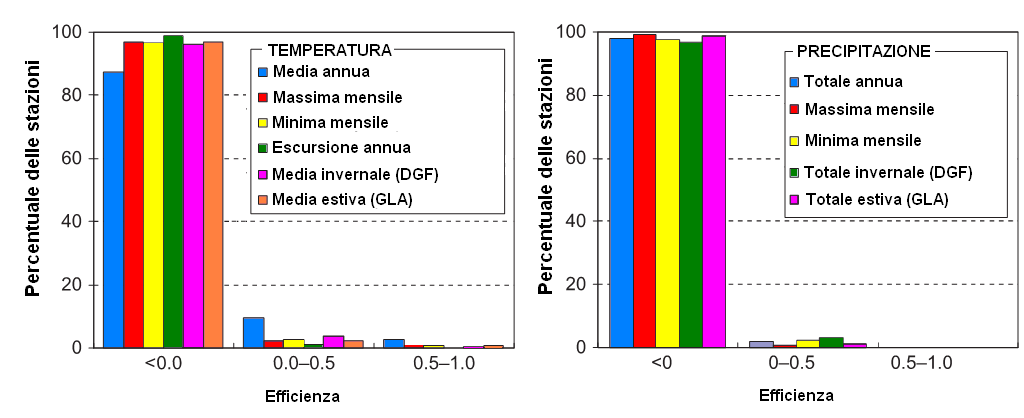

Dalle analisi statistiche emerge in sintesi che:

“I risultati variano a seconda della scala temporale indagata. A scala temporale mensile infatti i modelli riproducono generalmente la sequenza freddo-caldo e umido-asciutto per tutte le stazioni esaminate dando luogo ad un coefficiente di correlazione media (per tutte le stazioni e tutti i modelli) di 0.909 per la temperatura e di 0,256 per la precipitazione. Il coefficiente di efficienza medio è 0,721 per la temperatura e -0,433 per la precipitazione. Le statistiche sono drammaticamente più negative per la scala annuale. Il coefficiente di correlazione media scende notevolmente e il coefficiente medio di efficienza è negativo a prescindere dalla serie storica esaminata. Inoltre la deviazione standard è sistematicamente sottostimata.”

In proposito prego il lettore di prestare attenzione sia all’indice di efficienza (un modello con efficienza negativa non è in genere ritenuto adatto all’uso operativo) sia il coefficiente di correlazione (che esprime la percentuale di varianza spiegata dal modello ed il cui valore ideale è 1).

Gli autori in sostanza ci dicono che i modelli a scala temporale mensile:

- descrivono bene le ciclicità termiche stagionali (il che, avendo al loro interno un modello astronomico in grado di simulare la stagionalità del soleggiamento, è il minimo che ci si possa da loro aspettare)

- descrivono male le ciclicità pluviometriche stagionali (efficienza negativa)

Passando poi al livello annuale, in tabella 1 sono riportate le molto deludenti prestazioni dei GCM,

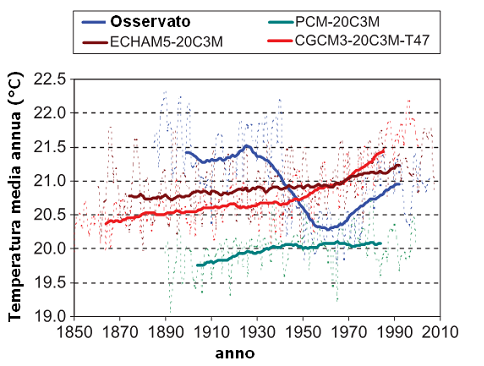

Un esempio grafico per la stazione di Durban (Sud Africa) è riportato in figura 1. Si osservi che i modelli presentati non descrivono in alcun modo la diminuzione delle temperature del periodo 1930-1970.

| TEMPERATURA | PRECIPITAZIONE | |||

| Coeff. Corr. medio | Efficienza media | Coeff. Corr. medio | Efficienza media | |

| Media/Totale annuo | 0.122 | -5.157 | 0.003 | -3.008 |

| Massimo mensile | 0.062 | -5.254 | 0.007 | -1.266 |

| Minimo mensile | 0.033 | -3.748 | 0.004 | -167.368 |

| Escursione annua | 0.008 | -4.068 | – | – |

| Media inv.le (dgf) | 0.051 | -3.865 | 0.002 | -3.75 |

| Media estiva (gla) | 0.073 | -7.495 | -0.001 | -12.168 |

Tabella 1 – Coefficiente di correlazione medio ed efficienza media su scala di lavoro annuale per temperatura e precipitazione (fonte – Anagnostopoulos et al., 2010). Tali indici pongono in evidenza il fatto che modelli e realtà sono due piani del tutto diversi. Nessun modello con efficienza negativa dovrebbe essere utilizzato per assumere decisioni di alcun tipo (nè per andare in ferie nè per decidere una politica energetica).

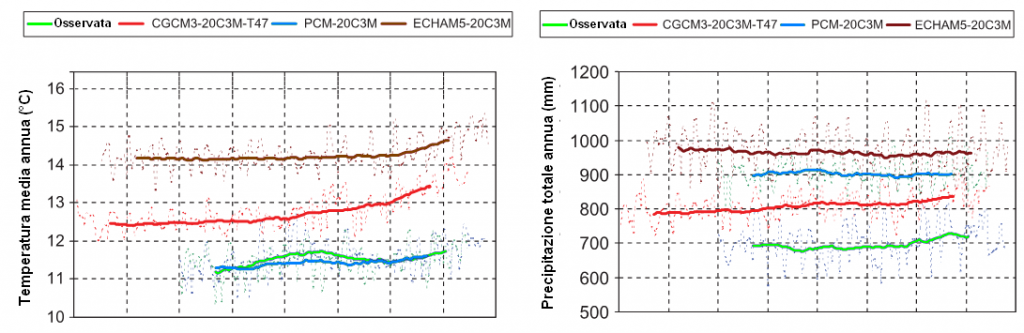

Occorre qui dire che un precedente lavoro di questo stesso gruppo di ricerca (Koutsoyiannis et al., 2008) e riferito a dati puntuali fu contestato da quanti – ad esempio Gavin Schmidt su Realclimate (2008) – sostenevano che i GCM offrono prestazioni accettabili solo a macroscala (scala continentale). Tali obiezioni rieccheggiano l’affermazione del report IPCC 2007 secondo cui “sussiste una notevole confidenza nel fatto che i modelli climatici forniscono stime quantitative credibili dei climi del futuro a scale continentali e oltre”. Alla luce di tale obiezione gli autori hanno eseguito una comparazione fra realtà e modello considerando le medie areali riferite per l’intera area degli USA. I risultati sono altrettanto deludenti di quelli puntuali ed in particolare “su scala temporale annuale, il coefficiente di correlazione presenta valori molto bassi, a volte vicino a zero o addirittura negativi, in tutte le serie storiche esaminate, mentre l’efficienza è sempre negativa.” Fra i diversi diagrammi pubblicati ne abbiamo scelto due che ci sembrano più immediatamente evocativi rispetto al problema posto dagli autori (figura 2).

Una ulteriore obiezione emersa in relazione al lavoro di lavoro di Koutsoyiannis et al. (2008) era riferita non alle scale spaziali ma a quelle temporali. In sostanza l’obiezione verteva sul fatto che i modelli non sarebbero in grado di descrivere in modo corretto il singolo anno ma che tale “instabilità” si sarebbe risolta operando su periodi più lunghi in modo da “allisciare” le variazioni di breve periodo. Per far fronte a tale obiezione gli autori hanno utilizzato medie mobili trentennali in luogo dei dati dei singoli anni. A seguito di tale “allisciamento” “il coefficiente di correlazione aumenta leggermente per temperatura e delle precipitazioni in tutte le serie temporali esaminate mentre invece il coefficiente di efficienza, mantiene nella gran parte dei casi valori fortemente negativi” (figura 3).

In complesso gli autori giungono alla seguente conclusione: “Si sostiene che i GCMs forniscono credibili stime quantitative dei cambiamenti climatici futuri, in particolare a scala continentale e oltre. Esaminando la performance locale dei modelli su 55 punti, abbiamo trovato che le proiezioni locali non si correlano bene con le misure osservate. Inoltre, abbiamo trovato che la correlazione ottenuta su larga scala spaziale, e cioè l’area degli Stati Uniti, è peggio di quella ottenuta su singoli punti.”

Ma gli autori si spingono oltre nella loro critica ai GCM sviluppando due tematiche importanti:

critica 1

“Una pratica comune di modellisti climatici e dell’IPCC è quella di operare confronti in termini di scostamenti dalla media (chiamati anche “anomalie”), piuttosto che con riferimento ai valori originali….. Riteniamo che l’uso dei valori originali sia molto importante, in quanto i risultati dei modelli presentano enormi differenze rispetto ai dati misurati (fino al 6°C per la temperatura e 300 mm annui per la precipitazione), differenze che divengono non visibili quando si opera in termini di scarto dalla media.

I GCMs calcolano il bilancio radiativo e, in accordo con la legge di Stefan-Boltzmann, la quantità di energia irraggiata è proporzionale alla quarta potenza della temperatura assoluta. Ciò significa che . il rapporto fra energia irraggiata a 15°C e a 12°C è (273+15)4/(273+12)4 =1.043. Per una differenza di 0.5°C anziché di 3°C il rapporto diviene 1.007. La domanda che sorge spontanea è su quali basi un modello che sbaglia di 3°C nel 20° secolo (paria al 4.3% dell’energia radiante) possa descriver in modo adeguato un trend decadico futuro dello 0.7% che è 6 volte più basso.“

critica 2

“Tuttavia, riteniamo che la questione più importante non è se un GCM può produrre una previsione credibile del clima futuro, ma se il clima sia o meno prevedibile in termini deterministici. Diverse pubblicazioni, ad esempio Rial et al. (2004), evidenziano le difficoltà che la complessità del sistema climatico introduce quando cerchiamo di fare previsioni. La complessità, in questo contesto si riferisce di solito al fatto che ci sono molte parti che costituiscono il sistema e molte interazioni fra queste parti. Questa osservazione è corretta e ci spinge ad un ulteriore passo avanti.” ….. e qui gli autori propongono un approccio stocastico alle previsioni climatiche, su cui magari torneremo in un prossimo scritto.

CONCLUSIONI

L’articolo di Anagnostopoulos pubblicato su Hydrological sciences Journal è aperto alla discussione fino ad aprile 2011. Pertanto chiunque abbia obiezioni circa il metodo adottato o l’interpretazione dei risultati è vivamente pregato di farsi avanti prendendo carta e penna e scrivere all’editor della rivista. Se tuttavia le conclusioni di Anagnostopoulos non fossero contestate in modo convincente, si porrebbe (per dirla con Roger Pielke Sr.) la questione sul significato dei considerevoli investimenti effettuati dai Governi per ottenere previsioni climatiche regionali per i prossimi decenni senza mai porsi il problema di verificare la loro accuratezza. A tale proposito per gli Usa Pielke chiama in causa la National Science Foundation.

RIFERIMENTI A SITI INTERNET

Il commento di Roger Pielke senior: http://pielkeclimatesci.wordpress.com/2010/10/22/very-important-new-paper-a-comparison-of-local-and-aggregated-climate-model-outputs-with-observed-data-by-anagnostopoulos-et-al-2010/

Il commento di Wattsupwiththat?: http://wattsupwiththat.com/2010/12/05/new-peer-reviewed-paper-shows-just-how-bad-the-climate-models-are/

BIBLIOGRAFIA

- Green J.S.A., 2002. Reflections on the Earth albedo: a collection of scattered thoughts, Weather, Vol. 57, december 2002, 431-439.

- Koutsoyiannis, D., Efstratiadis, A., Mamassis, N. & Christofides, A. (2008) On the credibility of climate predictions.Hydrol. Sci. J. 53(4), 671–684.

- Randall, D. A., Wood, R. A., Bony, S., Colman, R., Fichefet, T., Fyfe, J.,Kattsov, V., Pitman, A., Shukla, J., Srinivasan, J., Stouffer, R. J., Sumi, A. & Taylor, K. E., 2007. Climate models and their evaluation. In: Climate Change 2007: The Physical Science Basis. Contribution of Working Group I to the Fourth Assessment Report of the Intergovernmental Panel on Climate Change (S. Solomon, D. Qin, M. Manning, Z. Chen, M. Marquis, K. B. Averyt, M. Tignor & H. L. Miller, eds), 589–662 Cambridge: Cambridge University Press.

- Refsgaard J.C., Henriksen H.J., 2004. Modelling guidelines––terminology and guiding principles, Advances in Water Resources 27 (2004) 71–82.

- Rial, J. A., Pielke, R. A. Sr, Beniston, M., Claussen, M., Canadell, J., Cox, P., Held, H., de Noblet-Ducoudré, N., Prinn, R., ReynoldsJ. F. & Salas, J. D. (2004) Nonlinearities, feedbacks and criticalthresholds within the Earth’s climate system.Climate Change 65,11–38.

- Schmidt, G. (2008) Hypothesis testing and long range memory, blog post, Available from: http://www.realclimate.org/index.php/archives/2008/08/hypothesis-testing-and-long-term-memory/ [Accessed 22 August 2010].

Articolo davvero molto interessante. Grazie per le informazioni, adesso mi auguro di poter leggere anche la parte relativa all’approccio stocastico.

Il tema è un po’ il fulcro di tutta l’AGWT, e, fatte le debite proporzioni in termini di approfondimento, anch’io ho sentito il bisogno di scrivere un articolo in merito che mi è stato gentilmente pubblicato qualche settimana fa sul blog NIA.

C’è una frase che mi ha colpito (forse dovrei dire scandalizzato):

“Per superare l’impasse si potrebbe ad esempio far lavorare il modello su due periodi (uno da utilizzare per la calibrazione e l’altro per la validazione) ma una tale attività, che non mi risulta essere mai stata condotta”

Io davo per scontato che si fosse proceduto in questo modo! Altrimenti come sono stati eseguiti i back-testing? Che senso hanno le hindcast che ci vengono presentate? Le mie perplessità riguardavano aspetti più sottili, quali i dataset da utilizzare (e quelli inutilizzabili)come test data, ma avevo presunto che i dataset dei dati climatici fossero stati suddivisi in base a periodi pluriennali, e che qualcuno fosse stato utilizzato come training data e altri come test data. Se così non fosse, come mi sembra d’aver capito, non sapre nemmeno che significato assegnare ai GCM.

Non posso che confermare quanto da me affermato, nel senso che non sono fin qui riuscito a reperire in bibliografia esempi di approcci alla verifica dei GCM basati su calibrazione + validazione su dataset indipendenti. Tale fatto è da tempo per me motivo di cruccio poiché condivido con lei l’impressione che un tale approccio sia di importanza capitale per garantire la correttezza scientifica dei lavori (ad esempio nel mio settore di ricerca, che è quello della micrometeorologia e dell’agrometeorologia, chi non segue un tale approccio si vede a ragione i lavori di ricerca rifiutati dalle riviste scientifiche).

In proposito nella trasmissione Moebius di Radio 24 (il cui conduttore, Pedrocchi, si mostrò sensibile al problema, che gli segnalai scrivendogli una mail) ebbi un paio d’anni orsono un interessante confronto con l’amico dottor Stefano Tibaldi di Arpa Emilia Romagna (modellista con grande esperienza nel settore dei modelli meteo previsionali). Tibaldi convenne con me sul fatto che l’approccio basato su calibrazione + validazione su dataset indipendenti potesse essere interessante ma mi disse anche che a suo avviso i dataset disponibili non erano sufficientemente lunghi per poterlo operare.

Sempre al riguardo, e tanto per restare in tema di ingegneri ellenici, vediamo un po’ cosa scrive l’idrologo Koutsoyiannis (http://itia.ntua.gr/getfile/907/1/documents/hysj_54_2_394.pdf):

“La comunità idrologica è ben consapevole dell’importanza della validazione dei modelli con un insieme di dati indipendente da quello utilizzato per la taratura. La validazione è altresì necessaria anche in materia di valutazione di incertezza (si veda ad esempio, Montanari & Brath, 2004; Montanari, 2007).

I GCM dell’IPCC non sono soggetti a validazione (il termine “validazione” non appare neppure nel report IPCC AR4 del 2007) e pertanto l’affidabilità delle uscite di questi modelli, che sono per inciso sono correntemente utilizzati per valutare gli impatti sulle risorse idriche, non è da considerare testata.

…………………………..

Inoltre l’utilizzo di diversi modelli non validati per produrre insiemi di previsioni climatiche, prassi corrente nei rapporti dell’IPCC, non fornisce un base scientifica per la valutazione dell’incertezza. Al contrario, la base per valutare l’accuratezza delle uscite dei modelli GCM non può che essere costituita dal confronto sistematico con dati osservativi.”

PS: può cortesemente inviarmi il riferimento del suo articolo sul blog NIA?

Credo che sia questo

http://daltonsminima.altervista.org/?p=12754&cpage=1#comment-35987

Grazie Guido (Botteri), in realtà mi riferivo alla seconda parte:

http://daltonsminima.altervista.org/?p=12879. E grazie al prof. Mariani per l’interesse, ma si tratta di semplici considerazioni a partire dai metodi di stima sulla sensibilità climatica. Tra l’altro mi piacerebbe approfondire il discorso su quando uno stimatore è affidabile, parlando di varianza, e soprattutto convergenza (se non ricordo male in statistica la chiamano consistenza), cosa ben diversa dal verificare che due o più lavori siano compatibili tra loro.

Grazie per l’indicazione del link al suo articolo, che ho trovato interessante e ricco di spunti.

I proposito mi permetto alcune considerazioni che faccio in quanto sviluppatore di modelli che assi modestamente si occupano di piccole porzioni del sistema climatico (il bilancio energetico di una risaia, la produttività di un campo coltivato, la temperatura di un acino d’uva, ecc.).

Anzitutto constato che per tutti noi i GCM sono delle scatole nere in quanto non possiamo lavorare su di loro “in corpore vili” (per dirla con Totò). In realtà il modo giusto sarebbe quello di poterli far operare dal vero, il che oggi è appannaggio solo di pochi gruppi di ricerca dotati di risorse umane e di calcolo adeguate. A questi stessi gruppi è ovviamente facile rispondere ai critici con la vecchia e giusta battuta secondo cui “chi è in mare naviga, chi è a terra critica”. Questa battuta non si può tuttavia applicare allo scritto di Anagnostopoulos et al. i quali procedono a una confutazione su base empirica.

Debbo poi dire che personalmente trovo molto utile l’uso dei GCM in sede di analisi, e cioè per capire perchè il clima si comporta un un modo anzichè in un altro. Ci sono articoli in tal senso che escono su riviste scientifiche e che trovo avvincenti.

D’altra parte avverto una notevole dose di fastidio quando per conto di riviste scientifiche mi trovo a referare lavori in cui ad esempio:

– si prende l’output previsionale di un GCM e lo si riporta in qualche modo – spesso con voli pindarici in termini di scala – al territorio in esame (è il cosiddetto “downscaling”)

– si usano i dati così ottenuti per applicarvi modelli biologici che prevedono, che so, che nel 2100 avremo l’ananas e i banani in Valtellina.

A fronte di una tale procedura che dire? Siamo ancora in ambito scientifico o stiamo facendo sterili esercizi”?

In proposito Roger Pielke sr (http://pielkeclimatesci.wordpress.com/) non ha dubbi quando scrive: “Research funding by the NSF and others which provide predictions of climate impacts decades from now, but present no way to test the skill of these forecasts is a waste of funding. Even more importantly, it misleads policymakers in terms of the spectrum of risks we will face from climate, but also other social and environmental threats, in the coming decades, as we discussed in”.

P.S: La considerazione di Tibaldi è proprio il motivo del mio scetticismo. A fronte di un orizzonte temporale così lungo, da dove diamine si possono tirar fuori i dataset necessari a testare i nuovi modelli? finalmente ho avuto la risposta: non ci sono…

Mi associo anch’io volentieri ad i complimenti per l’articolo, anche perchè conosco bene il gruppo di idrologi dell’Università di Atene tanto da apprezzarne l’elevata preparazione e professionalità.

Il mio contributo è teso a cercare di arricchire questo interessante dibattito con alcuni riferimenti:

1) risposta da parte dello stesso IPCC alle domande relative all’affidabilità dei modelli previsionali di cambiamento climatico (http://www.ipcc.ch/publications_and_data/ar4/wg1/en/faq-8-1.html);

2) questione che, a mio modo di vedere, è alla base ed è fonte del problema: la stazionarietà è morta (http://www.azwaterinstitute.org/media/CCADAPT/milly_et_al.pdf) o è viva (http://itia.ntua.gr/en/docinfo/511/)??

…ai posteri l’ardua sentenza.

Gentile Federico Lombardi,

grazie anzitutto per avere richiamato quella che in estrema sintesi riassume la posizione Ipcc (è un ottimo bigino, assai più maneggevole del capitolo 8 dell’AR4). Nel bigino prego osservare il grafico ivi riportato, pienamente in linea con quanto lamentato da Anagnostopulos et al. (vi si presentano gli scostamenti dalla media anziché i valori…).

Circa poi la stazionarietà, ci sono moltissimi lavori sull’argomento (ricordo ad esempio il molto istruttivo scritto di Carl Wunsh dedicato alla variabilità degli annular modes NAO e SAM e uscito sul Bams nel 1999 – http://puddle.mit.edu/~cwunsch/papersonline/bamsrednoise.pdf).

Aggiungo alcune considerazioni sull’articolo redazionale di Science da lei segnalato, oltremodo riduttivo e perfino surreale:

1. vi si respira una retorica da “clima impazzito” che pensavo fosse un brevetto del politologo Sartori.

2. si esprime fiducia quasi cieca nei GCM (unico segnale di realismo è nella frase per cui “in a non stationary world, continuity of observations is critical”).

Inoltre vi si propose la strana tesi secondo cui gli idrologi nelle loro progettazioni di opere destinate a durare (dighe, argini, ecc.) facessero fino a pochi anni fa affidamento su un clima stazionario.

In proposito mi limito a ricordare:

– la dust bowl (la peggior siccità che gli Usa hanno subito nel 20° secolo) è degli anni 30

– le tante analisi sui tempi di ritorno che ho visto fare dagli idrologi in passato e che non credo fossero passatempi ameni.

Luigi Mariani

Dimenticavo, complimenti a Luigi Mariani per averci proposto questo lavoro.

Se quello scritto fosse vero, calcolabile e riproducibile su scala planetaria sarebbe una mazzata tremenda, se non decisiva, alle metodologie di lavoro(?) e previsioni e dell’IPCC.

Bellissimo articolo che mette in luce le debolezze dei CGM e soprattutto il fatto, come indicato al punto 1 che essi non considerino dati grezzi ma modificati, in particolare trattati per ottenere anomalie oppure come avevo citato in un mio commento di qualche tempo fa “anomalie o variazioni della velocità dei cambiamenti”, misurazione del “centro di gravità” delle anomalie(?!) ecc.

Si tratta di questioni basilri che riguardano le metodologie di calcolo, il tipo di dati utilizzati e il modo in cui questi dati sono manipolati. Un vero dibattito scientifico dovrebbe vertere innanzitutto su questi elementi ancor prima di proporre dei risultati invece purtroppo la realtà è che tutta questa parte a monte viene data come assodata e inconfutabile. é come se in un equazione tutto quello che sta prima dell = (cioè che sta alla base del risultato, che è la causa del risultato) NON FOSSE discutibile. E QUESTO FA PARTE PROPRIO DI QUEL METODO scientifico tanto in voga ai giorni nostri in cui si basa la ricerca non su osservazioni ed sintesi di dati ma sulla raccolta asettica e indiscriminata di numeri utili solo per nutrire programmi di calcolo sempre più complessi e sempre meno verificabili che sputano risultati o meglio sentenze sulle sorti dell’umanità. IL tutto senza un minimo di verifica della correttezza del modello, del calcolo e del dato grezzo di partenza. Questo approccio “scinetifico” ha un’altra importante conseguenza, che data l’asetticità dello studio ( si calcolano e proceesano numeri, poco improta se questi numeri si riferiscano a persone, cose, gas, metalli, feriti, malati, ladri, spazzatura, ecc.) risulta motl semplice far variare i risultati “a piacimento” variando alcune variabili delle complesse equazioni e modelli di calcolo. IL metodo scientifico attulae, quello applicato principalmente alla ricerca di denaro impone che prima si formulino delle conclusioni, dei modelli, dei risultati ( possibilmente in accordo con le tesi o gli argomenti di chi eroga il denaro) e poi si trova un complesso modello statistico matematico che “scintificamente e matematicamente” mi dia il risultato che mi sono prefissato. E questo l’ho vissuto personalmente.

In merito alle sue considerazioni mi è rimasta indelebilmente impressa la “storica” frase pronunciata dal sottosegretario all’agricoltura del governo Prodi ad un convegno internazionale sul riso, cui ebbi la ventura di partecipare in quanto mi occupo da tempo di meteorologia applicata a quella coltura.

La frase recitava più o meno così: “a noi politici è ormai del tutto chiara la responsabilità determinante dell’uomo nel Global Warming. Quello che vogliamo dalla scienza è di aiutarci con altri dati che confermino le nostre convinzioni”.

Frasi di questo tipo la dicono lunga sullo spazio lasciato ai ricercatori ….

Ciò non toglie tuttavia che in campo scientifico il diritto/dovere all’approccio critico e senza verità precostituite sia un bene da tutelare e da trasmettere alle nuove generazioni (mi verrebbe da dire che è “patrimonio dell’umanità” ma non lo dico perché nutro una profonda idriosincrasia per questo concetto….).

Da questo punto di vista mi pare che il lavoro dei colleghi di Atene sia esemplare.