Ognuno di noi si è misurato l’altezza e conosce un centimetro da sarto. Ipotizziamo che una classe di 30 persone sia stata misurata per calcolare l’altezza media, dopo alcuni anni la stessa è nuovamente misurata e una volta calcolata la nuova media dal confronto di questa con la precedente si scopre che la classe è cresciuta di un 2 millimetri. La domanda sorge spontanea: come è stato possibile con quello strumento arrivare ad un risultato che ha una “precisione” maggiore della sua sensibilità? Con quale criterio sono state scelte le cifre significative del valor medio e stimato il suo errore? Domande corrette che lo scienziato si è sempre posto da quando l’uomo ha inventato gli strumenti, innovando il modo di confrontarsi con la realtà , evento descritto molto bene da Alexandre Koyre nel suo testo “Dal mondo del pressappoco all’universo della precisione”.

In campo meteorologico da giorni è stata diffuso il dato della temperatura media globale di marzo 2010:

“Marzo 2010 è stato complessivamente a livello globale il marzo piu’ caldo mai registrato a partire dal 1880 con una anomalia di 0,77 gradi centigradi al si sopra della media secolare per i mesi di marzo del 20mo secolo. Lo si apprende dall’ultimo bollettino del Noaa, l’ente statunitense per il controllo sugli oceani e l’atmosfera. Il precedente mese di marzo record si era verificato nel 2002. Al raggiungimento di questo record -precisa il Noaa- ha contribuito di piu’ l’emisfero sud che quello nord. Scomponendo i dati tra oceani e continenti, si nota che la temperatura media superficiale degli oceani ha raggiunto nel marzo 2010 un valore record: il valore piu’ alto mai registrato a partire dal 1880. Il precedente record, per il mese di marzo, si era verificato nel marzo 1998.”1

Dal bollettino NOAA leggiamo che il valore nel 2002 era stato 0.74°C, la temperatura media superficiale degli oceani record raggiunta nel marzo 2010 è stata 0.56°C, il precedente record del 1998 era 0.55°C, ben 0.01°C di differenza2.

In notazione scientifica dovrei sempre far seguire il valore dall’errore, posso trascuralo se e solo se mi limito a riportare solo le cifre che non ne sono affette. Scrivere 0.56°C lascia intendere che l’errore è sui millesimi, anche perché altrimenti non capirei come possono averlo distinto da 0.55°C del 2002. Accettiamo temporaneamente l’ipotesi che la temperatura globale superficiale sia rappresentativa dello stato del sistema climatico, che gli strumenti dal 1850 ad oggi siano stati tenuti in stato perfetto e in un sito rappresentativo, che il cambiamento di tecnologia durante i decenni non abbia avuto effetti sulla serie, che i vari tipi di strumenti di misura siano comparabili, che la temperatura media sia sempre stata stimata con le stesse modalità in ogni epoca, che la rete sia sempre stata la stessa, che l’accuratezza nella misura sia stata sempre uguale all’attuale e i tempi di risposta degli strumenti immutati.

Ma con quale accuratezza è misurata la temperatura dell’aria? Occorre tener conto che la misura è molto differente da quanto avviene in laboratorio, infatti occorre eliminare gli effetti della radiazione e tener conto del modificarsi continuo del suo valore. Proprio per evitare tali effetti, nel tempo le modalità di misura sono cambiate: all’inizio il termometro veniva esposto temporaneamente a Nord e Sud della stazione e poi la stima del valor vero era calcolata come media, successivamente venne esposto solo sulla parte Nord (tanto che ancor oggi qualcuno continua a far seguire alla temperatura misurata la descrizione “all’ombra”), poi il termometro fu inserito nella capannina (spesso in legno del tipo Stevenson) e più recentemente tale capannina è stata sostituita da shield spesso in materiale plastico. Tali passaggi naturalmente sono avvenuti con diversa gradualità nelle varie parti del Mondo.

Sotto riporto quanto scritto dal Prof.Giorgio CANTONI (1878-Memorie e notizie Ufficio Centrale di Meteorologia) quando s’inizio a pensare d’introdurre in Italia la capannina meteo:

”Da tempo si ammette che il modo più opportuno per conoscere la temperatura propria dell’aria atmosferica sia quello di far ruotare con molta rapidità , a guisa di fionda, il termometro trattenuto da una funicella, per osservarlo poi, fermato di repente: e ciò per sottrarre il termometro stesso alla influenza della radiazione dei corpi circostanti colpiti dal sole. Però questa pratica essendo incomoda e pericolosa, non potè essere adottata per le normali osservazioni teoriche: e si pensò sottrarre con altri modi i termometri da questa influenza della irradiazione. Nel più dei casi li si espongono all’infuori di una finestra, praticata in una parete rivolta giustamente a nord, talché mai non sia direttamente colpita dal sole. Ma appunto perciò codesta parete durante il giorno, avendo una propria temperatura inferiore a quella dell’aria, farà ufficio di refrigerante; mentre poi, nella notte, la parete stessa, avendo una temperatura superiore a quella dell’aria, farà opera di calorifero rispetto al termometro, il quale non potrà essere spinto molto all’infuori della finestra, affinché non sia colpito dal sole durante il giorno”.

A seconda del posto, dell’epoca, delle necessità dell’osservatore e della rete, durante le 24 ore venivano effettuati un certo numero di campionamenti, generalmente a seconda del posto e dell’epoca si va da alba-tramonto fino alla cadenza oraria (se inviati con messaggi meteo) o all’ordine dei secondi se elaborato sul posto. Con questi dati poi è calcolata la temperatura media.

All’epoca di Galileo colui che calcolava la media conosceva bene anche lo strumento utilizzato, quindi i suoi limiti. Era naturale scegliere le cifre significative e fare i conti tenendo sempre presente come erano state effettuate le misure. Se ho utilizzato il centimetro del sarto come cifre significative non posso arrivare ai millimetri, anche se il campione su cui calcolo la media è numeroso. Se desidero essere più accurato debbo cambiare strumento.

Oggi spesso chi elabora i dati nulla conosce dello strumento di misura che li ha prodotti, quelli per lui sono solo numeri che riceve da varie parti del mondo codificati in un messaggio in cui quasi sempre nessuna informazione è riportata su come sono stati prodotti. Specie da quando ci sono i calcolatori i valori letti dai sensori vengono sempre presentati sul video con errori che possono apparire solo di decimi o centesimi o millesimi, spesso si può anche scegliere fino a che cifra visualizzare. Attenzione che quello però è una falsa stima dell’errore detta “risoluzione” (è uno dei valori che il venditore fornisce dello strumento), l’accuratezza che si basa sulle caratteristiche fisiche dell’intero sistema di misura è altra cosa.

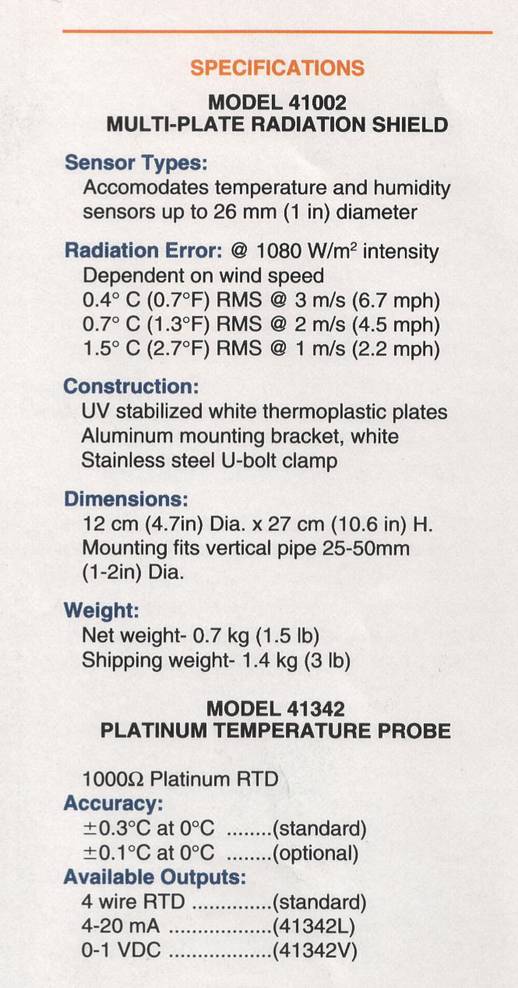

Lo strumento per misurare la temperatura atmosferica è formato da sistema acquisizione, sensore termometrico e schermo. Il sensore attualmente più diffuso è il PT100 (su internet potete trovare tutte le caratteristiche) che ha un errore tipico di 0.3°C (questo quando lo strumento è calibrato periodicamente), ma può raggiungere lo 0.1°C (per scopi meteorologici quasi nessuno chiede questa sensibilità ). Questo sarebbe l’errore per misure statiche ed al chiuso, per la temperatura atmosferica occorre tener conto dell’errore dello shield/screen che è funzione dell’intensità della radiazione e del vento (con il trascorrere del tempo ad esempio anche di come varia la sua colorazione).

Lo strumento per misurare la temperatura atmosferica è formato da sistema acquisizione, sensore termometrico e schermo. Il sensore attualmente più diffuso è il PT100 (su internet potete trovare tutte le caratteristiche) che ha un errore tipico di 0.3°C (questo quando lo strumento è calibrato periodicamente), ma può raggiungere lo 0.1°C (per scopi meteorologici quasi nessuno chiede questa sensibilità ). Questo sarebbe l’errore per misure statiche ed al chiuso, per la temperatura atmosferica occorre tener conto dell’errore dello shield/screen che è funzione dell’intensità della radiazione e del vento (con il trascorrere del tempo ad esempio anche di come varia la sua colorazione).

Per gli strumenti a mercurio è facile farlo guardando la scala graduata, potete notarlo a casa su un semplice termometro che avete a casa per misurare la febbre o la temperatura “locale” (anche se questa tipologia di strumenti sta andando in disuso). Per dare un esempio allego l’errore riportato su una specifica di uno strumento americano abbastanza diffuso, vi invito a cercarlo per altri.

Componendo i vari tipi di errore, uno strumento per la temperatura atmosferica, sofisticato ed evoluto, quando lavora in campo ha una accuratezza che varia tra 0.7°C e 1.8°C (quando lo strumento è in perfette condizioni). Quella effettuata con il sensore è una misura diretta, quella indiretta effettuata da satellite certamente comporta errori maggiori.

Avendo anche un campione formato da miliardi di misure effettuate con questa strumentazione (o simile dal punto di vista dell’errore), posso calcolare la media ed il suo errore statistico, ma il teorema del limite centrale non permette a tali valori di scendere sotto quella che è l’accuratezza strumentale (che è poi quella che mi deve guidare nella scelta delle cifre significative). L’errore statistico deve essere necessariamente maggiore o uguale a quello strumentale. Se arrivo nella misura dell’altezza delle persone all’accuratezza del micron non è determinante quante misure ho effettuato, ma quale strumento ho usato.

Quando calcolo una media, o faccio girare un modello, il risultato matematico può essere presentato con tante cifre significative quante ne sono disponibili sul visore; l’accuratezza con cui conosco la realtà, su cui ho basato i miei calcoli, sarà quella a limitare anche i risultati. Altrimenti sto creando informazione.

A questo punto viene spontaneo domandarsi come fa la NOAA (e gli altri centri di calcolo) ad arrivare ad errori del millesimo di grado (come visto sopra), quando già i messaggi meteorologici prevedono il decimo? Come fanno i proxi-data delle volte a fornire valori più accurati delle misure strumentali dirette? Francamente non ho risposta, spero nei vostri commenti.

L’incertezza sulla misura non significa che il mondo non si sta riscaldando, anzi la situazione potrebbe essere anche peggiore dal punto di vista della temperatura media globale. Però, se la Polizia stradale mi sanzionasse per eccesso di velocità sarebbe differente che ciò avvenisse in seguito ad una misura dell’autovelox che abbia dato come risultato una velocità di 150 Km/h oppure 150Km/h con un errore di oltre il 100%.

Il compito principale della scienza non è dire se il bicchiere è mezzo pieno o mezzo vuoto, ma cominciare a dire se è mezzo e soprattutto con quale errore.

===============================

QUALCHE BRVE MA UTILE DEFINIZIONE PER APPROFONDIRE

“Although this guide provides a framework for assessing uncertainity, it cannot substitute for critical thinking, intellectual honesty, and professional skill. The evaluation of uncertainity is neither a routine task nor a purely mathematical one; it depends on detailed knowledge of the nature of the measurand and of the measurement. The quality and the utility of the uncertainty quoted for the result of the measurement therefore ultimately depend on the understandig, critical analysis, and integrity of those who contribute to the assignement of its value.” “Guide to the expression of uncertainity in measurement” International Organization for Standardization 1993″

For CLIMATE studies in particular, temperature measurements are affected by the state of the surrounding, by vegetation, by presence of buildings and other objects, by ground cover, by condition and changes in design of the radiation shield or screen, and by other changes in equipment. Temperature is one of the meteorological quantities whose measurement are particularly sensitive to exposure. (Guide 8 WMO-1996)

ACCURACY= the closeness of the agreement between the result of measurement and the true value of the measurand.

RESOLUTION=a quantitative expression of the ability of an indicating device to distinguish meaninfully between closely adjacent values of the quantity indicated, for display presentation tenth, hundredth,…

[…] effettuate presso quelle stazioni siano senza errore e tutte di qualità (ne abbiamo discusso qui e qui), senza problemi di cambiamento nel tempo,etc. Ma quante e dove sono le […]

[…] gli scostamenti finisce per essere ancora più approssimativo. Il tutto, come l’amico Fabio Spina ci ha fatto recentemente notare su queste pagine, spingendo la precisione dei dati molto oltre la capacità strumentale e […]

Credo che nell’ormai classico dei classici fra gli articoli sull’argomento si possano trovare, molti spunti per un’infitità di pensieri e di dubbi, sopratutto se soppesiamo le parole dell’articolo.

http://www.cru.uea.ac.uk/cru/data/temperature/HadCRUT3_accepted.pdf

Ti ringrazio per l’articolo del famoso, per alcuni famigerato, Jones, lo leggerò con la dovuta calma e ti farò sapere. Da una scorsa veloce però all’inizio pag.6 trovo proprio l’errore strumentale citato in un post sopra da Filippo Turturici (che è poi l’errore sul sensore, come detto nel mio post l’errore sull’intero sistema di misura è ben più alto) e poi applica a 60 risultati di misura il teorema del limite centrale non alla varianza calcolata sui risultati delle misure ma all’errore dello strumento. Boh!? Grazie e Buona domenica

Guarda, hai centrato al volo uno dei punti cardine, li si giocano tante carte per l’abbattimento matematico dell’errore rispetto a quello strumentale (un’altro grosso e fastidioso punto è la ponderazione terra mare…ma non solo). In linea di principio tale operazione usando l’errore dello strumeto è presente ad esempio in testi classici degli anni 40, ma gli stessi testi portano due obiezioni, la prima è che la divisione per la radice di n (numero di misure) è lecita solo se n(al quadrato)è praticamente uguale a n x(n-1) il che per sole 60 misure non è proprio vero, ma in questo modo diminuiscono un po di più l’errore di quello che dovrebbe essere lecito (l’equazione da usare è un pò diversa). Ma la cosa più importante che i testi dicono è che tale procedura è consentita solo se le misure vengono fatte nelle stesse identiche condizioni, è questo punto è totalmente disatteso, le condizioni meteorologiche non sono affatto uguali e paragonabili, è l’utilizzo di tale equazione per quanto semplice e classica non è consentito….tuttavia a fare i puritani della misura non si va avanti perchè allora sarebbe praticamente impossibile costruire un concetto di media spaziale e temporale dal punto di vista della teoria degli errori…ma vabbe son discorsi lunghi, molto lunghi.

Buona domenica anche a te

Infatti: nelle misure meteorologiche manca completamente la “ripetibilità “, dato che non siamo né in laboratorio né in presenza di fenomeni controllati o periodici (spero di non sbagliare la definizione).

Ogni luogo ed ogni istante sono un fenomeno a parte che non può essere ripetuto; inoltre, tutte le sonde termometriche in giro per il Globo, non stanno certamente misurando lo stesso fenomeno, ma appunto fenomeni diversi: ci vorrebbero X>>1 sonde per ogni punto (diciamo ogni area ->0, un minimo di spazio tra i termometri sarà indipensabile) che rilevino contemporaneamente i dati in ogni istante, perché si possa fare una cosa del genere.

Insomma, mancano completamente le condizioni per effettuare correzioni simili, anche solo per approssimazione.

Ma anche avendo tutti i termometri che ci piacerebbero, la cosa da questo punto di vista non cambierebbe, visto che poi a rigore serebbe impossibile conglobare i dati per costruire una media, perche essendo tali dati “cose” diverse una dall’altra non sarebbe rigoroso unirli…e qui siamo al concetto generale di misura, come ho detto se facciamo troppo i puritani non possiamo a rigore misurare proprio nulla; la via del pragmatismo ci dive invece che dobbiamo misurare, semmai poi non dobbiamo cambiare i destini del genere umano per cose cosi poco rigorose come la temperatura media terrestre.

Quello che dite Te e Filippo sono uuna cosa giusta ma è un altro tema fondamentale da discutere in quanto questo come dicevo è un processo stocastico ed il valore vero cambia in funzione del tempo (non come se ripetessi la misura in laboratorio).

Il primo livello a cui mi pongo è che quando ho n misure su queste posso calcolare la dispersione (sigma) ed applicare tutti i teoremi statistici che voglio (se applicabili), ma non posso arrivare ad un errore statistico minore di quello strumentale con cui conosco la realtà . La sigma la calcolo solo nel caso la differenza tra misure è maggiore dell’errore strumentale, se faccio 100 volte la stessa misura otterrò come media il valore della misura e l’errore strumentale, non quest’ultimo diviso radice 100 (questo è sicuro da decenni anche se Jones scrive cose diverse)

A presto

Non è che perché non è possibile arrivare a ciò che vogliamo allora si trova un modo matematico per farlo. La rete osservativa meteorologica nasce per tutti altri scopi di misurare la temperatura al centesimo di grado (all’epoca con il mercurio era proprio impossibile farlo), non ha neanche senso spingersi a tali valori perché ad esempio spostandoti di poco il termometro dentro la capannina stevenson hai differenze di 0.7°C. La rete nasce per scopi sinottici, per la tale scopo andavano bene frequenza di campionamento dei messaggi synop e accuratezza del sistema. Oggi se vogliamo utilizzare quei dati è indispensabile tener conto correttamente del modo con cui sono stati prodotti ed i limiti. E’ un discorso lungo ma che non si può saltare, specie se scelte epocali vengono effettuate su questi dati.

Ciao

Ho trovato anche http://www.geog.ox.ac.uk/~mnew/teaching/Online_Articles/folland_et_al_temp_uncertainties_GRL_2001.PDF , lollegrò con attenzione ma al momento mi sembra afflitto dallo stesso problema, tanta matematica-statistica e niente fisica dello strumento.

Buona domenica

Gentile sig. Fabio e gentile sig. Pietro (anche se lei non usa toni per nulla gentili, e dà pareri forse poco meditati), riprendiamo il discorso….grazie sig. Fabio per le ulteriori spiegazioni del suo pensiero, vedrò di chiarire ulteriormente anche il mio, usando i concetti che lei esprime.

Per evitare discussioni infinite farò un commento lungo, me ne scuso in anticipo.

Ora forse mi è chiaro il perché dei suoi dubbi (dico forse, se sbaglio mi corregga pure), mi pare lei consideri il calcolo della temperatura media terrestre come una misura diretta della grandezza “Temperaturaâ€, in realtà la temperatura media terrestre è una misura indiretta, e la differenza tra i due concetti è sostanziale e poi vedremo il perché.

Partiamo dalle origini, il concetto di misura altro non è che il concetto di confronto tra la grandezza che si vuol misurare con una grandezza arbitraria di riferimento. In base alla teoria classica si ritiene debba esistere la grandezza Vera che noi vogliamo misurare, ma nel misurare noi compiamo degli errori, cosi per stabilire con migliore accuratezza il valore della grandezza in esame noi eseguiamo diverse misure nelle Stesse Identiche Condizioni. La teoria degli errori ci insegna che la nostra stima della grandezza vera mediante le misure dipende da 2 fattori: Dalla bontà del nostro strumento e dal numero di misure. Il nostro errore nel conoscere il valore della grandezza vera decresce all’aumentare del numero di misure o meglio se le misure sono tante, decresce all’aumentare della radice quadrata del numero di misure. Questa è la teoria base per una misura diretta, fatta nelle stesse identiche condizioni. In questo caso la media delle misure che ne viene fuori ha un significato fisico, è l’errore (composto nel modo previsto dalla teoria) indica l’incertezza nella conoscenza della grandezza in esame. In questo caso la nostra conoscenza della grandezza, ovvero l’errore totale nella misura non dipende solo dal nostro strumento ma anche dal numero di misure, detto in altri termini l’informazione aggiuntiva che migliora la nostra stima non deriva dallo strumento, ma dal numero di misure, in pratica è una proprietà emergente, non attribuibile allo strumento, anche se matematicamente collegata ad esso.

Purtroppo in natura non ci sono quasi mai le condizioni per poter effettuare una serie di misure dirette propriamente dette, o per il cambiare delle condizioni al contorno o per impossibilità pratica di poter misurare direttamente una grandezza, o per l’unione delle 2 condizioni insieme, e questo purtroppo è il nostro caso.

In tutti i casi in cui non è possibile fare una misura (o una serie di misure) diretta si procede per una misura indiretta.

In una misura indiretta la grandezza che si vuole esaminare si ricava matematicamente tramite un’equazione in cui entrano altre grandezze che è possibili misurare direttamente, oppure tramite una serie ben precisa di passaggi matematici (algoritmo).

L’errore nella grandezza misurata indirettamente è funzione sia degli errori delle misure delle grandezze dirette, sia del modo in cui esse si compongono all’interno della funzione matematica che determina la grandezza finale. Il punto chiave per i nostri discorsi sta proprio qui, in base al tipo di funzione matematica, gli errori attribuibili agli strumenti che effettuano le misure dirette, possono compensarsi più o meno reciprocamente.

Pensando alla temperatura media terrestre quindi, dobbiamo dire che l’errore totale sbandierato orgogliosamente dagli enti preposti è determinato mediante la composizione degli errori dei diversi strumenti usati per effettuare le misure in terra ed in mare, e soprattutto è determinato dall’algoritmo utilizzato per generare il valore medio della temperatura terrestre, per questo motivo è possibilissimo avere un errore finale minore dell’errore dei singoli termometri, e sempre per questo motivo non condivido l’entusiasmo di questi giorni per la standardizzazione delle misure, intanto per avere garanzia della bontà della media è molto importante l’algoritmo non lo strumento, quindi si dovrebbe ad esempio bussare alla porta di mister J. al CRU per chiedere semmai chiarimenti su di esso. Ricordiamoci che la temperatura che viene fuori da quell’algoritmo non è una grandezza fisica reale, ma fittizia.

Un’ultima cosa, le cifre decimali aggiuntive rispetto a quelle rilevate dai termometri derivano anch’èsse dai passaggi matematici, ma è corretto tenerle perché racchiudono informazione e perché sono entità matematiche (se fossero entità fisiche sarebbe tutto una altro paio di maniche).

In estrema sintesi, sia le cifre decimali della temperatura media sia l’errore ad esso associato derivano dal tipo di algoritmo matematico usato, e sono solo lontanamente vincolate alle caratteristiche degli strumenti che misurano la temperatura….è brutto ma purtroppo è cosi, e come linea di principio è pure corretto, quel che puzza sono gli algoritmi ed i “pesi†che stanno dentro quelle equazioni.

Spero ora di aver chiarito il mio pensiero ancor meglio.

Cordiali saluti

Caro Tore,

il Tuo pensiero, come detto da Teo nel suo secondo post su http://www.climatemonitor.it/?p=9540 , è quello portante di molti climatologi famosi ma non per questo corretto dal punto di vista scientifico. Potrebbe essere un auspicio ma mai un’affermazione dimostrata scientificamente su cui fondare le proprie decisioni. Riprendo quanto afferma per discuterlo insieme:

1) La teoria degli errori ci insegna che la nostra stima della grandezza vera mediante le misure dipende da 2 fattori: Dalla bontà del nostro strumento e dal numero di misure. Con la postilla che l’errore calcolato eventualmente con il teorema del limite centrale http://it.wikipedia.org/wiki/Teoremi_centrali_del_limite (pur avendo radice di n al denominatore) non potrà mai essere inferiore all’errore della singola misura che è quello che determina, sulla base della propagazione dell’errore l’accuratezza con cui conosce la media ed anche la deviazione standard. Se Lei misura un tavolo con il centimetro del sarto per 50 volte non potrà mai scendere sotto l’accuratezza con cui conosce la singola misura, altrimenti non avrebbe senso spendere per comprare strumentazione “precisaâ€. La bontà dello strumento è un parametro chi cui deve, non dovrebbe, tener conto in tutti i conti successivi. Quello di cui stiamo parlando è l’errore sulla misura non la deviazione standard calcolata con una serie di queste, il teorema del limite centrale fa affermazioni solo su quest’ultima grandezza. Posso fare 60 misure di temperatura giornaliere e calcolare di queste la media e standard deviation (sarà dell’ordine dei gradi). Con il teorema del limite centrale posso dare stima della standard deviation della media (che sarà sicuramente inferiore di quella delle misure), ma questa non potrà mai scendere sotto all’errore strumentale.

2) gli errori attribuibili agli strumenti che effettuano le misure dirette, possono compensarsi più o meno reciprocamente. Questa affermazione non è dimostrata scientificamente, posso anche ipotizzare che si sommino. Solo ipotesi. La propagazione degli errore mi dice ad esempio che se sommo o sottraggo due grandezze gli errori debbo sempre sommarli.

3) per questo motivo è possibilissimo avere un errore finale minore dell’errore dei singoli termometri,E’ impossibile tale evento, nessun nesso con la fisica del problema. Se fosse così potrei aumentare frequenza campionamenti ed acquistare strumenti meno costosi ottenendo la stessa “precisioneâ€, invece otterrei solo risultati meno precisi e vedrei frequenze più alte del segnale (che portano a misurare un mondo che prima non vedevo).

4) e sempre per questo motivo non condivido l’entusiasmo di questi giorni per la standardizzazione delle misure, intanto per avere garanzia della bontà della media è molto importante l’algoritmo non lo strumento,Non condivido nulla di questa parte, la qualità è un grande passo avanti senza il quale calcolare le medie non ha senso fisico, solo matematica.

5) quel che puzza sono gli algoritmi ed i “pesi†che stanno dentro quelle equazioni.D’accordo, aggiungerei un anche. ïŠ

Fammi sapere quello che pensi, ma in un campione non confondere l’errore strumentale con la dispersione tra i valori ottenuti nelle misure.

Saluti

Mi permetto di commentare che, a mio umile parere, l’affascinante libriccino del russo Koyré aiuta forse a capire meglio perché ci abbiamo messo ben quasi mezzo millennio a realizzare una idea già ben definita ed attraente come la macchina volante di Leonardo da Vinci, ma non aiuta a capire come misurare meglio la temperatura media del pianeta — piuttosto, mi sembra ma forse sbaglio, Koyré implicitamente tendeva anche a scoraggiare il tentativo di capire meglio la natura solo attraverso misure sempre più raffinate.

Inoltre, ricordo ancora il manuale di un navigatore Omega/VLF, che mi ero studiato vent’anni fa per misurare il vento a bordo di un aereo: spiegava come il segnale utile era ricevuto qualche dB al di sotto (!) del rumore di fondo, ed estratto con tecniche statistiche; il valore risultante aveva ovviamente un numero di cifre significative ben superiore a quello di ogni singola misura, e alla fine — e prima del GPS — riuscivo a sapere dov’ero e a calcolare il vento in volo con un paio di nodi di precisione. Nei dati “imprecisi” l’informazione spesso c’è, ma va spremuta statisticamente (Galileo non poteva…) — e, inoltre, non birichinamente, McIntyre docet.

Confesso inoltre che, pur rileggendola più volte, non ho capito una frase (estratta qui sotto, ma che va letta nel contesto!) che mi pare cruciale per l’articolo, peraltro molto interessante:

“Dal bollettino NOAA leggiamo che il valore nel 2002 era stato 0.74°C, la temperatura media superficiale degli oceani record raggiunta nel marzo 2010 è stata 0.56°C, il precedente record del 1998 era 0.55°C, ben 0.01°C di differenza.”

Cordialmente,

AOB

Grazie dell’intervento a cui cercherò di rispondere brevemente:

– Koyré nel suo scritto dice tante cose, sicuramente anche che i dati non altro che numeri se non c’è dietro un’interpretazione umana. Io lo tiro in ballo solo per dire che, pur se siamo in un epoca in cui sembra tutto facile e la tecnologia ormai misura tutto esattamente, la realtà è un’altra. Altrimenti si rischia di vivere un’illusione, che riprendo nel titolo;

– Nei dati imprecisi l’informazione c’è e si può estrarre statisticamente dal ruomere, come si fa per una stella, un aereo sul tracciato radar, un suono, etc. L’unico problema è che è possibile farlo solo quando si sa cosa si cerca, ed in climatologia non dovrebbe essere così;

– C’è un’attenzione mediatico/politico enorme ai mesi più caldi. La differenza tra il primo e secondo classificati, marzo 2010 e 1998 e 0.01°C (un centesimo di grado) per la temperatura oceani e 0.03°C a livello del dato globale. Mi piacerebbe conoscere l’errore su questi valori, visto che poi su alcuni siti li trovo riportati fino al millesimo di grado.

Saluti

Fabio S

Sperando che la mia insistenza venga solo considerata come uno speciale apprezzamento per un articolo interessante, confesso che ancora non riesco a capire la frase che ritrascrivo:

“Dal bollettino NOAA leggiamo che il valore nel 2002 era stato 0.74°C, la temperatura media superficiale degli oceani record raggiunta nel marzo 2010 è stata 0.56°C, il precedente record del 1998 era 0.55°C, ben 0.01°C di differenza.â€

e specialmente l’inciso:

“…la temperatura media superficiale degli oceani record raggiunta nel marzo 2010 è stata 0.56°C,…”

Considerando che l’acqua di mare gela attorno ai -1.8°C, devo intendere che il record della temperatura media degli oceani è stato di circa un paio di gradi al disopra della temperatura di congelamento?

Ringrazio fin d’ora per il chiarimento!

Cordialmente, AOB

Scusa non avevo capito il tuo dubbio. Solitamente quando si parla di temperatura globale si fa riferimento non al valore assoluto ma alla differenza con la media di un trentennio (es. 1970-2000) detta generalmente anomalia. Quindi quei valori sono le anomalie di quei mesi, cioé la differenza con la media calcolata su un trentennio e differiscono tra loro di un solo centesimo.

Spero si aver capito e di essere riuscito a spiegarmi.

Ciao

Tutto chiaro, molte grazie!

AOB

Forse può essere utile leggere l’articolo http://www.corriere.it/scienze_e_tecnologie/energia_e_ambiente/10_aprile_23/marzo-caldo-sempre_cfc0cf12-4ec7-11df-83f9-00144f02aabe.shtml

Ciao

L’analogia tra misure topografiche e misure di temperaturea è inopportuna. Le misure topografiche infatti sono in genere ridondanti, la precisione dipende non solo dall’errore strumentale, ma anche dalla quantità di misure e dalla conseguente compensazione. Le misure di temperatura invece sono singole e puntuali, partendo da un presupposto di bontà delle procedure applicate, l’errore non può essere che quello strumentale.

Inoltre mi sembra grave affermare che solo le grandezze fisiche misurate direttamente sono affette da errore e che le grandezze derivate, solo perché astratte, non ne sono affette. Ora si potrebbe rispondere a questa baggianata con esempi paradossali o tentando di spigare in termini intuitivi la teoria di propagazione dell’errore, ma si tratta di banalità che si possono leggere in un qualsiasi testo di fisica di prima superiore. Semplicemente chi non ha una formazione scientifica basilare dovrebbe astenersi dal fare simili affermazioni.

Concordo in tutto quelo che dici, in una forma sintetica che può apparire poco cortese. Chi non ha formazione scientifica è giustificato quando afferma cose imprecise, il problema è quando eminenti scienziati danno per scontato cose che non lo sono. Credo che sia un effetto del sopravvento della modellistica con l’allontanamento dallo strumento di misure. Puurtroppo queste erano banalità , sempre più spesso non si leggono neanche sui testi più avanzati.

Ciao

Gentile sig. Spina,

credo che lei abbia preso un abbaglio, ed è un errore molto diffuso, o forse sono io che ho frainteso il suo post. E’ un concetto complesso ma provo ad esporlo.

Dato uno strumento di misura con una certa risoluzione di scala (lasciamo perdere precisione ed accuratezza, possiamo considerarle buone a piacimento), è assolutamente corretto nonchè indispensabile indicare per la media delle misure temporali dello stesso strumento, o per la media di misure spaziali di diversi strumenti simili, o per la combinazione dei 2 fattori concomitanti, una precisione nel riportare le misure maggiore, rispetto a quella dello strumento che ha fornito i dati. Lei mi pare si chieda il perchè, ma è in realtà la risposta è molto semplice. La misura dello strumento è una misura fisica di una certa quantità , detto al contrario è un dato assolutamente reale, è fisica! L’operazione matematica di media svincola le misure dal significato fisico, ed il numero che viene fuori non ha alcun significato fisico, in generale nessuna media ha un significato fisico reale (anche se tutti lo dimenticano), il concetto di media serve solo alla mente umana per riuscire a manipolare meglio le informazioni, ma nella mente umana inizia e nella mente umana finisce.

Se lei ha due quantità fisiche reali che nel suo metro campione (arbitrario) sono 0.1 e 0.2 la media tra le due misure è 0.15, e come vede magicamente è apparsa una cifra decimale in più, ma attenzione nel mondo reale non esiste nessuna quantità fisica reale di 0.15, è solo una quantità matematica che serve a noi per analizzare in una volta sola due quantità diverse. Se noi arrottondassimo ad una cifra decimale, ad esempio a 0.2, avremmo una perdita di informazione sul sistema reale, ovvero all’esatto opposto di quanto afferma lei, per questo bisogna tenere più cifre decimali rispetto agli strumenti che danno origine ai numeri; e non vedo come il teorema del limite centrale, nel senso da lei illustrato, la aiuti in questo senso, anzi se lo analizza bene vedrà che le conferma quanto le dico.

Non voglio fare un commento troppo lungo ma credo che un esempio pratico sia utile. Diciamo che la temperatura media del pianeta sia 15 gradi, se lei calcola l’energia emessa per radiazione in un secondo per la superficie terrestre totale ottiene un certo valore, ma se lei divide la terra in 2 parti con temperature diverse, ma con media 15 gradi e poi calcola la somma di energia raggiante emessa dalla terra vedrà che è maggiore nel secondo caso, proprio perchè il concetto di media non ha alcun significato fisico, e per questo motivo è giusto il metodo usato attualmente per il calcolo della temperatura media, se si diminuissero le cifre decimali si perderebbe informazione sul sistema.

Spero si esser stato chiaro.

Se ho frainteso me lo dica pure.

Saluti

Mi piace la sua risposta. Posso chiederle cosa ne pensa della temperatura media del pianeta ? Questa è un concetto che mi angustia molto, perché è di comprensione immediata. Chiunque capisce cosa voglia dire.

Ma, se andiamo più in profondità , cominciano i dolori. Credo che una persona come Lei possa aiutarmi a chiarire alcuni dubbi.

Cercherò di essere chiaro.

Essendo una media, ovviamente non c’è un posto fisico dove misurarla, come esemplarmente chiarito da Lei.

Una media dipende dal campione di dati da cui la calcolo.

Come faccio dunque a essere ragionevolmente sicuro che questo campione sia rappresentativo del pianeta ?

Come faccio a essere sicuro che il campione scelto non sia “criticabile” o addirittura “fuorviante” ?

La ringrazio in ogni caso, della sua eventuale risposta.

La domanda che mi fa meriterebbe lunghe e complicate discussioni, ma alcune parole si possono spendere lo stesso.

Quello che interessa a livello climatico è il contenuto di energia del sistema, e quel che interessa a livello di cambiamento climatico è il cambiamento di energia del sistema; la CO2 ad esempio intrappola l’energia, non certo la temperatura. Qualcuno potrebbe chiedersi perché usiamo allora la temperatura per monitorare il sistema (in molti hanno proposto sistemi alternativi e migliori)? la usiamo perché è difficile misurare l’energia! Si usa la temperatura perché c’è una relazione molto semplice della meccanica statistica che lega la temperatura del gas ideale al contenuto energetico del gas, inoltre in un sistema termodinamicamente chiuso (significa che scambia solo energia con l’esterno ma non materia) ad una variazione di temperatura corrisponde una proporzionale variazione di energia.

Possiamo a grandissime linee trovare 2 grossi problemi principali.

Primo grosso problema, in una capannina l’atmosfera misurata non è un sistema chiuso ma aperto e quindi il calcolo della variazione di energia della massa d’aria è molto complesso ed il concetto di variazione di temperatura è solo ingannevole.

Secondo grosso problema, la rete di termometri (ingannevoli) non è omogenea sulla terra.

Il secondo problema apre una marea di ulteriori altri problemi di natura fisica e matematica che si riconnettono con l’argomento del post.

Come ho detto il concetto di temperatura media non ha un significato fisico reale, anzi per non ingannarci col concetto di temperatura che misuriamo in giardino potremmo moltiplicarlo per una costante in modo da svincolarci psicologicamente dal significato fisico familiare. Quel che realmente ci interessa è costruire matematicamente quel numero che chiamiamo temperatura media in modo tale che ad una variazione di esso corrisponda una proporzionale variazione del contenuto di energia del sistema climatico…e qui vengono le grane.

La media delle temperature viene fatta mediante algoritmi matematici complessi, e pesando i valori delle temperature per coprire le lacune delle stazioni termometriche nei luoghi sperduti, ed anche per omogeneizzare le temperature delle terre emerse e dei mari ed oceani e tanto altro ancora. La media finale poi viene fatta da medie locali su scale sempre più grandi fino ad arrivare ad un’immaginaria suddivisione a griglie del mondo. Il problema di tutti questi passaggi è che se si calcolano male i “pesi†da inserire per costruire la media, ad una variazione del valore medio finale della temperatura non corrisponde affatto una proporzionale variazione del contenuto di energia del sistema climatico, o detto al contrario ad una normale variazione di energia del sistema climatico non è possibile associare né in quantità ne in verso una proporzionale variazione della temperatura media terrestre! Ma c’è anche di peggio, a parità di energia del sistema climatico ma con una semplice redistribuzione del contenuto di energia (ad esempio data da una variazione dei flussi di vapore), la media della temperatura cambia mostrando una cambiamento climatico che in realtà non esiste.

Spero di esser stato chiaro almeno come succo dei concetti.

La saluto cordialmente.

La ringrazio molto per la risposta.

Non so come la pensino gli altri, ma io personalmente trovo l’argomento molto interessante, e mi piacerebbe approfondirlo.

Credo che a questo proposito sia interessante quanto scrivono Kevin E. Trenberth e John T. Fasullo qui

http://www.cgd.ucar.edu/cas/Trenberth/trenberth.papers/Tracking%20Energyv5.pdf

Quello che vorrei capire è la prima parte della prima frase

“If we can measure the net radiative incoming or outgoing energy at the top-of-atmosphere (TOA),” (la frase continua)

anzi, vorrei capire solo il senso di quel “if”

Grazie.

Vorrei chiarire meglio i termini della mia perplessità , e quindi della mia domanda.

Premetto che dopo il caso di Chris Landsea non mi fido molto di Kevin Trenberth, per quanto goda di grande prestigio ed autorità .

Ora, tutto il ragionamento di quello scienziato si basa, per quel che capisco io, sull’affermazione che manchi all’appello una grande quantità di energia.

Il punto che vorrei chiarire è quale fondamento abbia l’idea che quella quantità che lui afferma mancare esista davvero.

Cioè, si tratta di una quantità misurata ? E come ? O si tratta di una quantità dedotta, prevista, calcolata, ipotizzata da qualche teoria, o da qualche ragionamento ?

Ecco dove mi scombussola quell’if.

Perché se quell’energia che manca all’appello fosse solo frutto dell’AGWT, allora la sua mancanza potrebbe essere frutto della sua inesistenza, semplicemente.

Diverso sarebbe il caso in cui quell’energia fosse stata effettivamente misurata (sia pure attraverso misure di temperatura).

Non mi convince il fatto che un’energia termica imagazzinata per effetto serra vada a rintanarsi nelle profondità degli oceani, sdegnandone la superficie. Mi sembra poco credibile, anche perché, nella mia ignoranza, sono convinto che le acque calde tendano a salire piuttosto che a scendere nelle profondità più abissali.

Grazie per la sua eventuale risposta, che mi farebbe molto piacere.

Tutto vero! E dopo tutti questi conti si arrivano a valori con errore inferiore a quelli attuali su una misura diretta di una semplice temperatura.

Meditate gente

Saluti

FAbio

Domanda interssante 🙂

In un sistema complesso come il corpo umano la temperatura media rappresentativa dello stato di salute del sistema può essere presa in uno di tre punti: ascella, bocca oppure …..(che è il più preciso). Se si mettessero sensori su tutto il corpo sarebbe solo un gran casino.

La risposta è scherzosa, ma una seria richiedeva molto più spazio.

Ciao

FAbio Spina

Riformulo la domanda in altro modo:

se misuro la percentuale di tifosi del Bari, posso prendere un campione di persone a Napoli, ed estrapolarlo per tutta l’Italia ?

Ottengo gli stessi risultati se il campione lo prendo a Bari ?

Ovvero, le medie sono influenzate dalla scelta del campione rappresentativo (tipo le stazioni meteorologiche artiche e antartiche…) ?

Perché io avrei qualche dubbio (ah, il solito negazionista…) sulla scelta dei dati che dovrebbero essere rappresentativi di questo strano concetto, così evidente, di media globale che non vuole entrarmi nella zucca (zuccone che non sono altro!)

Secondo me.

Quello che dici è giustissimo, nel mio post però volevo solo dire che pur se tutto fosse possibile, il solo errore strumentale impone delle incertezze che troppo spesso non sono dette.

Ciao

Gent.le Tore, è possibile che ho preso un abbaglio e per questo è bello “confrontarsiâ€, grazie della sua osservazione. Per sinteticità scriverò le cose molto sinteticamente e me ne scuso.

Partiamo dal fatto che ogni misura è affetta da un errore, non possiamo mai considerare precisione ed accuratezza buone a piacimento ma esiste sempre un limite di cui va informato chi legge il nostro dato. Nella Teoria di Gauss, la media è la miglior stima del valore quando misuro una grandezza varie volte ottenendo valori diversi tra loro per entità maggiori all’accuratezza dello strumento (altrimenti è inutile, se misuro la lunghezza di un tavolo con un centimetro del sarto metterò solo errore strumentale e non uso statistica). Nel suo esempio per dire che ha effettuato due misure 0.1 e 0.2 indicandole senza errore, siccome presuppongo che abbia scritto in notazione scientifica, mi sta contemporaneamente dicendo che Lei ha effettuato le misure con un accuratezza dei centesimi. Se scrivesse 0.10, anche se di nessun valore numerico, lo zero dal punto di vista fisico indicherebbe che la misura è stata effettuata con un’accuratezza al millesimo.

Quando fa la media, addiziona i valori e divide per due, questo vale per la grandezza e per gli errori. Se gli errori sono al centesimo ha un senso arrivare a 0.15, anche poi dovrei dare stima dell’incertezza.

Facciamo però l’ipotesi assurda che chi fa i conti non conosca questi problemi di stima della misura, quindi ha scritto 0.1 e 0.2 perché li legge sul visore (risoluzione) ma l’errore è 0.2 (ripreso dal PS del post di Filippo. Calcolo media valori e sul visore leggo 0.1500000000000, calcolo media errori (0.2+0.2)/2=0.2000000000, posso anche scrivere (0.15±0.2) ma è un assurdo, è come se dicessi che l’autovelox ha misurato 150Km/h con errore di 200Km/h, non ha valore fisico indicare le decine se l’ordine di grandezza è sulle centinaia. Qui errore e grandezza sono degli stessi ordini, ma se scrivessi (123.15±0.20)°C non avrebbe senso uguale perché hai misurato con un’accuratezza dei decimi e quello che scrivi sui centesimi è solo matematica. Peggior ancora sarebbe andare a confrontare medie come queste dell’esempio che differiscono per la cifra dei centesimi. Se voglio discutere dei centesimi debbo cambiare strumento di misura, prenderlo più accurato.

La media per fenomeni statistici è la miglior stima del valore vero, ha un significato fisico nella teoria di Gauss. Nel caso delle grandezze meteorologiche, sono meno significative perché di fronte a processi stocastici e non ha una semplice variabile statistica. La media è calcolata per eliminare la variabile tempo (con scelte assurde calendariali), assumendo senza dirlo così nei confronti che l’ipotesi che il valor vero è costante.

Del significato fisico di media forse ne discuteremo in un futuro post (grazie dell’idea), non è che le cifre possono essere diminuite o aumentate, debbono essere coerenti con il sistema di misura adottato. Esistendo sempre un errore strumentale esisterà sempre un’incertezza, speriamo in futuro sempre più piccola, ma non esistendo la “continuità dei dati†nell’equazioni che descrivono attualmente il sistema climatico, sempre in grado per la teoria di caos di ingigantirsi nel tempo e mandare a pallino le previsioni oltre il medio termine. L’informazione non si perde perché non c’era. A presto.

Ciao

Fabio S

La teoria dell’incertezza e la pratica della misura sono problemi assai ostici e complessi: e purtroppo a livello universitario spesso o sottovalutati (semplicemente non si studiano) o mal gestiti (vengono studiati fin troppo ma in maniera teorica e non applicati al campo pratico).

Vi sarebbero considerazioni su come si calcola l’incertezza, sulle cifre significative, sul concetto di compatibilità che sostituisce “nel mondo reale” il concetto di uguaglianza (non esistono quantità uguali, ma solo compatibili entro la relativa fascia d’incertezza) ecc.

Interessante la posizione di dire che il valore della temperatura non è “assoluto” né rappresentativo: ciò elimina il problema di fondo. Tuttavia, io preferisco dire: abbiamo numerosi indizi che almeno una parte significativa del pianeta si sia scaldata sensibilmente, ma il fatto di misurare scientificamente e tecnicamente tale riscaldamento è tutt’altra cosa ed al momento probabilmente poco realistico.

Vi è anche da dire che le misure di temperatura non sono puri dati statistici, dato non possiamo postulare né che siano casuali né che siano collegati, ma ogni dato andrebbe analizzato a sè stante.

Condivido l’affermazione e quanto dici, infatti l’organizzazione mondiale per la meteorologia definiva solo il “climatic hange” relativo alla misura locale e non aveva mai pensato di dare un valore globale rappresentativo. Il cambio di definizione in “climate change” avvenne alla conferenza di Rio del 1992 e poi l’IPCC ha cambiato ulteriormente la definizione (lo trovi mi sembra nel glossario del summary).

Saluti

Forse quelli del NOAA stanno parlando della temperatura media percepita, più facile da misurare e comparare, affetta da minori errori strumentali e/o disturbi….

Quelli della NOAA parlano di temperatura media globale, che viene fuori dai calcoli dei loro computer. La temperatura percepita è calcolata da una combinazione di altre grandezze ognuna misurata con una propria incertezza, occorre applicare la “propagazione dell’errore†e non credo che l’incetezza diminuisca.

Grazie

Fabio S

Sono anni che lo ripeto: non avendo però mai scritto articoli a riguardo, devo fare i miei complimenti per quello che mi sembra il primo vero tentativo (almeno in Italia) di far luce su cosa sia la “misura” in campo meteorologico e climatologico!

Purtroppo molti, da sempre ed anche ai più alti livelli, non sanno che nella misura sono compresi sia il valore che l’incertezza…ma anche sapendolo, nessuno saprebbe distinguere due misure compatibili o due misure realmente differenti!

Aggiungerei solo uno spunto: l’incertezza non deve comunque limitarsi a quella strumentale, che è comunque la prima da considerare, ma deve includere TUTTI i possibili fattori di disturbo.

Però se lo dici, ti rispondono che grazie a complessi calcoli si diminuisce l’errore…su questo genere di misure, non mi risulta (nella mia piccolissima conoscenza ed esperienza) nulla del genere: l’incertezza complessiva è sempre >= a quella strumentale (un eventuale errore sistematico va poi calcolato nel metodo o nell’ambiente di misura, se fosse nello strumento io eviterei anche di usarlo); invece, in misure come quelle con GPS, si possono creare reti per correzioni differenziali, ma siamo in un campo diverso (non mi sembra si facciano correzioni differenziali tra termometri: anche perché, sarebbe difficile farle, e sarebbe anche senza senso dato che ogni luogo termicamente fa storia a sè).

P.S. con una strumentazione da migliaia di euro non si riesce a misurare la temperatura di una stanza a meno di ±0.2°C…

Grazie per l’intervento, nel P.S finale riporti quella che dovrebbe essere l’esperienza di tutti con cui iniziare a fare delle riflessioni. Che l’errore sulla misura è sempre maggiore ed uguale a quella strumentale lo metto tra le definizioni a fine post riprese dalla normativa ISO/WMO guida8.

Qui si tratta di semplici misure dirette, niente a che vedere con misure differenziali del GPS, come scrivi giustamente te.

A presto

Fabio Spina

Parentesi: le misure differenziali GPS non correggono comunque l’errore strumentale, cioè quello dei 4 orologi atomici di bordo di ogni satellite (errore sui nanosecondi), ma errori dovuti all’ambiente atmosferico come quello ionosferico (che rappresenta in genere l’80-90% dell’errore totale di una misura GPS).

[…] This post was mentioned on Twitter by Climatemonitor. Climatemonitor said: Nuovo articolo, Dall'universo della precisione all'epoca dell'illusione – http://tinyurl.com/y7p6nv2 […]